L’exploitation des données de recherche internet pour anticiper les crises sanitaires représente un défi technologique majeur du XXIe siècle. Alors que Google traite quotidiennement environ 20 pétaoctets de données, les requêtes saisies par des millions d’utilisateurs constituent potentiellement un indicateur précoce des préoccupations sanitaires collectives. Cette approche révolutionnaire, initiée par le projet Google Flu Trends en 2008, avait suscité d’immenses espoirs avant de connaître un échec retentissant six ans plus tard. Aujourd’hui, l’intelligence artificielle et l’amélioration des modèles linguistiques relancent cette perspective d’anticipation épidémiologique.

L’évolution historique des modèles prédictifs basés sur les données de recherche

Dans les années 2000, alors qu’un cinquième seulement de la population mondiale utilisait internet, des chercheurs de Google avaient développé un outil révolutionnaire baptisé Google Flu Trends. Cette initiative s’inscrivait dans le cadre philanthropique de Google.org et reposait sur une hypothèse séduisante : dès l’apparition des premiers symptômes grippaux, les internautes utiliseraient massivement le moteur de recherche pour s’informer sur leurs symptômes.

Le concept paraissait logique et novateur. Les emails, données de navigation via Maps, recherches Google ou YouTube généraient déjà des milliards d’informations utilisées par l’entreprise pour affiner ses services. L’idée consistait à exploiter cette manne de données pour détecter précocement l’évolution des syndromes grippaux au sein d’une population donnée.

Cependant, en mars 2014, moins de six ans après le lancement, Google annonçait l’arrêt définitif de GFT. Une étude indépendante avait révélé que le modèle s’était « trompé de très loin lors de la saison grippale 2011-2012 » et avait commis des erreurs à la hausse pour 100 des 108 semaines depuis août 2011. En février 2013, le modèle avait prédit deux fois plus de cas qu’observés et s’était révélé incapable d’anticiper la pandémie de grippe A de 2009.

Les défaillances méthodologiques du premier modèle

L’échec du GFT est aujourd’hui considéré comme l’un des cas d’étude les plus représentatifs des limites des algorithmes prédictifs. Le modèle présentait plusieurs failles méthodologiques majeures qui illustrent parfaitement les défis posés par les crises globales et leurs répercussions complexes.

| Type d’erreur | Description | Impact sur les prédictions |

|---|---|---|

| Confusion saisonnière | Sélection automatique de requêtes comme « basketball au lycée » | Corrélations fallacieuses sans lien médical |

| Biais de recherche | Difficulté à distinguer malades et curieux | Surestimation des cas réels |

| Volatilité temporelle | Variations imprévisibles des comportements de recherche | Prédictions erratiques |

- L’algorithme sélectionnait automatiquement des mots-clés supposés liés aux états grippaux

- Les coïncidences saisonnières étaient interprétées comme des corrélations médicales

- La distinction entre personnes malades et simples curieux s’avérait impossible

- Les variations comportementales des utilisateurs perturbaient constamment le modèle

Les nouvelles approches technologiques avec l’intelligence artificielle

L’année dernière, deux chercheurs de Google ont publié un article présentant deux techniques révolutionnaires susceptibles de relancer l’intérêt pour la prédiction épidémiologique basée sur les données de recherche. Ces innovations s’appuient sur les avancées récentes de l’intelligence artificielle et des modèles linguistiques pré-entraînés.

La première technique, baptisée SLaM (Search Language Model Compression), permet de quantifier les termes de recherche à l’aide de modèles linguistiques sophistiqués. Cette technologie, déjà utilisée dans le domaine de l’IA automobile, offre une approche plus nuancée de l’analyse sémantique des requêtes utilisateur.

CoSMo : un modèle d’estimation des événements réels

La seconde innovation, CoSMo, constitue un modèle permettant d’estimer des événements du monde réel en utilisant uniquement des données de recherche. Cette approche révolutionnaire pourrait transformer la manière dont les organismes de santé publique anticipent les crises sanitaires.

Les institutions françaises comme Santé publique France, l’Institut Pasteur ou l’Inserm pourraient bénéficier de ces avancées technologiques. L’intégration de ces outils avec les plateformes existantes comme Doctolib ou les systèmes de l’AP-HP ouvrirait des perspectives inédites de surveillance épidémiologique.

| Technologie | Principe de fonctionnement | Applications potentielles |

|---|---|---|

| SLaM | Compression des modèles linguistiques | Analyse sémantique des recherches médicales |

| CoSMo | Estimation d’événements réels via données de recherche | Prédiction épidémiologique en temps réel |

| Google Trends | Analyse des tendances de recherche | Surveillance des préoccupations sanitaires |

- Les grands modèles de langage améliorent la compréhension contextuelle des requêtes

- La qualité et la diversité des données d’entraînement déterminent l’efficacité du système

- L’évitement des raccourcis et corrélations superficielles devient prioritaire

- L’intégration avec les systèmes de santé existants multiplie les possibilités

L’intégration avec les systèmes de santé publique français

L’exploitation des données de recherche Google pour l’anticipation sanitaire nécessite une collaboration étroite avec les institutions françaises de santé publique. Le CNRS et l’Anses développent déjà des modèles prédictifs qui pourraient bénéficier de ces innovations technologiques.

L’Assurance Maladie dispose d’une base de données considérable sur les consultations médicales, les prescriptions et les arrêts de travail. L’intégration de ces informations avec les tendances de recherche Google via Google Trends pourrait créer un système d’alerte précoce d’une efficacité inégalée.

Collaboration internationale et normes OMS

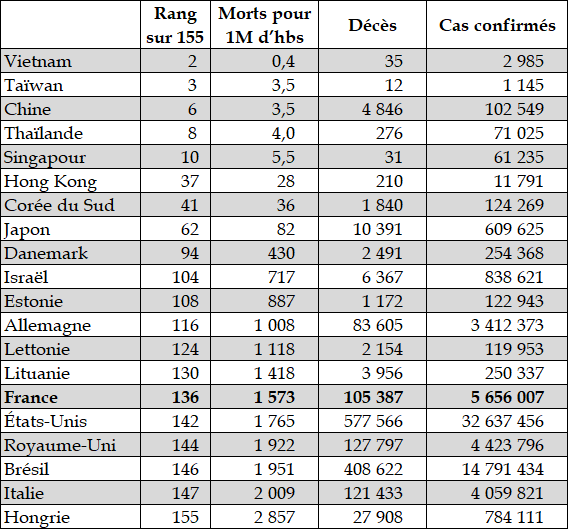

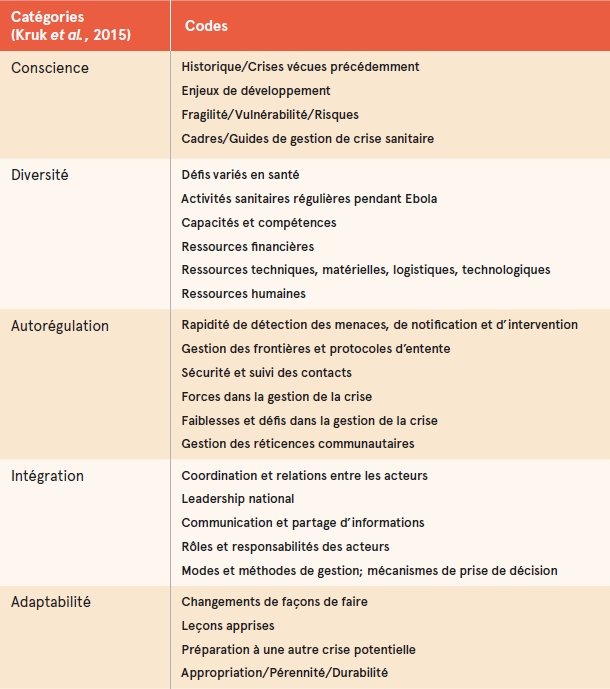

L’OMS encourage le développement de systèmes de surveillance épidémiologique innovants, particulièrement depuis la pandémie de COVID-19. Les recommandations internationales soulignent l’importance de la diversification des sources de données pour améliorer la détection précoce des menaces sanitaires, comme le montre l’analyse des impacts globaux des crises persistantes.

Les plateformes comme Doctolib génèrent quotidiennement des millions de données sur les prises de rendez-vous médicaux. L’analyse de ces informations, combinée aux tendances de recherche, pourrait révéler des patterns précurseurs d’épidémies localisées.

| Institution | Type de données | Potentiel d’intégration |

|---|---|---|

| Santé publique France | Surveillance épidémiologique | Corrélation avec tendances de recherche |

| Assurance Maladie | Consultations et prescriptions | Validation des prédictions algorithmiques |

| AP-HP | Admissions hospitalières | Détection précoce des pics d’activité |

| Doctolib | Prises de rendez-vous | Analyse comportementale des patients |

- La standardisation des protocoles de partage de données reste cruciale

- La protection de la vie privée constitue un enjeu majeur

- L’interopérabilité entre systèmes nécessite des investissements techniques

- La formation des professionnels de santé aux nouveaux outils devient indispensable

Les défis éthiques et techniques de la surveillance numérique sanitaire

L’exploitation des données de recherche pour la surveillance sanitaire soulève des questions éthiques fondamentales concernant la vie privée et l’utilisation des informations personnelles. Les utilisateurs effectuant des recherches sur leurs symptômes n’imaginent pas nécessairement que ces données pourraient être utilisées à des fins de surveillance épidémiologique.

La réglementation européenne RGPD impose des contraintes strictes sur l’utilisation des données personnelles, même anonymisées. Les algorithmes de prédiction doivent respecter ces exigences tout en conservant leur efficacité prédictive, un équilibre délicat à maintenir.

Biais algorithmiques et représentativité des données

Les recherches Google ne reflètent pas nécessairement l’ensemble de la population. Les inégalités d’accès au numérique, les différences générationnelles et socio-économiques introduisent des biais importants dans les données collectées. Ces distorsions peuvent compromettre la fiabilité des prédictions, particulièrement pour certaines catégories de population.

L’impact de ces biais rappelle l’importance de considérer les impacts systémiques des technologies sur différents groupes sociaux et leur accès aux services de santé.

| Défi technique | Impact sur les prédictions | Solutions envisagées |

|---|---|---|

| Biais socio-économiques | Sous-représentation de certaines populations | Pondération des données par catégories |

| Fracture numérique | Exclusion des populations moins connectées | Intégration de sources de données diversifiées |

| Variations comportementales | Instabilité des patterns de recherche | Modèles adaptatifs et apprentissage continu |

| Anonymisation | Perte d’informations contextuelles | Techniques de privacy-preserving machine learning |

- La transparence des algorithmes devient une exigence démocratique

- L’audit régulier des modèles prédictifs est nécessaire

- La participation citoyenne aux choix technologiques doit être encouragée

- Les garde-fous techniques et juridiques doivent évoluer avec la technologie

Perspectives d’avenir et applications pratiques émergentes

L’avenir de la prédiction épidémiologique basée sur les données de recherche s’oriente vers une approche multimodale intégrant diverses sources d’information. Les réseaux sociaux, les données de mobilité, les informations météorologiques et les indicateurs économiques pourraient enrichir les modèles prédictifs actuels.

Les innovations en intelligence artificielle ouvrent des perspectives fascinantes pour la détection précoce des crises sanitaires. L’analyse des sentiments dans les recherches, la reconnaissance de patterns complexes et l’adaptation en temps réel aux évolutions comportementales transforment radicalement les capacités prédictives.

Applications pratiques en développement

Plusieurs projets pilotes explorent l’utilisation des données de recherche pour anticiper différents types de crises sanitaires. Au-delà des épidémies traditionnelles, ces systèmes pourraient détecter les pics de pollution, les vagues de chaleur ou les épisodes de stress collectif, comme l’illustrent les défis sociaux contemporains nécessitant des réponses coordonnées.

L’intégration avec les systèmes d’alerte existants pourrait créer des réseaux de surveillance sanitaire d’une efficacité inédite. La collaboration entre institutions publiques, entreprises technologiques et organisations internationales devient cruciale pour le développement de ces outils.

| Application émergente | Données exploitées | Bénéfices attendus |

|---|---|---|

| Détection des vagues de chaleur | Recherches liées à la climatisation, hydratation | Alerte précoce des services d’urgence |

| Surveillance de la santé mentale | Recherches sur stress, anxiété, dépression | Mobilisation des ressources psychologiques |

| Prédiction des intoxications alimentaires | Recherches sur symptômes digestifs par zone | Identification rapide des sources de contamination |

| Monitoring des allergies saisonnières | Recherches sur pollens et antihistaminiques | Prévision des pics allergiques |

- L’interopérabilité entre systèmes nationaux et internationaux s’améliore

- Les modèles prédictifs deviennent plus précis et spécialisés

- L’intégration temps réel avec les services de santé se développe

- La personnalisation des alertes selon les profils de risque progresse

L’évolution vers des systèmes de surveillance sanitaire intelligents représente un enjeu majeur pour les années à venir. Ces outils pourraient révolutionner notre capacité d’anticipation face aux crises sanitaires, à condition de surmonter les défis techniques, éthiques et organisationnels qui subsistent. La réussite de cette transformation dépendra largement de notre capacité à tirer les leçons des échecs passés tout en exploitant le potentiel des nouvelles technologies, comme le montrent les approches innovantes développées dans d’autres domaines d’action collective.

Questions fréquemment posées

Comment Google peut-il prédire les épidémies grâce aux recherches internet ?

Google analyse les requêtes liées aux symptômes et aux maladies pour identifier des patterns qui précèdent généralement les pics épidémiques. L’intelligence artificielle permet aujourd’hui de distinguer plus efficacement les recherches pertinentes des simples curiosités, contrairement aux premiers modèles qui avaient échoué entre 2008 et 2014.

Quelles sont les principales limites des modèles prédictifs basés sur les données de recherche ?

Les principales limites incluent les biais socio-économiques (tous les groupes de population n’utilisent pas internet de la même manière), les corrélations fallacieuses (confusion entre coïncidences saisonnières et liens médicaux réels), et les défis de protection de la vie privée imposés par la réglementation RGPD.

Pourquoi le projet Google Flu Trends a-t-il échoué ?

Google Flu Trends a échoué principalement à cause d’erreurs méthodologiques : l’algorithme sélectionnait automatiquement des mots-clés sans rapport médical réel (comme « basketball au lycée » qui augmentait en même temps que la saison grippale), et ne parvenait pas à distinguer les personnes réellement malades des simples curieux.

Les nouvelles technologies d’IA peuvent-elles résoudre les problèmes des anciens modèles ?

Les techniques SLaM et CoSMo développées récemment par Google offrent des approches plus sophistiquées pour analyser les données de recherche. Ces modèles linguistiques pré-entraînés permettent une meilleure compréhension contextuelle des requêtes et évitent certains biais des algorithmes précédents.

Comment les institutions françaises de santé pourraient-elles utiliser ces outils ?

Les organismes comme Santé publique France, l’Institut Pasteur ou l’AP-HP pourraient intégrer les données de Google Trends avec leurs systèmes de surveillance existants. Cette combinaison permettrait de créer des systèmes d’alerte précoce plus efficaces, particulièrement utiles pour détecter les épidémies localisées ou les pics d’activité hospitalière.