Google Discover, ce flux personnalisé qui apparaît sur les smartphones Android et dans l’application mobile du géant californien, est devenu en l’espace de quelques années la première porte d’entrée vers l’information pour des millions d’utilisateurs. Pourtant, une enquête récente révèle une réalité troublante : près de 20 % des sites les plus recommandés par cet algorithme seraient en réalité générés intégralement ou partiellement par intelligence artificielle. Ces plateformes, souvent dépourvues de journalistes, multiplient les contenus trompeurs et les infox dans le seul but de capter du trafic et d’engranger des revenus publicitaires massifs.

L’ampleur du phénomène interroge. Alors que Google Discover représente désormais près de 70 % des clics redirigeant vers les médias français, cette infiltration massive de contenus automatisés menace l’écosystème de l’information. Derrière ces faux sites d’actualité se cachent des entrepreneurs du référencement qui ont compris comment manipuler l’algorithme de Google pour transformer des articles générés en quelques secondes en véritables machines à cash.

Cette situation soulève des questions essentielles sur la responsabilité des plateformes technologiques dans la diffusion de l’information. Google, qui tire profit de ce système via ses propres régies publicitaires comme AdSense, se retrouve dans une position ambiguë de juge et partie. Pendant ce temps, les médias traditionnels, soumis à des contraintes éthiques et financières autrement plus lourdes, se retrouvent en concurrence déloyale avec ces fermes à contenus industrialisées. L’enquête du site Next, basée sur l’analyse de près de 1 000 sites recommandés par Discover et confrontée à une base de données de 7 250 sites identifiés comme générés par IA, met en lumière un système qui profite avant tout aux acteurs les moins scrupuleux du web.

L’infiltration massive des contenus automatisés dans Google Discover

L’analyse menée par le journaliste d’investigation Jean-Marc Manach dévoile une réalité méconnue du grand public : 18 % des sites régulièrement propulsés par Google Discover fonctionnent grâce à l’intelligence artificielle générative. Ces plateformes ne ressemblent en rien aux médias traditionnels. Elles publient quotidiennement des centaines, voire des milliers d’articles, sans aucune relecture humaine ni vérification factuelle. L’objectif n’est pas d’informer, mais de capter l’attention pour générer du clic.

Pour établir ce constat, l’enquête s’est appuyée sur GNewsalyzer, un outil de surveillance du trafic de Google News et Discover. La base de données compilée recense environ 1 000 sites ayant été recommandés plus de dix fois par l’algorithme. En croisant ces données avec les 7 250 sites identifiés comme générés par IA, le constat est sans appel : une proportion inquiétante de contenus automatisés parvient à se frayer un chemin jusqu’aux écrans des utilisateurs. Cette infiltration ne concerne pas uniquement des sites marginaux, mais aussi des plateformes générant plusieurs millions de visites mensuelles.

Le fonctionnement de ces sites repose sur une mécanique bien rodée. Des outils comme ChatGPT, les API d’OpenAI ou d’autres générateurs de texte produisent en masse des articles aux titres accrocheurs. Ces contenus sont ensuite publiés automatiquement sur des sites au design sommaire, mais suffisamment crédibles pour tromper l’algorithme de Google. Les images, souvent générées par des IA comme DALL-E ou Midjourney, accompagnent ces textes et renforcent l’illusion d’un véritable média d’information.

Des fermes à contenus industrialisées et organisées

Derrière cette prolifération se cachent de véritables entrepreneurs du spam. Jean-Marc Manach a identifié environ 150 éditeurs spécialisés dans ce type de production. Certains opèrent seuls, en tant qu’autoentrepreneurs, tandis que d’autres ont structuré de véritables entreprises employant jusqu’à une vingtaine de personnes. Ces acteurs maîtrisent parfaitement les techniques de référencement naturel (SEO) et exploitent les failles de l’algorithme de Google Discover pour maximiser leur visibilité.

L’un des cas les plus emblématiques est celui de Julien Jimenez, gérant de plusieurs dizaines de sites qui publient collectivement plusieurs milliers d’articles par jour. Parmi ses plateformes figure decontair-67.fr, qui a été recommandée au moins 325 fois en une seule semaine. Les articles publiés relèvent souvent de la désinformation pure, comme celui titré « Canicule extrême : un refuge pour chiens en Île-de-France investit dans une piscine à glaçons ». Illustré par des images générées par IA montrant des chiens dans une piscine remplie de glace, ce type de contenu est conçu pour susciter l’émotion et l’engagement, sans aucune base factuelle.

- Automatisation totale : utilisation d’API pour générer et publier des articles sans intervention humaine

- Titres sensationnalistes : exploitation de sujets anxiogènes (climat, santé, sécurité) pour maximiser les clics

- Images artificielles : recours systématique aux générateurs d’images pour illustrer des scénarios fictifs

- Absence de vérification : aucun processus éditorial ni relecture avant publication

- Rotation rapide des domaines : création de nouveaux sites dès qu’un ancien est blacklisté par Google

Cette industrialisation du faux contenu s’apparente davantage à une chaîne de production qu’à une activité éditoriale. Les sites sont conçus pour exister quelques semaines, le temps de générer un maximum de trafic, avant d’être remplacés par de nouveaux domaines. Lorsque decontair-67.fr a été désindexé par Google après deux semaines d’exposition intensive, son successeur amios.fr a immédiatement pris le relais, apparaissant en moyenne 107 fois par jour entre le 13 et le 28 août dernier.

Comment l’algorithme de Discover favorise ces contenus

Le succès de ces sites repose sur une compréhension fine du fonctionnement de Google Discover et son algorithme basé sur l’engagement. Contrairement au moteur de recherche traditionnel Google Search, qui analyse la pertinence du contenu, Discover fonctionne selon une logique différente. L’algorithme privilégie les interactions des utilisateurs avec le titre, la photo et le nom de domaine. Le contenu de l’article lui-même importe finalement peu dans le processus de recommandation initial.

Cette mécanique transforme Discover en ce que certains professionnels du SEO appellent désormais le « TikTok de Google » : une plateforme optimisée pour l’addiction et l’engagement immédiat plutôt que pour la qualité informative. Les éditeurs de contenus IA l’ont bien compris et exploitent cette caractéristique en créant des titres ultra-accrocheurs associés à des visuels chocs. Peu importe que l’article soit truffé d’erreurs ou d’informations inventées, tant que le trio titre-image-domaine génère des clics.

| Critère | Google Search | Google Discover |

|---|---|---|

| Base d’évaluation | Pertinence du contenu et autorité du domaine | Engagement utilisateur (clics, temps passé) |

| Importance du titre | Moyenne | Critique |

| Poids de l’image | Faible | Très élevé |

| Analyse du contenu | Approfondie | Superficielle |

| Facteur temporel | Variable | Favorise la fraîcheur immédiate |

Cette différence fondamentale explique pourquoi des sites générés par IA parviennent à surperformer des médias établis sur Discover, alors qu’ils auraient beaucoup plus de difficultés à se positionner dans les résultats de recherche classiques. La plateforme crée ainsi un environnement favorable aux contenus sensationnalistes au détriment de l’information vérifiée et contextualisée.

Un modèle économique lucratif dopé par Google AdSense

Derrière la prolifération de ces contenus automatisés se cache une réalité financière incontournable : ce business est extrêmement rentable. Les témoignages recueillis auprès de professionnels du secteur révèlent des marges bénéficiaires exceptionnelles pour un investissement minimal. Clément Pesseaux, pionnier reconnu de l’édition de sites générés par IA, expliquait en mars dernier dans le podcast Clic qu’un site atteignant 100 000 à 200 000 visites quotidiennes peut générer entre 200 et 500 euros par jour.

En extrapolant ces chiffres sur un mois, cela représente un revenu potentiel de 15 000 euros mensuels pour un seul site. Certains éditeurs gèrent simultanément des dizaines de sites, multipliant ainsi leurs sources de revenus. L’enquête de Next révèle que deux éditeurs seraient même devenus millionnaires en seulement trois mois grâce à ce système. Une rentabilité quasi immédiate qui contraste violemment avec les modèles économiques précaires des médias traditionnels.

La principale source de ces revenus provient de Google AdSense, la régie publicitaire automatisée du géant américain. Ce système permet aux propriétaires de sites de diffuser des annonces ciblées et de percevoir une rémunération à chaque clic ou impression. Google fournit même des simulations indiquant qu’un créateur peut gagner jusqu’à 100 000 dollars lorsque son site atteint les 10 millions de visiteurs. Cette transparence sur le potentiel de gain encourage paradoxalement le développement de sites automatisés visant uniquement à maximiser le trafic.

Google : juge et partie dans ce système

La situation crée une contradiction majeure pour Google. D’un côté, l’entreprise se positionne comme gardienne de la qualité de l’information sur le web et prétend lutter contre les contenus trompeurs. De l’autre, elle tire directement profit de la monétisation de ces mêmes contenus problématiques via AdSense. Jean-Marc Manach résume cette ambiguïté : « Google est juge et partie, l’entreprise gagne de l’argent sur des contenus qu’elle met en avant. »

Cette dualité s’observe également dans la gestion d’autres plateformes de l’écosystème Google. YouTube, par exemple, a longtemps été critiqué pour sa monétisation de contenus complotistes ou de désinformation avant de durcir progressivement ses règles. Discover semble aujourd’hui reproduire le même schéma, avec un temps de retard dans la prise de conscience et l’application de mesures correctives. La différence notable réside dans le fait que contrairement à YouTube où les créateurs sont identifiables, les éditeurs de sites IA opèrent dans une relative opacité.

- Revenus publicitaires doubles : Google gagne à la fois sur la diffusion via Discover et sur la monétisation via AdSense

- Absence de responsabilité éditoriale : la plateforme se décharge de toute validation du contenu recommandé

- Incitations contradictoires : les outils de monétisation encouragent la création de sites à fort trafic, quelle que soit leur qualité

- Modération réactive plutôt que proactive : les sites problématiques sont retirés après signalement, pas avant leur diffusion

Face aux critiques, Google affirme que ses systèmes antispam excluent « 99 % des spams sur Google en général ». L’entreprise précise également que « le règlement Discover relatif au contenu interdit le contenu trompeur, manipulé et mensonger ». Pourtant, les faits démentent ces affirmations : si 18 % des sites recommandés sont automatisés et potentiellement trompeurs, cela signifie que les filtres actuels ne fonctionnent pas efficacement dans l’écosystème francophone.

La spéculation sur les noms de domaine expirés

Un phénomène parallèle illustre la valeur économique accordée à ces pratiques : l’explosion du prix des noms de domaine expirés. Lorsqu’un ancien site web cesse son activité et que son nom de domaine se libère, celui-ci conserve aux yeux de l’algorithme de Google une partie de sa crédibilité et de son autorité passée. Les éditeurs de contenus IA se sont engouffrés dans cette brèche, rachetant massivement ces domaines pour y publier leurs articles automatisés.

Autrefois vendus quelques dizaines d’euros sur des plateformes spécialisées, certains noms de domaine valent désormais des centaines, voire des milliers d’euros. Cette inflation témoigne de la rentabilité du modèle : même en payant un domaine plusieurs milliers d’euros, l’investissement peut être amorti en quelques semaines grâce aux revenus publicitaires générés. Cette course aux domaines crédibles crée un marché parallèle où d’anciens sites d’information locaux, d’associations ou de petites entreprises se retrouvent transformés en fermes à contenus IA.

| Type de domaine | Prix avant 2023 | Prix actuel | Raison de la valorisation |

|---|---|---|---|

| Ancien média local | 50-100 € | 500-2000 € | Crédibilité journalistique résiduelle |

| Site associatif établi | 20-50 € | 200-800 € | Historique de backlinks de qualité |

| Blog influent | 30-80 € | 300-1500 € | Autorité de domaine préexistante |

| Site commercial | 100-300 € | 1000-5000 € | Trafic résiduel et référencement |

Cette marchandisation des domaines pose une question éthique importante : elle détourne l’héritage numérique de projets légitimes au profit d’activités purement mercantiles. Un ancien site d’information locale qui avait patiemment construit sa réputation pendant des années peut ainsi se retrouver transformé du jour au lendemain en vecteur de désinformation, tout en bénéficiant de la confiance résiduelle associée à son nom.

Une concurrence déloyale qui menace l’écosystème médiatique

L’irruption massive de ces contenus automatisés dans Google Discover crée une distorsion de concurrence majeure au détriment des médias traditionnels. Vincent Berthier, responsable du bureau technologies et journalisme de Reporters sans frontières, qualifie cette situation de « concurrence déloyale ». Les sites générés par IA n’ont effectivement « absolument pas les mêmes coûts ni les mêmes modèles économiques que les médias traditionnels », souligne-t-il.

Cette différence se mesure à tous les niveaux de la chaîne de production. Un média classique emploie des journalistes salariés, investit dans des infrastructures techniques, respecte des normes déontologiques et assume des responsabilités légales. À l’inverse, un site automatisé peut fonctionner avec un seul opérateur, quelques abonnements à des APIs d’IA comme celles d’OpenAI ou de Microsoft (via Azure OpenAI Service), et un investissement minimal en hébergement web.

Le ratio coût-efficacité devient alors radicalement différent. Là où une rédaction doit débourser plusieurs milliers d’euros pour produire une dizaine d’articles de qualité, une ferme à contenus peut en générer des centaines pour quelques euros d’abonnement mensuel. Cette asymétrie transforme la compétition pour la visibilité en ligne en une bataille inégale où la qualité journalistique pèse moins que la capacité à saturer l’algorithme.

L’impact sur la visibilité des médias légitimes

Les conséquences de cette invasion se mesurent concrètement dans les statistiques de trafic des médias traditionnels. Selon l’Alliance de la presse d’information générale, sur les 821 millions de clics enregistrés par les médias en provenance de Google en décembre 2024, 69,3 % provenaient de Discover, 23 % du moteur de recherche classique et seulement 7,7 % d’autres sources. Cette dépendance massive à un seul canal de distribution rend les éditeurs particulièrement vulnérables aux dérives de l’algorithme.

Lorsque des centaines de sites automatisés monopolisent une partie significative des recommandations Discover, cela se traduit mécaniquement par une diminution de la visibilité des contenus journalistiques authentiques. Les médias légitimes se retrouvent en concurrence non seulement entre eux, mais aussi contre des machines capables de produire en volume des contenus calibrés pour plaire à l’algorithme. Cette situation rappelle les débats similaires qui agitent d’autres plateformes comme TikTok ou YouTube, où les créateurs de contenu authentique se plaignent régulièrement de la saturation par des contenus recyclés ou artificiellement optimisés.

- Dilution de l’audience : les lecteurs sont détournés vers des contenus sensationnalistes plutôt que vers de l’information vérifiée

- Baisse des revenus publicitaires : les médias traditionnels voient leur part du gâteau AdSense diminuer

- Érosion de la confiance : l’exposition répétée à de faux contenus dégrade la perception générale de l’information en ligne

- Course vers le bas : certains médias sont tentés d’adopter des pratiques similaires pour rester compétitifs

- Fragilisation économique : la baisse de trafic aggrave la précarité déjà importante des rédactions

Cette dynamique s’inscrit dans un contexte plus large de transformation du paysage médiatique. Les défis posés par l’IA aux sites d’information ne se limitent pas à la question du trafic, mais touchent aussi à la crédibilité même du journalisme professionnel. Lorsqu’un utilisateur ne peut plus distinguer un article rédigé par un journaliste d’un texte généré automatiquement, la valeur ajoutée du travail éditorial se trouve remise en question.

Les tentatives de riposte des acteurs traditionnels

Face à cette menace, les médias traditionnels cherchent des parades. Certains investissent massivement dans l’optimisation SEO pour Discover, adaptant leurs formats éditoriaux aux exigences de l’algorithme. D’autres tentent de diversifier leurs sources de trafic, en développant leur présence sur les réseaux sociaux comme Snapchat ou en investissant dans des newsletters. Quelques-uns explorent même l’utilisation contrôlée de l’IA pour assister leurs journalistes, à l’image d’outils comme NotebookLM de Google.

Plusieurs organisations professionnelles montent également au créneau. Reporters sans frontières a publié un communiqué le 11 juillet démontrant que les sites générés par IA sont souvent source de fausses informations. L’organisation plaide pour une régulation plus stricte et une responsabilisation accrue des plateformes. Certains syndicats de journalistes réclament quant à eux une intervention des autorités de la concurrence, estimant que la situation relève d’un abus de position dominante.

| Stratégie de riposte | Avantages | Limites |

|---|---|---|

| Optimisation SEO intensive | Améliore la visibilité immédiate | Risque de compromis éditoriaux |

| Diversification des sources | Réduit la dépendance à Google | Demande des investissements importants |

| Usage encadré de l’IA | Gains de productivité | Risque de brouillage des lignes éthiques |

| Actions en justice | Pourrait créer un précédent | Procédures longues et coûteuses |

| Label de qualité | Valorise les contenus vérifiés | Nécessite un soutien des plateformes |

Malgré ces efforts, la bataille reste déséquilibrée tant que les règles du jeu ne changent pas fondamentalement. Les médias traditionnels demandent notamment que Google intègre des critères éditoriaux dans son algorithme Discover, privilégiant les sources vérifiées et identifiables. Certains proposent même la création d’un système de certification, similaire aux badges de vérification sur les réseaux sociaux, qui permettrait aux lecteurs d’identifier instantanément les sources fiables.

Les insuffisances des systèmes de modération et de détection

Google assure que ses « systèmes antispams » nettoient efficacement les flux Discover et excluent « 99 % des spams sur Google en général ». Cette affirmation se heurte pourtant à la réalité constatée par les observateurs du secteur. Si près d’un site recommandé sur cinq est généré par IA, cela signifie que les filtres actuels ne parviennent pas à identifier et bloquer ces contenus problématiques avant leur diffusion massive.

Virginie Clève, spécialiste reconnue du référencement, estime que Google « ne prend pas la mesure de la gravité de la situation puisque le problème concerne particulièrement la France ». Selon ses observations, l’antispam de Discover fonctionnerait principalement de manière manuelle, avec des interventions espacées de 20 à 30 jours. Ce délai laisse largement le temps aux sites frauduleux de générer des millions de vues et des revenus conséquents avant leur éventuelle désindexation.

Un système de modération inadapté aux nouvelles tactiques

La modération par Google repose sur plusieurs mécanismes combinés : des algorithmes de détection automatique, des signalements d’utilisateurs et des interventions manuelles d’équipes dédiées. Toutefois, ces systèmes semblent dépassés par l’ingéniosité des éditeurs de contenus IA. Ces derniers ont développé des tactiques sophistiquées pour contourner les filtres : variation des structures de texte, rotation rapide des domaines, utilisation d’images suffisamment crédibles pour tromper les détections automatiques.

L’une des stratégies les plus efficaces consiste à créer un réseau de sites éphémères. Dès qu’un domaine est blacklisté, un nouveau prend immédiatement le relais, parfois en quelques heures. Cette rotation permanente transforme la modération en un jeu du chat et de la souris où Google se trouve systématiquement en position réactive. Les cas de decontair-67.fr et de son successeur amios.fr illustrent parfaitement cette mécanique : le premier disparaît de Discover après deux semaines, le second apparaît instantanément pour continuer l’exploitation.

- Détection tardive : les sites problématiques accumulent des millions de vues avant d’être identifiés

- Critères de filtrage dépassés : les IA génératives produisent des textes de plus en plus crédibles

- Manque de personnel : les équipes de modération sont insuffisantes pour traiter l’ampleur du phénomène

- Absence de pénalités dissuasives : les éditeurs blacklistés peuvent simplement créer de nouveaux sites

- Coordination internationale limitée : le problème francophone ne semble pas prioritaire pour Google

Cette situation rappelle les difficultés rencontrées par d’autres plateformes face aux contenus automatisés. Meta, avec Facebook et Instagram, a longtemps lutté contre les fermes à clics produisant des contenus viraux de faible qualité. Apple a dû nettoyer l’App Store de milliers d’applications générées automatiquement. Plus récemment, YouTube a intensifié sa lutte contre la désinformation, notamment celle générée ou amplifiée par l’IA. Google Discover semble aujourd’hui confronté aux mêmes défis, avec un temps de retard dans la mise en place de solutions efficaces.

Les limites techniques de la détection des contenus IA

Identifier automatiquement un contenu généré par IA devient de plus en plus complexe techniquement. Les modèles de langage comme ChatGPT, Gemini ou Claude produisent désormais des textes difficilement distinguables de ceux rédigés par des humains. Les outils de détection développés par diverses entreprises, y compris OpenAI elle-même, affichent des taux d’erreur significatifs, avec de nombreux faux positifs et faux négatifs.

Google a développé ses propres technologies de détection, notamment en analysant les patterns de publication, la cohérence du contenu et les signaux de comportement suspect. Mais ces systèmes se heurtent à plusieurs obstacles. D’abord, la frontière entre utilisation légitime de l’IA (comme assistant d’écriture) et génération automatisée pure devient floue. Ensuite, les éditeurs peu scrupuleux introduisent volontairement des variations et imperfections pour tromper les détecteurs. Enfin, l’impact de l’IA sur le SEO complexifie l’analyse, car certains contenus mixent habilement automatisation et révision humaine.

| Méthode de détection | Efficacité | Principales faiblesses |

|---|---|---|

| Analyse linguistique | Moyenne | Taux de faux positifs élevé |

| Patterns de publication | Bonne | Facilement contournée par rotation des sites |

| Vérification des sources | Faible | Manque d’automatisation possible |

| Signalements utilisateurs | Variable | Dépend de la vigilance du public |

| Analyse des images | Moyenne | Les générateurs d’images s’améliorent constamment |

Face à ces défis, certains experts suggèrent une approche différente : plutôt que de chercher à identifier tous les contenus IA, il faudrait établir un système de certification positive pour les contenus vérifiés. Un peu comme le futur de la recherche Google avec l’IA pourrait privilégier les sources authentifiées, Discover pourrait mettre en avant les éditeurs ayant démontré leur légitimité éditoriale. Cette inversion de logique permettrait de contourner les limites techniques de la détection automatique.

Perspectives et enjeux pour l’avenir de l’information en ligne

L’infiltration massive de contenus générés par IA dans Google Discover ne constitue que la partie émergée d’un phénomène plus vaste : la transformation profonde de l’écosystème informationnel à l’ère de l’intelligence artificielle générative. Les développements récents suggèrent que cette tendance va s’intensifier plutôt que s’atténuer dans les mois et années à venir. Google lui-même teste des fonctionnalités qui intègrent encore davantage l’IA dans Discover, notamment des résumés automatisés d’actualités compilés à partir de plusieurs sources.

Cette évolution soulève des questions fondamentales sur le futur du journalisme et de l’information en ligne. Si les algorithmes privilégient systématiquement les contenus optimisés pour l’engagement au détriment de la qualité factuelle, quel espace reste-t-il pour un journalisme d’investigation rigoureux ? Comment les médias traditionnels peuvent-ils survivre économiquement dans un environnement où ils sont structurellement désavantagés face à des machines produisant du contenu à coût marginal quasi nul ?

Les nouvelles fonctionnalités IA de Discover : aggravation ou solution ?

Google expérimente actuellement des résumés d’actualités générés par IA directement dans Discover. Ces encarts synthétisent plusieurs articles en quelques phrases, parfois présentés sous forme de listes à puces. L’objectif affiché par la firme californienne : maintenir l’utilisateur dans l’application Google en lui fournissant l’essentiel de l’information sans qu’il ait besoin de cliquer vers les sites sources.

Cette fonctionnalité inquiète profondément les éditeurs. Si les lecteurs obtiennent l’information directement via le résumé IA, ils n’auront plus de raison de visiter les sites originaux, privant ainsi les médias de trafic et donc de revenus publicitaires. Cette logique rappelle l’introduction des featured snippets dans Google Search, qui avait déjà suscité des controverses similaires. Mais avec Discover, l’impact pourrait être décuplé puisque ce canal représente désormais près de 70 % du trafic Google vers les médias français.

- Résumés automatisés : synthèse de plusieurs sources en quelques lignes, réduisant la nécessité de cliquer

- Agrégation multimédia : compilation d’images et de vidéos issues de différents sites

- Recommandations personnalisées : affinement continu des suggestions basé sur l’engagement utilisateur

- Format « stories » : présentation inspirée d’Instagram ou Snapchat pour maximiser l’engagement

- Contenu éphémère : mise en avant de l’actualité immédiate au détriment de l’analyse approfondie

Ces évolutions transforment Google d’un simple intermédiaire distribuant du trafic vers les sites en un consommateur direct de contenu qu’il réassemble et présente sous sa propre marque. Le parallèle avec la manière dont Google pourrait déstabiliser le web devient évident : en s’appropriant la valeur créée par les éditeurs tout en diminuant le trafic qu’il leur envoie, la plateforme risque de fragiliser l’ensemble de l’écosystème dont elle dépend pourtant.

Vers une régulation nécessaire du secteur

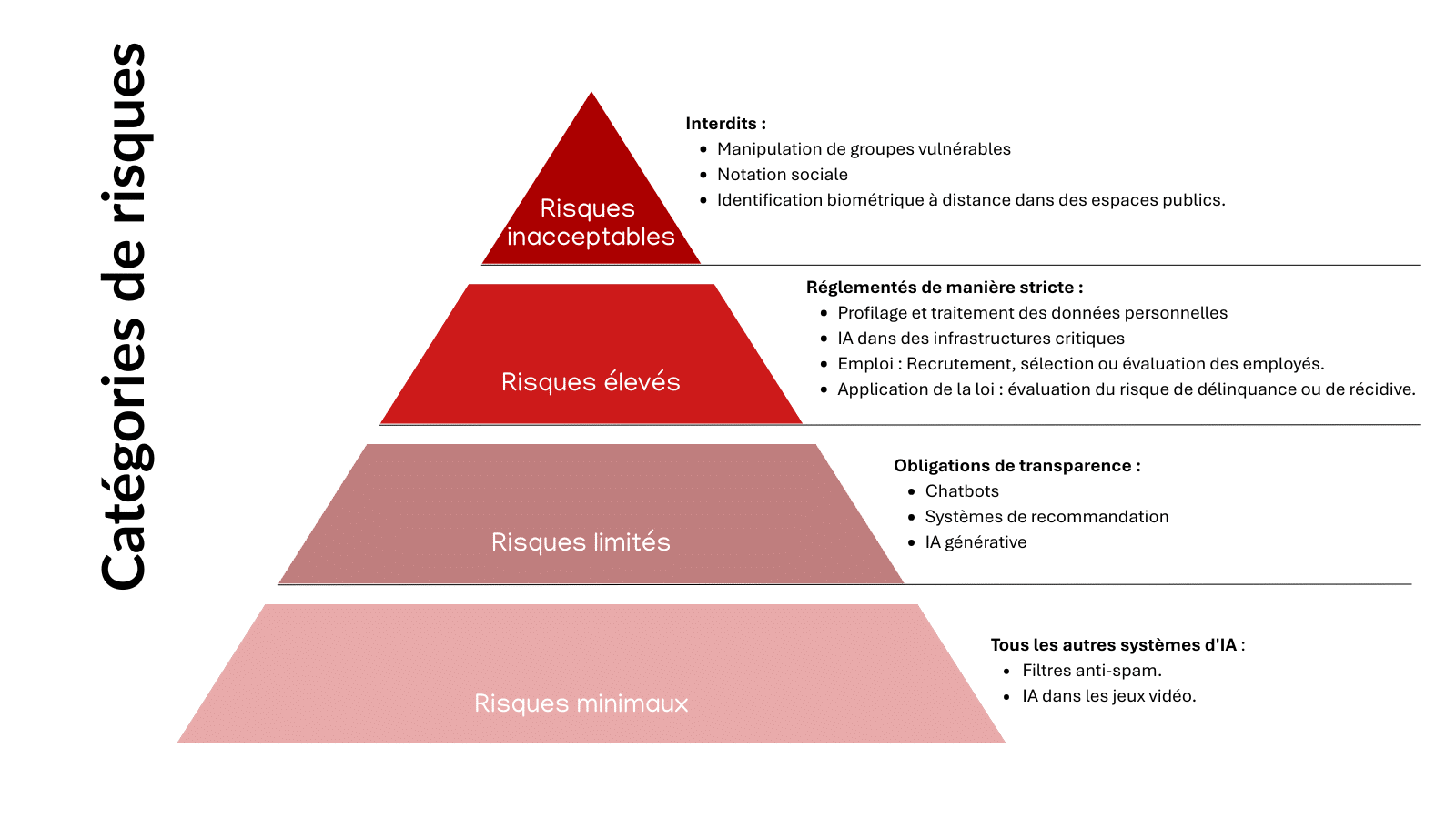

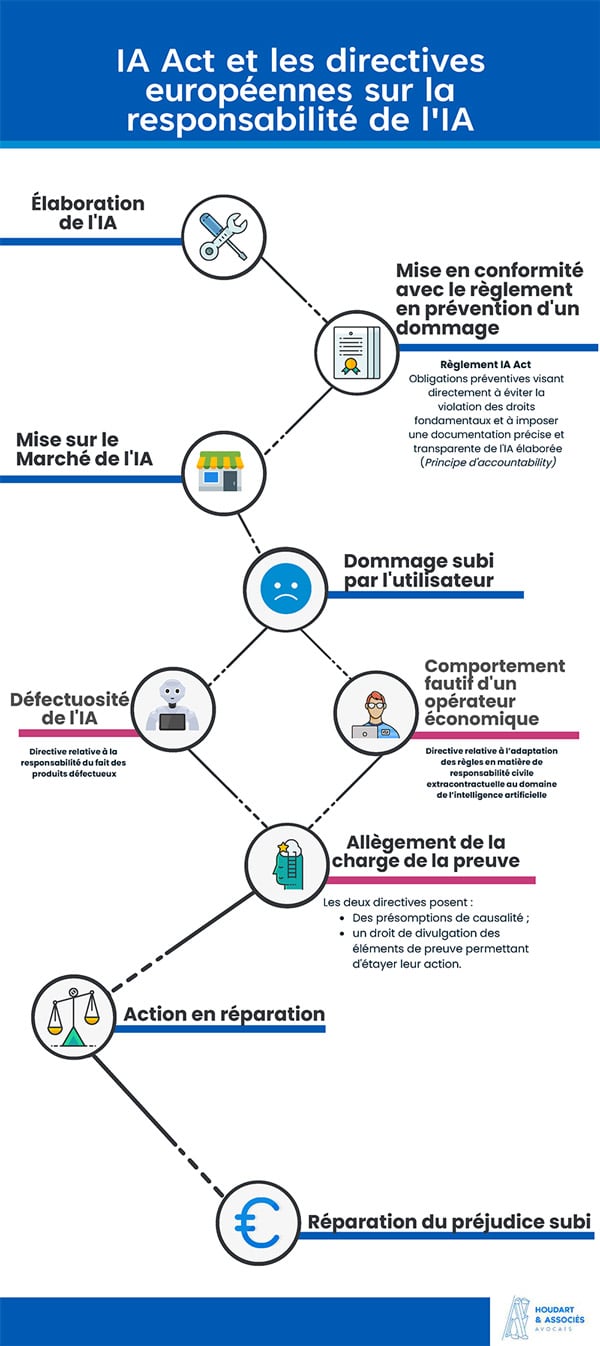

Face à l’ampleur du phénomène, les appels à une intervention réglementaire se multiplient. Plusieurs pistes sont évoquées par les acteurs du secteur et les observateurs. La première consisterait à imposer une transparence obligatoire sur l’origine des contenus, avec un étiquetage clair indiquant si un article a été généré par IA. Cette approche s’inspire des régulations existantes dans d’autres domaines, comme l’obligation de mentionner les retouches photos dans la publicité.

Une deuxième piste concerne la responsabilité des plateformes. Certains plaident pour que Google soit tenu légalement responsable des contenus qu’il recommande activement via Discover, à la différence des résultats de recherche traditionnels qui répondent à une requête utilisateur. Cette distinction juridique pourrait inciter la plateforme à renforcer significativement ses contrôles en amont. L’Union européenne, avec le Digital Services Act, a déjà posé des jalons dans cette direction, mais leur application concrète reste à préciser.

| Mesure réglementaire envisagée | Objectif | Défis de mise en œuvre |

|---|---|---|

| Étiquetage obligatoire | Transparence sur l’origine IA des contenus | Difficulté de vérification et de contrôle |

| Responsabilité de plateforme | Inciter Google à mieux contrôler Discover | Définition juridique complexe |

| Quotas de contenus vérifiés | Garantir une part minimale de sources fiables | Risque d’ingérence éditoriale |

| Sanctions financières | Dissuader la diffusion de désinformation | Attribution de responsabilité difficile |

| Certification des éditeurs | Créer un label de qualité reconnu | Nécessite un organisme indépendant |

D’autres voix, notamment parmi les experts en technologies, privilégient des solutions techniques plutôt que réglementaires. Ils proposent le développement de systèmes de vérification décentralisés, basés par exemple sur la blockchain, qui permettraient d’authentifier l’origine et l’intégrité des contenus. Des initiatives comme l’arrivée de l’IA chez Google France pourraient intégrer ces technologies pour distinguer automatiquement les sources fiables des contenus générés.

L’avenir du modèle économique des médias

Au-delà des questions techniques et réglementaires, la situation impose une réflexion profonde sur la viabilité économique du journalisme professionnel à l’ère de l’IA générative. Si le modèle traditionnel reposant sur le trafic publicitaire devient insoutenable face à la concurrence de machines produisant du contenu à faible coût, quelles alternatives s’offrent aux médias ?

Plusieurs pistes émergent. Le modèle par abonnement gagne du terrain, libérant les médias de leur dépendance aux algorithmes de recommandation. Des plateformes comme Substack ou les offres d’abonnement numérique des grands quotidiens démontrent qu’une partie du public est prête à payer pour du contenu de qualité. Toutefois, ce modèle reste inaccessible pour de nombreux médias de taille moyenne qui peinent à atteindre la masse critique d’abonnés nécessaire.

Une autre approche consiste à valoriser différemment le travail journalistique, en développant des services complémentaires : conférences, formations, consulting, création de communautés. Certains médias expérimentent également l’utilisation contrôlée de l’IA pour automatiser les tâches répétitives (dépêches, résultats sportifs) tout en concentrant leurs journalistes sur des enquêtes à forte valeur ajoutée. Cette révolution de l’IA dans la création de contenu pourrait paradoxalement devenir un outil au service du journalisme de qualité plutôt qu’une menace.

- Abonnements numériques : diversification des revenus et réduction de la dépendance publicitaire

- Contenus premium : création de formats exclusifs à forte valeur ajoutée (podcasts, newsletters, vidéos)

- Modèles hybrides : combinaison de gratuit et payant avec murs de paiement flexibles

- Financements publics : subventions et aides ciblées pour soutenir le journalisme d’intérêt général

- Coopératives de presse : mutualisation des moyens et gouvernance participative

- Partenariats technologiques : alliances avec des entreprises tech pour développer des outils dédiés

L’avenir de l’information en ligne se jouera probablement sur la capacité collective à redéfinir la valeur du journalisme professionnel dans un monde saturé de contenus automatisés. La position de Google sur les aperçus IA évoluera nécessairement sous la pression conjuguée des régulateurs, des éditeurs et des utilisateurs eux-mêmes. La question centrale demeure : parviendrons-nous à préserver un écosystème informationnel de qualité, ou assisterons-nous à une dégradation progressive de l’accès à une information fiable et vérifiée ?

Comment identifier un site d’information généré par IA ?

Plusieurs indices permettent de repérer ces sites : publication d’un très grand nombre d’articles quotidiens (souvent des dizaines), absence d’informations sur l’équipe de rédaction, images étranges ou peu cohérentes souvent générées artificiellement, titres sensationnalistes avec des sujets anxiogènes, articles comportant des incohérences factuelles ou des formulations répétitives typiques des IA, présence massive de publicités Google AdSense, et noms de domaine récents ou rachetés sans historique clair. La combinaison de plusieurs de ces signaux doit alerter le lecteur sur la nature automatisée du contenu.

Pourquoi Google ne bloque pas immédiatement ces sites frauduleux ?

Google fait face à plusieurs défis techniques et économiques. D’abord, identifier automatiquement un contenu généré par IA devient de plus en plus complexe avec l’amélioration des modèles de langage. Ensuite, l’entreprise gagne financièrement sur ces sites via AdSense, créant un conflit d’intérêts. Les systèmes antispam fonctionnent principalement de manière réactive plutôt que proactive, avec des cycles de modération espacés de plusieurs semaines. Enfin, les éditeurs peu scrupuleux ont développé des stratégies de rotation rapide des domaines qui rendent la modération inefficace : dès qu’un site est blacklisté, un nouveau prend le relais instantanément.

Quel est l’impact de ce phénomène sur les médias traditionnels ?

L’impact est considérable sur plusieurs plans. Économiquement, les médias légitimes subissent une concurrence déloyale de la part d’acteurs aux coûts de production quasi nuls, ce qui réduit leur visibilité sur Discover et donc leur trafic et leurs revenus publicitaires. Cette situation aggrave la précarité déjà importante des rédactions. Sur le plan de la confiance, l’exposition massive à de faux contenus érode la crédibilité générale de l’information en ligne, y compris celle produite par des journalistes professionnels. Enfin, cette distorsion crée une pression pour adopter des pratiques éditoriales optimisées pour l’algorithme plutôt que pour la qualité informative.

Quelles solutions pourraient résoudre ce problème ?

Plusieurs pistes complémentaires sont envisageables. Au niveau réglementaire, l’étiquetage obligatoire des contenus IA et une responsabilisation accrue des plateformes comme Google pourraient changer la donne. Techniquement, le développement de systèmes de certification positive pour les sources vérifiées permettrait de contourner les limites de la détection automatique. Google pourrait modifier son algorithme Discover pour privilégier des critères éditoriaux et la qualité plutôt que le simple engagement. Enfin, les médias traditionnels doivent diversifier leurs sources de revenus en développant les abonnements numériques et en créant des contenus premium à forte valeur ajoutée que l’IA ne peut pas reproduire.

Ces contenus générés par IA sont-ils toujours de la désinformation ?

Non, tous les contenus générés par IA ne sont pas nécessairement faux ou trompeurs. Le problème principal réside dans l’absence de vérification, de contexte et de responsabilité éditoriale. Certains articles automatisés peuvent contenir des informations factuelles correctes compilées depuis des sources fiables, mais présentées de manière sensationnaliste ou décontextualisée. D’autres mélangent des faits réels avec des éléments inventés ou des images artificielles trompeuses. L’enjeu n’est pas tant la technologie IA elle-même, qui peut être utilisée légitimement comme outil d’assistance, mais l’utilisation industrielle et non contrôlée de cette technologie dans un but purement mercantile, sans respect des standards journalistiques.