Apple s’apprête à révolutionner le marché des appareils intelligents avec ses lunettes AI et des AirPods équipés de caméras, prévus pour 2027. À la pointe de l’innovation, la technologie MLX et le modèle FastVLM promettent un traitement d’image ultra-rapide et efficace, transformant notre expérience numérique.

Les Nouvelles Lunettes Connectées d’Apple : Vers une Révolution AI

Les Progrès d’Apple dans le Métier de l’Intelligence Artificielle

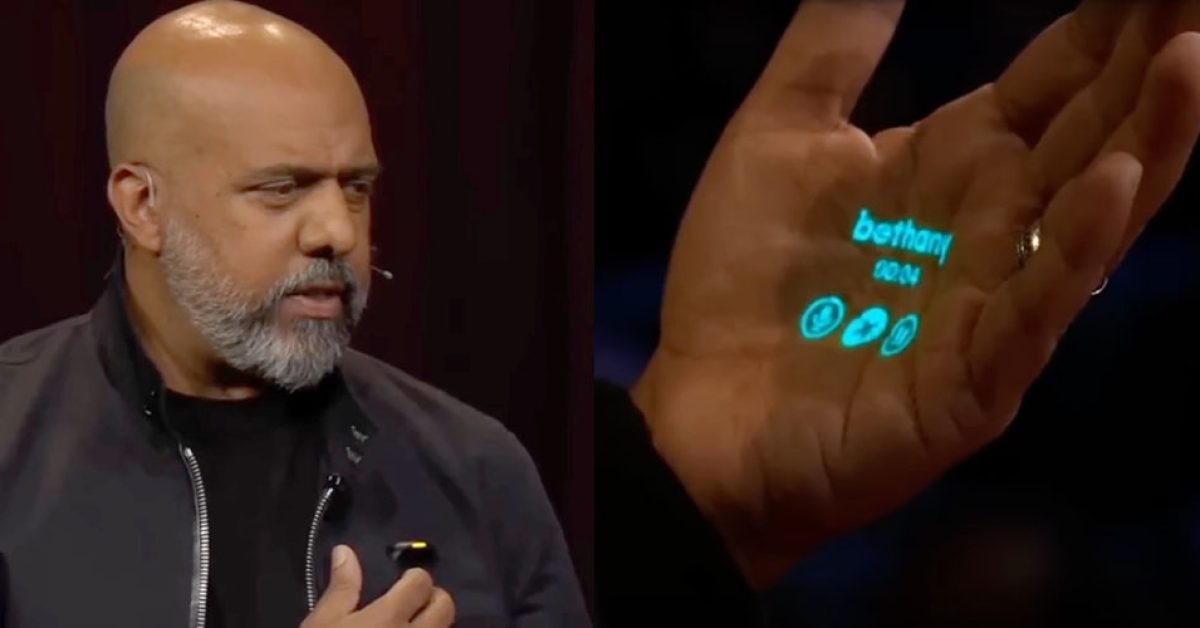

Au cours des derniers mois, de nombreuses rumeurs ont circulé concernant les projets d’Apple pour lancer des appareils portables intégrant de l’intelligence artificielle. Actuellement, les concurrents directs d’Apple, notamment les Meta Ray-Bans, pourraient voir le jour autour de 2027, accompagnés d’AirPods dotés de caméras, qui proposeront également leurs propres fonctionnalités basées sur l’IA.

Bien qu’il soit prématuré de spéculer sur leur apparence exacte, Apple a récemment laissé entrevoir le fonctionnement potentiel de son intelligence artificielle.

Présentation de MLX : Un Cadre d’Apprentissage Automated pour Apple

En 2023, l’équipe de recherche sur l’apprentissage automatique d’Apple a mis au point MLX, un cadre open source spécifiquement conçu pour les appareils utilisant Apple Silicon. En résumé, MLX fournit un moyen léger de former et d’exécuter des modèles localement sur des appareils Apple, tout en restant accessible aux développeurs familiers avec des frameworks et des langages traditionnels liés à l’IA.

FastVLM : Le Nouveau Modèle Visuel d’Apple

Apple a développé FastVLM, un Modèle de Langage Visuel (VLM) qui tire parti de MLX pour offrir un traitement d’image haute résolution quasi instantané tout en nécessitant nettement moins de puissance de calcul que des modèles similaires. Apple déclare :

"Basé sur une analyse d’efficacité complète de l’interaction entre la résolution d’image, la latence visuelle, le nombre de tokens et la taille du modèle LLM, nous introduisons FastVLM – un modèle qui atteint un compromis optimisé entre latence, taille du modèle et précision."

Un Encodeur Innovant pour des Performances Optimisées

Au cœur de FastVLM se trouve un encodeur appelé FastViTHD, qui a été "spécialement conçu pour des performances VLM efficaces sur des images haute résolution".

FastViTHD est jusqu’à 3,2 fois plus rapide et 3,6 fois plus petit que les modèles similaires. Cela constitue une avancée majeure si l’on souhaite que les appareils traitent les informations localement, sans nécessiter le cloud pour générer une réponse à ce que l’utilisateur vient de demander ou de regarder.

En outre, FastVLM a été conçu pour produire moins de tokens, ce qui est également crucial lors de l’inférence, l’étape où le modèle interprète les données et génère une réponse. Selon Apple, son modèle a un temps d’attente pour le premier token 85 fois plus rapide que les modèles similaires, mesuré par le temps qu’il faut à l’utilisateur pour envoyer la première requête et recevoir le premier token de la réponse. Moins de tokens sur un modèle plus rapide et léger signifie un traitement plus rapide.

Disponibilité et Ressources Techniques

FastVLM est disponible sur GitHub, tandis que le rapport technique peut être consulté sur arXiv. Bien qu’il ne soit pas facile à lire, il vaut vraiment la peine d’être étudié si vous êtes intéressé par les aspects plus techniques des projets d’IA d’Apple.

Mon avis :

Les rumeurs sur les lunettes AI d’Apple, concurrentes des Meta Ray-Bans, suscitent un intérêt croissant. Grâce à des innovations comme le modèle FastVLM, optimisé pour la rapidité et l’efficacité, Apple pourrait offrir des performances locales impressionnantes. Cependant, la dépendance potentielle à l’écosystème Apple pourrait restreindre son adoption par un public plus large.

Les questions fréquentes :

Quelles sont les nouvelles initiatives d’Apple dans le domaine des wearables ?

Apple prévoit de lancer des wearables dotés d’IA d’ici 2027, en concurrence directe avec les Meta Ray-Bans. Ces appareils comprendront également des AirPods avec des caméras, offrant une gamme de fonctionnalités basées sur l’IA.

Qu’est-ce que le framework MLX d’Apple ?

MLX est un framework d’apprentissage machine ouvert développé par l’équipe de recherche d’Apple. Conçu spécifiquement pour les appareils Apple Silicon, il permet de former et d’exécuter des modèles localement, ce qui facilite le travail des développeurs familiers avec d’autres frameworks.

Qu’est-ce que FastVLM et pourquoi est-il important ?

FastVLM est un modèle de langage visuel qui utilise MLX pour un traitement d’image haute résolution quasi instantané. Il est jusqu’à 3,2 fois plus rapide et 3,6 fois plus léger que d’autres modèles, ce qui permet un traitement local sans besoin de connexion cloud, améliorant ainsi l’expérience utilisateur.

Comment FastVLM améliore-t-il le traitement des données d’image ?

Le modèle FastVLM génère moins de "tokens" durant le processus d’inférence, ce qui réduit le temps de traitement. Selon Apple, il présente un temps de traitement pour le premier "token" 85 fois plus rapide que d’autres modèles similaires, rendant ainsi le traitement des données plus efficace.