Le Texas s’impose comme l’épicentre de la révolution numérique américaine. Google vient d’annoncer un investissement colossal de 40 milliards de dollars d’ici 2027 pour construire trois nouveaux centres de données dédiés à l’intelligence artificielle et au cloud computing sur le territoire texan. Cette décision stratégique illustre la mutation profonde du paysage technologique mondial, où les géants du numérique rivalisent d’audace pour sécuriser les infrastructures de l’ère de l’IA. Entre énergie décarbonée abondante, fiscalité avantageuse et espace disponible, le Lone Star State attire désormais les plus grandes ambitions technologiques planétaires. Cette dynamique révèle les enjeux colossaux liés au développement des capacités de calcul nécessaires aux systèmes d’apprentissage automatique de nouvelle génération.

Le Texas, eldorado énergétique pour les infrastructures cloud

L’attractivité du Texas pour les data centers repose sur un socle énergétique exceptionnel. L’État dispose d’une production électrique massive et diversifiée, avec 300 mégawatts générés par des parcs éoliens monumentaux comme celui situé entre les comtés de Limestone et Navarro. Ces infrastructures comptent jusqu’à 88 éoliennes déployées sur des étendues gigantesques au sud de Dallas. Cette abondance énergétique constitue un atout majeur pour des installations aussi voraces en électricité que les centres de données modernes.

La capacité de production renouvelable texane dépasse largement celle de nombreux États américains combinés. Google prévoit d’ailleurs de soutenir 6 200 MW d’énergie renouvelable supplémentaires grâce à un fonds d’impact énergétique doté de 30 millions de dollars. Cette initiative vise à doubler les programmes locaux de formation d’apprentis électriciens, créant ainsi un écosystème pérenne autour de l’infrastructure numérique. Le modèle texan démontre qu’innovation technologique et transition écologique peuvent converger lorsque les conditions économiques et géographiques s’alignent favorablement.

Les centres de données consomment des quantités phénoménales d’électricité pour alimenter leurs serveurs et systèmes de refroidissement. Un seul data center peut engloutir l’équivalent énergétique d’une ville de 50 000 habitants. Face à cette réalité, le Texas offre non seulement des tarifs compétitifs mais aussi une stabilité d’approvisionnement essentielle aux opérations continues. Cette combinaison explique pourquoi Microsoft, Amazon et Facebook intensifient également leur présence texane, suivant la stratégie initiée par Google dans sa révolution IA aux États-Unis.

Défis infrastructurels du réseau électrique texan

Malgré ses atouts, le réseau électrique texan nécessite des renforcements substantiels. Les tempêtes hivernales de ces dernières années ont révélé des fragilités structurelles inquiétantes. Lorsque des conditions météorologiques extrêmes surviennent, le réseau peut connaître des défaillances catastrophiques affectant des millions de foyers. Pour des installations critiques comme les data centers, ces interruptions représentent des risques financiers colossaux et des pertes de données potentielles.

Le gestionnaire du réseau texan ERCOT travaille activement sur des programmes de modernisation. Les investissements planifiés incluent :

- Renforcement des lignes de transmission pour éviter les surcharges lors des pics de demande

- Déploiement de systèmes de stockage par batteries permettant de lisser la production intermittente des renouvelables

- Installation de transformateurs haute capacité capables de gérer les charges massives des data centers

- Création de micro-réseaux autonomes pour garantir la continuité d’alimentation des infrastructures critiques

- Interconnexions renforcées avec les réseaux des États voisins pour mutualiser les ressources

Ces améliorations nécessitent des investissements estimés à plusieurs dizaines de milliards de dollars sur la décennie. La présence des géants technologiques accélère paradoxalement cette modernisation, puisqu’ils contribuent financièrement aux infrastructures dont ils dépendent. Apple et Intel ont également annoncé des partenariats avec les autorités locales pour financer des segments spécifiques du réseau électrique.

| Entreprise | Investissement Texas (Mds $) | Centres de données prévus | Énergie renouvelable (MW) |

|---|---|---|---|

| 40 | 3 | 6 200 | |

| Microsoft | 32 | 2 | 4 800 |

| Amazon | 28 | 4 | 5 500 |

| Meta (Facebook) | 15 | 1 | 2 100 |

Guerre des data centers : la course aux infrastructures IA

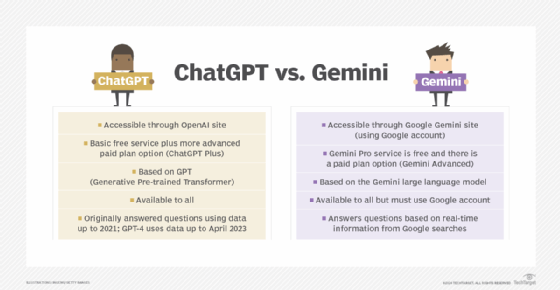

L’annonce de Google s’inscrit dans une compétition féroce entre les mastodontes technologiques pour dominer l’économie de l’intelligence artificielle. Nvidia, qui fournit les processeurs graphiques indispensables à l’entraînement des modèles d’IA, a vu sa valorisation exploser face à cette demande insatiable. Les centres de données modernes intègrent désormais des architectures spécialisées capable de traiter simultanément des milliards d’opérations pour alimenter les systèmes comme ChatGPT ou Gemini.

Salesforce, Tesla et IBM développent également leurs propres infrastructures dédiées à l’intelligence artificielle. Cette convergence technologique crée une économie circulaire fascinante : les fabricants de puces comme Nvidia vendent leur matériel aux géants du cloud qui, à leur tour, proposent des services d’IA aux entreprises clientes. Cette dynamique génère une valorisation spectaculaire parfois déconnectée des fondamentaux économiques traditionnels.

Les chiffres donnent le vertige. OpenAI et ses concurrents lèvent régulièrement des tours de financement dépassant le milliard de dollars. Les investissements dans l’infrastructure de calcul atteignent des sommets historiques, avec des dépenses annuelles mondiales approchant les 200 milliards de dollars. Elon Musk a qualifié ces montants d' »hallucinants », soulignant l’ampleur des ressources mobilisées pour maintenir la cadence d’innovation.

Anatomie d’un data center moderne dédié à l’IA

Contrairement aux installations traditionnelles, les centres de données optimisés pour l’IA présentent des caractéristiques architecturales spécifiques. La densité de calcul par mètre carré a été multipliée par dix en cinq ans. Les racks serveurs intègrent désormais des systèmes de refroidissement liquide directement au contact des processeurs pour évacuer la chaleur intense générée par les calculs intensifs.

Les composants clés incluent :

- Processeurs spécialisés (GPU/TPU) conçus spécifiquement pour les opérations matricielles massives

- Réseaux à très haute vitesse permettant la communication entre milliers de serveurs en quelques microsecondes

- Stockage ultra-rapide basé sur des technologies SSD et mémoire persistante

- Redondance énergétique avec batteries de secours et générateurs diesel

- Systèmes de sécurité physique dignes d’installations militaires pour protéger les données sensibles

La construction d’un seul data center de cette envergure mobilise des milliers d’ouvriers pendant plusieurs années. Les fondations doivent supporter des charges colossales tandis que les systèmes de climatisation représentent à eux seuls un investissement de plusieurs centaines de millions. Le data center de Google à Châteauroux illustre parfaitement cette complexité architecturale transposée au contexte européen.

| Composant | Coût unitaire (M$) | Consommation (MW) | Durée de vie (années) |

|---|---|---|---|

| Infrastructure GPU | 800 | 45 | 3-4 |

| Refroidissement | 250 | 15 | 15 |

| Réseau backbone | 180 | 3 | 8 |

| Stockage | 320 | 8 | 5 |

| Sécurité/Redondance | 150 | 12 | 20 |

Impacts économiques et stratégiques pour le Texas

Au-delà des chiffres bruts d’investissement, l’implantation massive de data centers transforme profondément l’économie texane. Les retombées s’étendent bien au-delà de la construction initiale. Des écosystèmes complets se développent autour de ces installations : fournisseurs d’équipements, entreprises de maintenance, cabinets de conseil spécialisés, et même restaurants et hôtels pour accueillir les techniciens en déplacement.

Les emplois créés couvrent un spectre de compétences extrêmement large. Si les postes d’ingénieurs systèmes et de spécialistes réseau attirent l’attention, la majorité des emplois concernent des techniciens de maintenance, électriciens, agents de sécurité et personnel administratif. Le programme de formation annoncé par Google vise à doubler le nombre d’apprentis électriciens, anticipant les besoins futurs d’un secteur en expansion rapide.

Les villes texanes concernées par ces implantations connaissent une revitalisation économique spectaculaire. Les prix de l’immobilier s’envolent, attirant promoteurs et investisseurs. Les infrastructures locales – routes, écoles, services publics – reçoivent des financements substantiels pour accompagner la croissance démographique. Ce développement soulève néanmoins des questions sur la gentrification et l’accessibilité du logement pour les populations locales.

Fiscalité attractive : le modèle texan en question

L’absence d’impôt sur le revenu au Texas constitue un argument de poids pour attirer les talents technologiques. Les entreprises bénéficient également d’une fiscalité corporate favorable avec des taux nettement inférieurs à ceux de la Californie ou de New York. Ces avantages fiscaux représentent des économies de plusieurs centaines de millions de dollars annuellement pour des structures comme Google.

Cependant, ce modèle repose sur des taxes foncières relativement élevées et des revenus issus de l’industrie pétrolière. La transition vers une économie numérique pose la question de la soutenabilité à long terme de ce système. Les autorités texanes négocient des accords spécifiques avec les géants technologiques, incluant des exonérations temporaires en échange d’engagements sur l’emploi et les investissements locaux.

- Exonérations fiscales sur 10 ans pour les nouvelles installations industrielles majeures

- Crédits d’impôt formation pour les entreprises investissant dans la qualification locale

- Tarifs énergétiques préférentiels pour les gros consommateurs s’engageant sur du long terme

- Simplification administrative avec des délais d’autorisation raccourcis pour les projets stratégiques

- Participation publique au financement des infrastructures de transport et télécommunications

Cette politique attire évidemment les critiques. Les opposants soulignent que les revenus fiscaux perdus auraient pu financer l’éducation ou les services sociaux. Les partisans rétorquent que la création d’emplois et l’effet multiplicateur économique compensent largement ces manques à gagner. Le débat fait rage au sein de la législature texane, reflétant des visions opposées du développement économique.

| Avantage Texas | Californie (comparaison) | Économie annuelle (M$) |

|---|---|---|

| Impôt sur le revenu | 0% vs 13.3% | 450 |

| Corporate tax | 0% vs 8.84% | 320 |

| Coût immobilier | -65% | 280 |

| Tarif électricité | -40% | 180 |

Défis environnementaux et consommation énergétique exponentielle

L’expansion fulgurante des data centers soulève des préoccupations environnementales majeures. Malgré les engagements vers les énergies renouvelables, la demande électrique croît plus rapidement que la transition écologique ne peut l’accompagner. Un data center IA consomme jusqu’à cinq fois plus d’énergie qu’une installation cloud traditionnelle, du fait des calculs intensifs requis par l’entraînement des modèles d’apprentissage automatique.

La consommation d’eau constitue un autre enjeu critique souvent négligé. Les systèmes de refroidissement évaporatif peuvent engloutir des millions de litres quotidiennement, une ressource particulièrement précieuse dans certaines régions texanes sujettes à la sécheresse. Les technologies de refroidissement liquide direct réduisent cette dépendance mais nécessitent des investissements supplémentaires substantiels.

Google et ses concurrents communiquent abondamment sur leurs objectifs de neutralité carbone. La réalité opérationnelle reste néanmoins complexe. L’engagement de soutenir 6 200 MW d’énergie renouvelable représente certes un effort louable, mais ces capacités ne seront pas opérationnelles avant plusieurs années. En attendant, les data centers s’alimentent partiellement sur le réseau mixte incluant des sources fossiles, notamment le gaz naturel abondant au Texas.

Innovations technologiques pour réduire l’empreinte écologique

Face aux critiques, l’industrie développe des technologies prometteuses. L’efficacité énergétique des processeurs s’améliore constamment, avec des gains de 15 à 20% par génération technologique. Les architectures logicielles optimisées permettent d’accomplir les mêmes tâches avec moins de cycles de calcul, réduisant proportionnellement la consommation électrique.

Les approches innovantes incluent :

- Refroidissement par immersion plongeant les serveurs dans des bains de fluide diélectrique

- Récupération de chaleur pour alimenter des réseaux de chauffage urbain ou des serres agricoles

- Intelligence artificielle d’optimisation gérant dynamiquement la distribution de charge pour minimiser la consommation

- Utilisation de l’air extérieur dans les régions tempérées pour réduire la climatisation artificielle

- Stockage d’énergie sur site permettant de lisser les pics de demande et valoriser l’électricité renouvelable intermittente

Microsoft expérimente même des data centers immergés au fond des océans, exploitant la température naturellement fraîche des eaux profondes. Amazon teste des installations alimentées exclusivement par des micro-réacteurs nucléaires modulaires, une technologie émergente promettant une production décarbonée continue. Ces expérimentations illustrent la créativité déployée pour concilier croissance numérique et construction d’un avenir durable.

| Technologie | Réduction consommation | Coût additionnel | Maturité |

|---|---|---|---|

| Refroidissement liquide direct | 35% | +25% | Mature |

| Immersion diélectrique | 45% | +40% | Émergente |

| IA d’optimisation | 18% | +5% | Mature |

| Free cooling | 28% | +12% | Mature |

| Récupération chaleur | Variable | +15% | Émergente |

Géopolitique du numérique : enjeux de souveraineté et de contrôle des données

La concentration massive de centres de données au Texas révèle des enjeux géopolitiques profonds. La localisation géographique des infrastructures cloud détermine qui contrôle réellement les données mondiales et les capacités de calcul stratégiques. Les États-Unis consolident ainsi leur hégémonie numérique face aux ambitions chinoises et européennes de développer des alternatives souveraines.

L’Union Européenne tente de répliquer ce modèle avec des initiatives comme Gaia-X, visant à créer une infrastructure cloud européenne indépendante. Google Cloud développe également des offres souveraines en Europe, reconnaissant les préoccupations légitimes concernant l’extraterritorialité du droit américain. Le Cloud Act américain permet théoriquement aux autorités fédérales d’accéder aux données stockées par des entreprises américaines, même sur des serveurs situés à l’étranger.

Cette réalité inquiète les gouvernements européens, asiatiques et africains qui perçoivent une dépendance dangereuse vis-à-vis des infrastructures américaines. Les données sensibles – dossiers médicaux, secrets industriels, communications gouvernementales – transitent par des serveurs potentiellement accessibles aux services de renseignement étrangers. Cette vulnérabilité stratégique pousse à l’émergence de champions nationaux du cloud et à l’adoption de législations contraignant la localisation des données.

Fragmentation d’Internet et balkanisation numérique

La réponse à ces inquiétudes prend la forme d’une fragmentation progressive d’Internet. La Chine opère depuis longtemps un réseau largement isolé derrière son « Great Firewall ». La Russie développe son propre Internet souverain. L’Inde impose des obligations strictes de localisation des données pour certains secteurs. Cette balkanisation numérique contredit la vision originelle d’un réseau mondial ouvert et interconnecté.

Les conséquences économiques sont considérables. Les entreprises multinationales doivent désormais dupliquer leurs infrastructures dans chaque région géographique pour respecter les réglementations locales. Cette redondance coûteuse explique partiellement les investissements pharaoniques annoncés par les géants technologiques. Le partenariat Atos-Google Cloud illustre ces stratégies d’alliances locales pour répondre aux exigences de souveraineté.

- RGPD européen imposant des restrictions strictes sur les transferts de données hors UE

- Législations sectorielles contraignant certaines industries à héberger localement leurs données

- Exigences de transparence obligeant les fournisseurs cloud à révéler l’emplacement physique des données

- Certifications souveraines créant des standards nationaux pour les infrastructures critiques

- Restrictions technologiques limitant l’utilisation d’équipements de certains fabricants pour raisons de sécurité nationale

Cette évolution bouleverse le modèle économique du cloud basé sur la mutualisation et l’échelle mondiale. IBM et Salesforce adaptent leurs offres en proposant des versions « souveraines » de leurs services, hébergées localement et gérées par des partenaires nationaux. La standardisation technologique cède progressivement face aux impératifs politiques et sécuritaires.

| Région | Approche souveraineté | Investissement local (Mds $) | Restrictions principales |

|---|---|---|---|

| Union Européenne | RGPD + Cloud Act concerns | 45 | Transferts données, certifications |

| Chine | Great Firewall + localisation | 120 | Accès étranger limité, censure |

| Inde | Localisation sectorielle | 28 | Paiements, santé, télécom |

| Russie | Internet souverain | 15 | Routage contrôlé, données localisées |

Perspectives futures : vers une décentralisation ou une concentration accrue

Le modèle actuel de méga data centers centralisés fait débat au sein même de l’industrie technologique. Des voix s’élèvent pour promouvoir une approche décentralisée, avec des installations plus petites dispersées géographiquement. Cette architecture distribuée offrirait une meilleure résilience face aux catastrophes naturelles ou aux cyberattaques, tout en rapprochant les capacités de calcul des utilisateurs finaux pour réduire la latence.

Les technologies émergentes comme le edge computing matérialisent partiellement cette vision. Les traitements s’effectuent localement sur des serveurs de périphérie plutôt que dans des data centers distants. Cette approche convient particulièrement aux applications nécessitant des temps de réponse ultra-rapides : véhicules autonomes, réalité augmentée, contrôle industriel en temps réel. Tesla exploite ainsi des capacités de calcul embarquées dans ses véhicules, complétées par des infrastructures cloud centralisées.

Néanmoins, l’entraînement des grands modèles d’IA requiert une concentration massive de puissance de calcul difficilement réplicable à petite échelle. Les derniers modèles de langage mobilisent des milliers de processeurs travaillant en parallèle pendant des semaines. Cette réalité technique favorise la persistance de méga installations comme celles annoncées au Texas, créant une architecture hybride combinant centres massifs et points de présence périphériques.

Évolution des architectures cloud et impact sur l’industrie

Les prochaines générations d’infrastructures cloud intégreront probablement des innovations radicales. Les processeurs quantiques, encore expérimentaux, promettent des gains de performance exponentiels pour certaines catégories de problèmes. IBM et Google investissent massivement dans cette technologie qui pourrait révolutionner la cryptographie et l’optimisation complexe.

L’intelligence artificielle elle-même optimise désormais la gestion des data centers. Des systèmes d’apprentissage automatique analysent en temps réel des milliers de paramètres – température, charge réseau, utilisation processeur – pour ajuster dynamiquement l’allocation des ressources. Les défis de Google Research incluent précisément ces problématiques d’optimisation à grande échelle.

- Calcul optique remplaçant les électrons par des photons pour accélérer les traitements

- Mémoire persistante fusionnant les caractéristiques du stockage et de la RAM

- Réseaux programmables adaptant dynamiquement leur topologie aux besoins applicatifs

- Refroidissement passif exploitant des matériaux à changement de phase

- Génération embarquée d’énergie via panneaux solaires intégrés aux bâtiments

L’impact sur l’industrie dépasse les seuls opérateurs cloud. Les fabricants de composants comme Intel et Nvidia adaptent leurs roadmaps technologiques aux besoins spécifiques de l’IA. Les équipementiers réseau développent des switches capables de gérer des débits de plusieurs téraoctets par seconde. Les entreprises de construction se spécialisent dans les normes exigeantes des data centers modernes. Un écosystème complet se structure autour de ces infrastructures devenues aussi stratégiques que les raffineries pétrolières du siècle dernier.

| Innovation | Horizon déploiement | Gain performance | Barrière principale |

|---|---|---|---|

| Processeurs quantiques | 2030+ | Exponentiel (ciblé) | Stabilité, scalabilité |

| Calcul optique | 2027-2030 | 100x vitesse | Intégration, coût |

| Mémoire persistante | 2026-2028 | 50x vitesse I/O | Densité, fiabilité |

| IA d’optimisation avancée | Déjà déployée | 20-30% efficience | Complexité, adaptation |

Les investissements colossaux de Google au Texas s’inscrivent donc dans une transformation structurelle de l’économie numérique mondiale. La course aux capacités de calcul redéfinit les équilibres géopolitiques, les modèles énergétiques et les architectures technologiques. Entre concentration texane et fragmentation souveraine, entre innovations vertes et appétit énergétique croissant, l’industrie navigue sur des contradictions que seule l’ingéniosité technologique peut potentiellement résoudre. Les décisions prises aujourd’hui détermineront qui contrôlera les infrastructures numériques des prochaines décennies.

Les 40 milliards de dollars engagés représentent bien plus qu’un simple investissement immobilier. Ils matérialisent une vision où l’intelligence artificielle devient l’infrastructure fondamentale de l’économie moderne, au même titre que l’électricité ou les télécommunications au siècle précédent. Cette mutation s’accompagne de défis considérables – énergétiques, environnementaux, géopolitiques – que l’industrie commence seulement à appréhender pleinement. Les orientations stratégiques de Sundar Pichai reflètent cette conscience des enjeux multidimensionnels portés par le développement de l’IA.

Les implications dépassent largement le secteur technologique. Les réseaux électriques doivent se moderniser, les formations professionnelles s’adapter, les législations évoluer. Les hébergeurs web traditionnels doivent repenser leurs modèles face à la concentration du marché. Les collectivités locales négocient âprement les conditions d’implantation, conscientes des opportunités économiques mais aussi des contraintes infrastructurelles. Cette transformation systémique redessine le paysage numérique mondial avec une rapidité inédite.

Face à cette dynamique, les acteurs européens tentent de maintenir leur pertinence. Les projets de data centers entre Loches et Châteauroux témoignent des ambitions françaises dans ce domaine stratégique. Néanmoins, l’écart d’échelle avec les investissements texans illustre la difficulté de rivaliser avec la puissance financière et l’attractivité territoriale américaine. La question de la souveraineté numérique européenne reste donc entière, oscillant entre protectionnisme réglementaire et pragmatisme économique.

Pourquoi Google investit-il spécifiquement au Texas plutôt que dans d’autres États américains ?

Le Texas offre une combinaison unique d’avantages : absence d’impôt sur le revenu, fiscalité corporate favorable, production d’énergie renouvelable abondante et peu coûteuse, disponibilité foncière importante, et climat politique favorable aux entreprises technologiques. L’État dispose notamment de 6 200 MW de capacités renouvelables supplémentaires planifiées, essentielles pour alimenter les data centers énergivores dédiés à l’intelligence artificielle.

Quelle est la consommation énergétique réelle d’un data center dédié à l’IA ?

Un data center moderne dédié à l’IA consomme typiquement entre 30 et 80 mégawatts, soit l’équivalent d’une ville de 50 000 habitants. Les installations les plus récentes peuvent atteindre 150 MW en raison des processeurs graphiques (GPU) extrêmement énergivores utilisés pour l’entraînement des modèles d’apprentissage automatique. Cette consommation représente 5 fois celle d’un data center cloud traditionnel.

Les investissements dans les data centers créent-ils réellement des emplois locaux ?

Oui, mais la nature des emplois varie considérablement. La phase de construction mobilise plusieurs milliers d’ouvriers pendant 2-3 ans. Une fois opérationnel, un data center emploie directement entre 200 et 500 personnes (techniciens, ingénieurs, agents de sécurité). Les emplois indirects (fournisseurs, services, maintenance) représentent 3 à 5 fois ce chiffre. Google prévoit notamment de doubler les programmes de formation d’apprentis électriciens pour accompagner ces développements.

Comment les data centers gèrent-ils leur impact environnemental ?

Les opérateurs déploient plusieurs stratégies : utilisation croissante d’énergies renouvelables (Google s’engage sur 6 200 MW supplémentaires), technologies de refroidissement innovantes (immersion liquide réduisant la consommation de 45%), récupération de chaleur pour chauffage urbain, optimisation par intelligence artificielle des flux énergétiques (économies de 20-30%), et utilisation de l’air extérieur gratuit dans les régions tempérées. Néanmoins, la croissance de la demande dépasse actuellement les gains d’efficacité.

Quels sont les risques géopolitiques liés à la concentration des data centers aux États-Unis ?

La concentration crée plusieurs vulnérabilités : dépendance technologique mondiale vis-à-vis des infrastructures américaines, exposition aux législations extraterritoriales comme le Cloud Act permettant l’accès gouvernemental aux données, risques de fragmentation d’Internet en zones souveraines séparées, et vulnérabilité aux tensions internationales pouvant restreindre l’accès aux services cloud. Cette réalité pousse l’Europe, la Chine et l’Inde à développer des infrastructures souveraines alternatives malgré des coûts supérieurs.