Derrière les prouesses technologiques de Google Gemini, se cache une réalité moins reluisante. Cette intelligence artificielle tant vantée pour ses capacités révolutionnaires s’appuie sur une main-d’œuvre précarisée composée de milliers d’évaluateurs invisibles. Ces travailleurs du clic opèrent dans l’ombre, confrontés quotidiennement à des contenus dérangeants pour des salaires dérisoires. La sous-traitance technologique orchestrée par les géants de la tech révèle un système pyramidal où l’exploitation numérique bat son plein. Cette enquête dévoile les dessous d’une industrie qui présente ses modèles comme autonomes, alors qu’ils dépendent massivement du labeur humain le plus précaire.

La réalité cachée de l’entraînement de Gemini par des évaluateurs IA

L’intelligence artificielle Google Gemini ne fonctionne pas par magie. Derrière cette technologie se dissimule un écosystème complexe de travailleurs du clic employés par GlobalLogic, un sous-traitant japonais. Ces évaluateurs IA constituent l’épine dorsale invisible du système, corrigeant inlassablement les erreurs du modèle et affinant ses réponses.

Rachel Sawyer, ancienne évaluatrice généraliste pour Google, témoigne de conditions de travail pour le moins surprenantes. Elle découvre avec stupeur que son poste implique la modération de contenu sans avoir été prévenue lors de son embauche. « Non seulement on ne m’avait pas prévenue et je n’ai jamais signé de formulaire de consentement, mais ni l’intitulé du poste ni la description ne mentionnaient la modération de contenus », révèle-t-elle.

| Aspect du travail | Réalité pour les évaluateurs | Communication officielle |

|---|---|---|

| Nature du contenu | Contenus dérangeants et choquants | Évaluation de qualité standard |

| Formation fournie | Aucune préparation psychologique | Formation technique basique |

| Consentement éclairé | Absence de formulaires spécifiques | Procédures d’embauche classiques |

| Support psychologique | Inexistant | Non mentionné |

Ces évaluateurs occupent des postes généralistes sans expertise particulière, pourtant ils vérifient l’exactitude d’informations dans des domaines hautement spécialisés. Architecture, astrophysique, médecine : tous les sujets passent entre leurs mains. Une évaluatrice raconte avoir été « pressée » de travailler plus rapidement tout en formant le modèle sur des questions médicales sensibles comme la chimiothérapie pour le cancer de la vessie.

- Vérification de contenus médicaux complexes sans formation spécialisée

- Traitement de sujets techniques pointus (architecture, sciences)

- Modération de contenus perturbants sans préparation psychologique

- Pression temporelle constante pour accélérer les cadences

- Absence de supervision spécialisée dans les domaines traités

Google conteste pourtant que ces évaluateurs participent directement à l’amélioration de l’intelligence artificielle. Selon un porte-parole de Mountain View, ces « évaluateurs qualité » fournissent « des retours externes sur les produits, qui aident à mesurer le fonctionnement des systèmes, mais n’impactent pas directement les algorithmes ou modèles ». Une distinction sémantique qui masque mal la réalité du terrain.

L’impact psychologique de la modération de contenu sur les évaluateurs

La modération de contenu représente l’un des aspects les plus difficiles du travail d’évaluateur IA. Ces employés se retrouvent confrontés quotidiennement à des images, vidéos et textes potentiellement traumatisants sans préparation adéquate. L’absence de protocoles de protection psychologique amplifie les risques de burn-out et de troubles post-traumatiques.

Le phénomène touche particulièrement les évaluateurs travaillant sur les filtres de sécurité de Gemini. Ils doivent identifier et catégoriser des contenus violents, sexuellement explicites ou haineux pour éviter que l’IA ne reproduise ces éléments dans ses réponses. Cette exposition répétée sans accompagnement constitue une forme d’exploitation numérique particulièrement pernicieuse.

L’isolement professionnel aggrave cette situation. Ces travailleurs opèrent depuis leur domicile, sans collègues physiques ni supérieurs hiérarchiques accessibles immédiatement. Quand surgissent des contenus particulièrement choquants, ils n’ont d’autre choix que de continuer leur tâche pour respecter les quotas imposés.

Conditions de travail précaires et rémunération dérisoire des évaluateurs Gemini

La sous-traitance technologique mise en place par Google révèle un système économique particulièrement déséquilibré. Les évaluateurs IA employés par GlobalLogic perçoivent entre 16 et 21 dollars de l’heure, une rémunération dérisoire comparée aux salaires astronomiques des chercheurs en intelligence artificielle de Google.

Cette disparité salariale illustre parfaitement les mécanismes d’exploitation numérique à l’œuvre dans l’industrie technologique. Pendant que les dirigeants et ingénieurs de Google empochent des millions, les véritables artisans de Gemini peinent à boucler leurs fins de mois. « Ce sont des personnes expertes qui effectuent un excellent travail de rédaction, payé en dessous de leurs valeurs, pour créer un modèle IA dont le monde n’a pas besoin selon moi », confie amèrement un évaluateur.

| Poste | Salaire annuel moyen | Statut | Avantages sociaux |

|---|---|---|---|

| Évaluateur IA (GlobalLogic) | 33 000 – 44 000 $ | Contractuel | Minimaux |

| Ingénieur IA Google | 200 000 – 500 000 $ | Employé permanent | Complets + stock-options |

| Chercheur DeepMind | 300 000 – 1 000 000 $ | Employé permanent | Complets + bonus exceptionnels |

Les pressions exercées sur cette main-d’œuvre précarisée s’intensifient constamment. Les délais se raccourcissent tandis que les directives changent perpétuellement, créant un climat d’incertitude permanent. Les évaluateurs ignorent souvent l’utilisation finale de leur travail, comme l’explique un contractuel : « Nous ignorions où cela menait, comment c’était utilisé, dans quel quel but ».

- Salaires inférieurs au seuil de pauvreté dans certaines régions américaines

- Absence de sécurité de l’emploi et de perspectives d’évolution

- Quotas de productivité en augmentation constante

- Formation minimale malgré la complexité des tâches

- Changements fréquents de consignes sans préavis

Cette précarité s’accompagne d’une absence totale de reconnaissance. Contrairement aux développements innovants de Gemini largement médiatisés, le travail de ces évaluateurs reste invisible. Ils contribuent pourtant directement à la qualité des réponses et à la sécurité du système, sans jamais apparaître dans les communications de Google.

Le modèle économique de l’externalisation technologique chez Google

L’externalisation massive pratiquée par Google s’inscrit dans une logique financière implacable. En confiant l’entraînement de Gemini à des sous-traitants comme GlobalLogic, l’entreprise optimise ses coûts tout en se déresponsabilisant des conditions de travail. Cette stratégie permet de maintenir une image corporate positive tout en exploitant une main-d’œuvre précarisée.

Le choix de GlobalLogic, entreprise japonaise, n’est pas anodin. Cette société emploie des milliers d’Américains pour des tâches d’évaluation, créant une situation juridique complexe où les responsabilités se diluent entre différentes législations. Les travailleurs du clic se retrouvent ainsi privés de nombreux recours légaux disponibles aux employés directs de Google.

Cette architecture organisationnelle illustre parfaitement les nouvelles formes d’exploitation numérique. Les géants technologiques externalisent systématiquement leurs tâches les plus pénibles vers des entreprises spécialisées, créant une chaîne de sous-traitance qui dilue les responsabilités et précarise l’emploi.

Expertise technique insuffisante face aux enjeux complexes de Gemini

L’un des paradoxes les plus frappants du système d’entraînement de Gemini réside dans l’inadéquation entre l’expertise requise et les profils recrutés. Ces évaluateurs généralistes se voient confier des tâches d’une complexité technique considérable, sans formation spécialisée correspondante. Architecture, médecine, droit, sciences : tous les domaines passent entre leurs mains avec la même approche superficielle.

Cette situation génère des risques considérables pour la fiabilité de l’intelligence artificielle. Comment un évaluateur sans formation médicale peut-il vérifier l’exactitude d’informations sur la chimiothérapie ? Comment valider des calculs d’ingénierie ou des références juridiques complexes ? Le système repose sur une illusion de compétence qui fragilise l’ensemble de l’édifice.

Une évaluatrice témoigne de cette réalité troublante : « J’imaginais une personne assise dans sa voiture, apprenant qu’elle avait un cancer de la vessie et cherchant ce que j’étais en train d’éditer. » Cette prise de conscience souligne la responsabilité écrasante pesant sur des épaules insuffisamment préparées.

| Domaine d’expertise | Formation requise normalement | Formation des évaluateurs | Risque d’erreur |

|---|---|---|---|

| Médecine | 7+ années d’études | Formation générale | Très élevé |

| Droit | 5+ années d’études | Formation générale | Très élevé |

| Ingénierie | 5+ années d’études | Formation générale | Élevé |

| Finance | 3+ années spécialisées | Formation générale | Élevé |

Cette approche généraliste pose également des questions d’éthique de l’IA. Les évaluateurs prennent des décisions qui influencent directement les réponses futures de Gemini, sans posséder les connaissances nécessaires pour évaluer les implications de leurs choix. Ils deviennent malgré eux des arbitres de la vérité dans des domaines qu’ils ne maîtrisent pas.

- Validation d’informations médicales sans formation sanitaire

- Évaluation de contenus juridiques sans connaissances légales

- Vérification de données scientifiques sans expertise technique

- Modération de contenus culturels sans contexte anthropologique

- Traitement de questions financières sans compétences économiques

Les conséquences de cette inadéquation se répercutent directement sur la qualité de Gemini et ses applications. Malgré les efforts de ces évaluateurs, l’IA continue de produire des hallucinations et des erreurs, particulièrement dans les domaines spécialisés où l’expertise humaine fait le plus défaut.

Les lacunes de formation et leurs répercussions sur la qualité de Gemini

La formation dispensée aux évaluateurs de Gemini se résume souvent à quelques heures de présentation générale, largement insuffisante face à la diversité des sujets traités. Cette approche minimaliste reflète une vision purement productiviste où la quantité prime sur la qualité, au détriment de la fiabilité finale du système d’intelligence artificielle.

Les répercussions de ces lacunes formatives se manifestent quotidiennement dans les performances de Gemini. Les utilisateurs constatent régulièrement des incohérences, des approximations ou des erreurs flagrantes, particulièrement sur les sujets techniques. Ces défaillances trouvent leur origine dans le processus d’évaluation déficient orchestré par des non-spécialistes.

Le paradoxe atteint son paroxysme quand ces mêmes évaluateurs mal formés doivent corriger les erreurs d’un système qu’ils contribuent à dégrader. Cette boucle vicieuse perpétue un cycle de médiocrité où les nouvelles fonctionnalités de Gemini héritent systématiquement des biais et limitations de leurs formateurs humains.

Enjeux éthiques et responsabilité de Google dans l’exploitation de sa main-d’œuvre IA

Les révélations sur les conditions de travail des évaluateurs de Gemini soulèvent des questions fondamentales sur l’éthique de l’IA. Comment Google peut-elle prétendre développer une technologie bénéfique pour l’humanité tout en exploitant une main-d’œuvre précarisée ? Cette contradiction interroge la sincérité des engagements éthiques affichés par le géant technologique.

L’exploitation numérique orchestrée par Google s’apparente à un néocolonialisme technologique. L’entreprise extrait la valeur du travail humain tout en niant sa contribution essentielle. Cette stratégie permet de présenter Gemini comme une prouesse purement algorithmique, occultant délibérément la dimension humaine indispensable à son fonctionnement.

Adio Dinika, du Distributed AI Research Institute, résume parfaitement cette situation : « L’IA n’est pas magique : c’est un système pyramidal de travail humain. Ces évaluateurs IA occupent l’échelon intermédiaire invisible essentiel. » Cette analyse dévoile l’hypocrisie d’un secteur qui prétend révolutionner le travail humain tout en en dépendant massivement.

| Principe éthique | Discours officiel Google | Réalité du terrain |

|---|---|---|

| Transparence | Communication ouverte sur l’IA | Dissimulation du rôle des évaluateurs |

| Équité | Technologie accessible à tous | Exploitation d’une main-d’œuvre précaire |

| Respect humain | IA au service de l’humanité | Conditions de travail dégradées |

| Responsabilité | Engagement sociétal fort | Externalisation des responsabilités |

La responsabilité de Google s’étend bien au-delà des aspects juridiques. L’entreprise influence directement les standards de l’industrie technologique par ses pratiques. En normalisant l’exploitation numérique, elle encourage d’autres acteurs à adopter des approches similaires, perpétuant un modèle économique destructeur pour les travailleurs.

- Absence de reconnaissance officielle du rôle des évaluateurs

- Communication trompeuse sur l’autonomie de l’IA

- Externalisation systématique des responsabilités sociales

- Standardisation de pratiques d’exploitation dans l’industrie

- Négation de la dimension humaine essentielle à l’IA

Cette situation interpelle également les régulateurs et les consommateurs. Faut-il accepter que les progrès technologiques se fassent au détriment des droits des travailleurs ? La popularité croissante de Gemini et ses évolutions ne doit pas occulter les coûts humains de son développement.

Impact sur l’écosystème technologique et les pratiques sectorielles

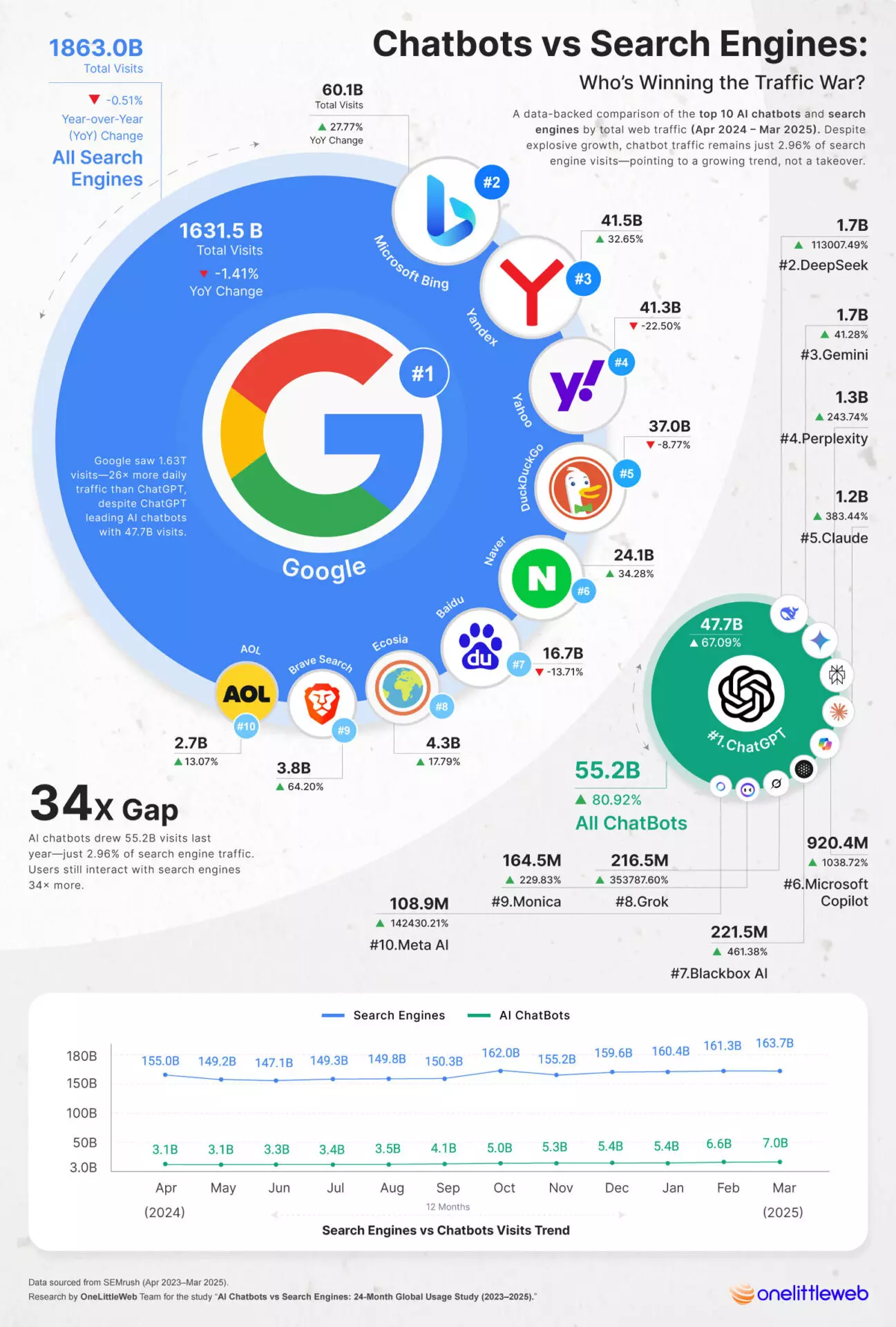

Les pratiques de Google concernant l’entraînement de Gemini établissent un précédent inquiétant pour l’ensemble de l’écosystème technologique. Les autres géants de l’intelligence artificielle observent attentivement ces méthodes et risquent de les reproduire, normalisant progressivement l’exploitation numérique à grande échelle.

Cette course au moins-disant social s’accélère avec l’intensification de la concurrence en IA. Chaque entreprise cherche à optimiser ses coûts d’entraînement pour rester compétitive, créant une spirale descendante où les conditions de travail se dégradent systématiquement. Les travailleurs du clic deviennent les variables d’ajustement de cette compétition effrénée.

L’influence de Google dépasse largement ses propres produits. Les méthodes développées pour Gemini inspirent directement les pratiques de l’intégration de l’IA dans d’autres secteurs, propageant les problèmes éthiques bien au-delà de la sphère technologique pure. Cette contamination éthique menace l’ensemble du marché du travail numérique.

Alternatives et perspectives d’amélioration pour un entraînement éthique de l’IA

Face aux dérives constatées dans l’entraînement de Gemini, plusieurs alternatives émergent pour concilier développement technologique et respect des travailleurs. Ces approches innovantes démontrent qu’il est possible de créer une intelligence artificielle performante sans sacrifier l’éthique de l’IA ni exploiter une main-d’œuvre précarisée.

Certaines entreprises expérimentent des modèles coopératifs où les évaluateurs deviennent actionnaires du système qu’ils contribuent à améliorer. Cette approche révolutionnaire transforme l’exploitation numérique en partenariat équitable, redistribuant une partie de la valeur créée vers ceux qui l’ont rendue possible. Les résultats préliminaires montrent une amélioration significative de la qualité et de la motivation.

L’expertise spécialisée représente une autre piste prometteuse. Plutôt que de confier tous les domaines à des évaluateurs généralistes, certains projets recrutent des spécialistes pour chaque secteur. Médecins pour les questions sanitaires, juristes pour les aspects légaux, ingénieurs pour les sujets techniques : cette approche garantit une qualité supérieure tout en valorisant l’expertise humaine.

| Modèle d’entraînement | Avantages | Coûts | Qualité résultante |

|---|---|---|---|

| Évaluateurs généralistes (actuel) | Coûts réduits, flexibilité | Très faibles | Médiocre, incohérente |

| Spécialistes par domaine | Expertise réelle, qualité | Élevés | Excellente, fiable |

| Modèle coopératif | Motivation, équité | Modérés | Très bonne |

| Formation approfondie | Polyvalence éclairée | Modérés à élevés | Bonne |

La formation intensive constitue également une voie d’amélioration réaliste. En investissant massivement dans la formation des évaluateurs, les entreprises peuvent considérablement élever leur niveau de compétence sans multiplier les intervenants. Cette approche nécessite un investissement initial conséquent mais génère des bénéfices durables pour la qualité de l’IA.

- Développement de modèles coopératifs avec participation aux bénéfices

- Recrutement de spécialistes qualifiés pour chaque domaine d’expertise

- Programmes de formation intensive et continue des évaluateurs

- Amélioration des conditions de travail et de la reconnaissance professionnelle

- Transparence accrue sur le rôle et l’importance des évaluateurs humains

Ces alternatives ne relèvent pas de l’utopie mais d’une vision entrepreneuriale éclairée. Plusieurs startups développent déjà des approches éthiques de l’entraînement IA, prouvant la viabilité économique de ces modèles. L’évolution de l’écosystème Google pourrait bénéficier de ces innovations pour améliorer ses pratiques.

Réglementation et cadre légal pour protéger les travailleurs de l’IA

L’émergence d’un cadre réglementaire spécifique aux travailleurs du clic devient urgente face à l’ampleur de l’exploitation numérique. Les législations actuelles, conçues pour l’économie traditionnelle, peinent à appréhender les spécificités du travail numérique et les risques associés à la modération de contenu.

Plusieurs juridictions explorent des pistes législatives innovantes. L’Union européenne envisage d’étendre sa réglementation sur l’IA aux conditions de travail des évaluateurs, imposant des standards minimaux de formation et de protection psychologique. Cette approche pourrait créer un précédent mondial et forcer Google à revoir ses pratiques.

La reconnaissance professionnelle constitue un enjeu majeur de cette évolution réglementaire. Les évaluateurs d’IA méritent un statut professionnel défini, avec des droits, des formations certifiantes et des perspectives d’évolution claires. Cette professionnalisation bénéficierait autant aux travailleurs qu’à la qualité des systèmes d’intelligence artificielle comme Gemini et ses applications cloud.

FAQ – Questions fréquentes sur l’entraînement de Gemini

Combien d’évaluateurs travaillent sur l’entraînement de Gemini ?

Google emploie plusieurs milliers d’évaluateurs via son sous-traitant GlobalLogic. Le nombre exact reste confidentiel, mais les témoignages évoquent une main-d’œuvre massive répartie principalement aux États-Unis, travaillant sur différents aspects de l’entraînement et de la modération de Gemini.

Quel est le salaire moyen d’un évaluateur IA chez GlobalLogic ?

Les évaluateurs perçoivent entre 16 et 21 dollars de l’heure, soit environ 33 000 à 44 000 dollars par an à temps plein. Cette rémunération reste très inférieure aux salaires des ingénieurs Google travaillant sur les mêmes projets d’intelligence artificielle, créant une disparité importante au sein de l’écosystème Gemini.

Google reconnaît-il officiellement le rôle de ces évaluateurs dans le développement de Gemini ?

Non, Google minimise systématiquement leur contribution. L’entreprise présente ces travailleurs comme de simples « évaluateurs qualité » fournissant des retours externes, niant leur impact direct sur l’amélioration des algorithmes. Cette position permet à Google d’éviter les responsabilités liées aux conditions de travail de cette main-d’œuvre précarisée.

Existe-t-il des protections pour les évaluateurs exposés à des contenus traumatisants ?

Les protections restent largement insuffisantes. La plupart des évaluateurs ne reçoivent aucune formation spécifique à la modération de contenu ni d’accompagnement psychologique. L’absence de formulaires de consentement éclairé aggrave cette situation, exposant les travailleurs à des contenus dérangeants sans préparation adéquate.

Comment cette situation pourrait-elle évoluer dans les années à venir ?

L’évolution dépendra largement de la pression réglementaire et sociale. L’Union européenne développe des réglementations spécifiques, tandis que la sensibilisation croissante du public à l’éthique de l’IA pourrait forcer Google à améliorer ses pratiques. La concurrence avec d’autres IA pourrait également pousser vers des modèles plus éthiques si ceux-ci démontrent leur supériorité qualitative.