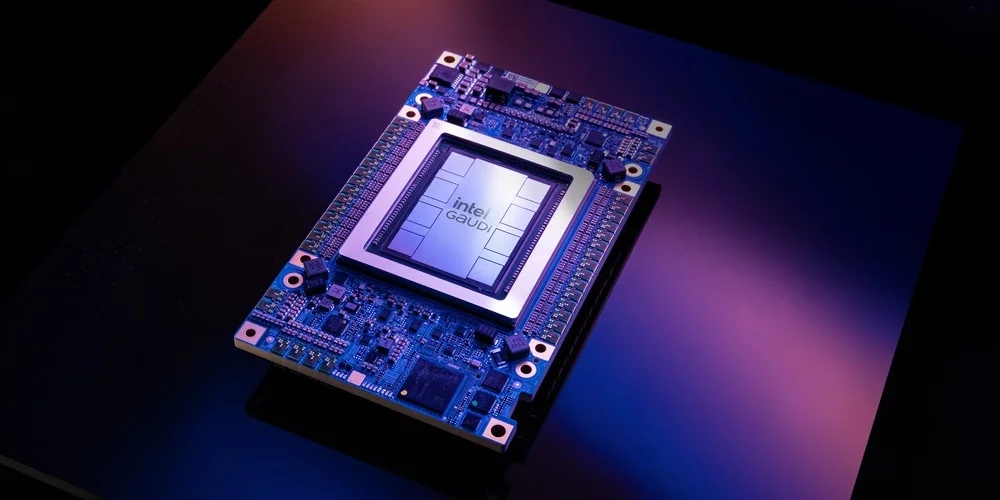

L’hégémonie de NVIDIA sur le marché des puces d’intelligence artificielle vacille. Depuis septembre dernier, OpenAI développe sa propre puce avec une équipe de 40 ingénieurs et le partenaire Broadcom, visant un lancement en 2026. Cette révélation du Financial Times a propulsé l’action Broadcom de 9% en une séance, témoignant de l’appétit des investisseurs pour cette disruption annoncée.

Cette stratégie n’a rien d’isolé. Google, Amazon, Meta et Microsoft orchestrent tous leurs propres projets de semi-conducteurs dédiés à l’IA. Derrière cette course technologique se dessine un enjeu économique colossal : réduire la dépendance aux puces NVIDIA dont les marges atteignent des niveaux stratosphériques.

La bataille des processeurs d’IA redéfinit les équilibres d’un secteur où chaque milliard investi aujourd’hui déterminera les rapports de force de demain.

La domination contestée de NVIDIA face aux géants technologiques

NVIDIA règne en maître absolu sur le marché des processeurs graphiques dédiés à l’intelligence artificielle depuis l’explosion de ChatGPT. Ses puces H100 et A100 équipent la quasi-totalité des centres de données qui alimentent les modèles de langage les plus performants. Cette position dominante génère des revenus record pour l’entreprise californienne, avec des marges brutes dépassant les 70%.

Cependant, cette hégémonie technique s’accompagne d’une facture salée pour les acheteurs. OpenAI débourse plusieurs centaines de millions de dollars annuellement pour ses besoins en calcul, tandis que Microsoft investit des milliards dans l’infrastructure nécessaire au fonctionnement de ses services IA. Cette dépendance économique pousse naturellement les géants technologiques vers l’autonomie.

Les limites économiques du modèle actuel

L’analyse de Sébastien Sztabowicz chez Kepler Cheuvreux révèle la problématique fondamentale : « Depuis le début de l’essor de l’IA, les grands acteurs achètent des puces à Nvidia. Mais ils se disent aujourd’hui qu’il doit y avoir une alternative à la situation actuelle où ils versent des milliards à cette entreprise dont les marges sont très conséquentes. » Cette réflexion stratégique anime désormais toutes les directions techniques des GAFAM.

| Entreprise | Dépenses IA estimées (2024) | Part NVIDIA | Projet puce interne |

|---|---|---|---|

| Microsoft | 15 milliards $ | 60% | Athena |

| 12 milliards $ | 45% | TPU Gen5 | |

| Amazon | 8 milliards $ | 55% | Trainium |

| Meta | 6 milliards $ | 70% | MTIA v2 |

Les tensions géopolitiques compliquent également l’équation. Les restrictions américaines sur l’exportation de puces avancées vers certains pays créent des goulots d’étranglement dans la chaîne d’approvisionnement. Cette situation incite davantage les entreprises à développer leurs propres solutions pour garantir leur indépendance technologique.

- Coûts d’approvisionnement en hausse constante depuis 2022

- Délais de livraison étendus à plus de 12 mois pour certains modèles

- Dépendance stratégique excessive envers un seul fournisseur

- Marges de NVIDIA dépassant celles de l’industrie automobile

- Besoins de personnalisation impossibles avec les solutions standardisées

Les stratégies de développement interne chez les géants de la tech

Google a ouvert la voie dès 2016 avec ses TPU (Tensor Processing Units), spécifiquement conçues pour les calculs de réseaux de neurones. Ces processeurs équipent aujourd’hui l’ensemble de l’infrastructure de recherche Google et permettent l’entraînement des modèles Gemini. La quatrième génération de TPU affiche des performances remarquables, rivalisant directement avec les solutions NVIDIA sur certaines tâches spécialisées.

Amazon développe parallèlement ses puces Graviton pour les serveurs et Trainium pour l’intelligence artificielle. AWS propose désormais ces solutions à ses clients, créant un écosystème alternatif complet. La stratégie amazonienne vise une optimisation parfaite entre hardware et software, promettant des gains d’efficacité énergétique de 40% par rapport aux solutions concurrentes.

L’approche révolutionnaire d’Apple

Apple révolutionne l’approche avec ses puces M4, intégrant des unités de traitement neuronal directement dans les processeurs grand public. Cette stratégie permet de faire tourner des modèles d’IA sophistiqués localement, sans connexion cloud. Les nouvelles générations de MacBook Pro exploitent pleinement ces capacités, offrant une expérience utilisateur inédite.

L’écosystème Apple s’enrichit également grâce à l’ouverture aux développeurs tiers de ses modèles d’intelligence artificielle, créant un cercle vertueux d’innovation. Cette approche hybride, combinant hardware propriétaire et écosystème ouvert, pourrait redéfinir les standards de l’industrie.

| Constructeur | Nom de puce | Année lancement | Performance TOPS | Consommation watts |

|---|---|---|---|---|

| TPU v5e | 2024 | 393 | 230 | |

| Amazon | Trainium2 | 2024 | 340 | 190 |

| Apple | M4 Max | 2024 | 38 | 92 |

| Microsoft | Athena | 2025 | 450 | 280 |

Meta développe sa propre architecture MTIA (Meta Training and Inference Accelerator), optimisée spécifiquement pour les besoins de ses plateformes sociales. Cette approche verticalement intégrée permet d’optimiser chaque étape, depuis la collecte de données jusqu’à la recommandation de contenu, en passant par l’entraînement des modèles de modération automatique.

- Réduction des coûts opérationnels de 30 à 50% selon les estimations internes

- Optimisation énergétique avec des gains de consommation significatifs

- Personnalisation complète selon les besoins applicatifs

- Indépendance géopolitique et sécuritaire renforcée

- Innovation accélérée grâce au contrôle de la chaîne complète

Les enjeux techniques et économiques de la conception de puces IA

Concevoir une puce d’intelligence artificielle représente un défi technique colossal. Contrairement aux processeurs généralistes, ces composants doivent exceller dans des opérations matricielles massives, avec des milliers de calculs parallèles. OpenAI s’associe avec Broadcom pour bénéficier de cette expertise spécialisée, évitant les écueils d’un développement entièrement interne.

La complexité technique se manifeste à plusieurs niveaux. D’abord, l’architecture doit optimiser les transferts de données entre mémoire et unités de calcul. Ensuite, la gestion thermique devient cruciale pour maintenir les performances sous charge intensive. Enfin, l’intégration logicielle nécessite des pilotes et frameworks dédiés pour exploiter pleinement le hardware.

Les défis de la fabrication à grande échelle

La production physique des puces représente un autre défi majeur. Samsung et TSMC dominent la fabrication des semi-conducteurs avancés, créant une nouvelle forme de dépendance pour les entreprises technologiques. TSMC dévoile régulièrement ses innovations, repoussant les limites de la miniaturisation.

Cette concentration géographique en Asie soulève des questions stratégiques. Les gouvernements occidentaux investissent massivement dans la relocalisation de ces capacités productives. Le CHIPS Act américain et les initiatives européennes visent à réduire cette dépendance, mais les délais de construction des fabs se comptent en années.

| Fondeur | Technologie avancée | Clients IA majeurs | Capacité mensuelle | Investissement 2024-2026 |

|---|---|---|---|---|

| TSMC | 3nm, 2nm | Apple, NVIDIA, AMD | 150 000 wafers | 40 milliards $ |

| Samsung | 3nm, 2nm | Qualcomm, Google | 100 000 wafers | 25 milliards $ |

| Intel | Intel 4, Intel 3 | Intel, clients tiers | 80 000 wafers | 100 milliards $ |

Les coûts de développement explosent également. Créer une nouvelle puce avancée nécessite entre 300 millions et 1 milliard de dollars d’investissement initial. Ces montants incluent la recherche, la conception, les masques de photolithographie et les premiers lots de production. Seules les entreprises disposant de volumes importants peuvent amortir de tels investissements.

- Coût de développement d’une puce 5nm : 500-800 millions de dollars

- Délai moyen de conception à production : 24-36 mois

- Taux d’échec des nouveaux projets : 40-50%

- Investissement R&D annuel nécessaire : 2-5% du chiffre d’affaires

- Compétences rares : moins de 10 000 ingénieurs qualifiés mondialement

Qualcomm illustre parfaitement cette approche avec ses processeurs Snapdragon intégrant des accélérateurs IA pour smartphones. L’entreprise investit massivement dans l’optimisation énergétique, crucial pour les appareils mobiles. Cette expertise positionne Qualcomm comme partenaire privilégié pour les constructeurs cherchant à intégrer l’IA dans leurs produits grand public.

L’impact sur l’écosystème technologique et la concurrence

La prolifération des puces IA propriétaires redessine fondamentalement l’écosystème technologique. Chaque entreprise développe désormais sa stack complète, depuis le silicium jusqu’aux applications finales. Cette verticalisation rappelle les stratégies d’intégration des années 1980-90, mais à une échelle et avec une complexité inédites.

Google exemplifie cette transformation avec sa stratégie d’optimisation énergétique de l’IA. L’intégration hardware-software permet des gains d’efficacité impossibles avec des solutions génériques. Les TPU Google consomment significativement moins d’énergie que les GPU traditionnels pour des tâches équivalentes.

Les nouvelles dynamiques concurrentielles

Cette évolution crée de nouveaux rapports de force. IBM repositionne ses puces neuromorphiques pour des applications spécialisées, tandis que des startups émergent avec des architectures révolutionnaires. La compétition ne se limite plus aux performances brutes mais englobe l’efficacité énergétique, la facilité d’intégration et l’écosystème logiciel associé.

Les partenariats stratégiques se multiplient également. OpenAI s’attaque directement à la domination de NVIDIA en développant ses propres solutions, mais s’appuie sur Broadcom pour accélérer le processus. Cette approche hybride devient la norme, combinant expertise interne et partenariats ciblés.

| Modèle de développement | Avantages | Inconvénients | Exemples |

|---|---|---|---|

| 100% interne | Contrôle total, IP propriétaire | Coûts élevés, risques techniques | Apple M-series |

| Partenariat fondeur | Expertise externe, coûts partagés | Dépendance, confidentialité | OpenAI-Broadcom |

| Acquisition startup | Innovation rapide, talents | Intégration complexe, prix élevé | Intel-Nervana |

| Consortium industriel | Mutualisation des coûts | Compromis techniques | RISC-V Foundation |

L’impact sur l’innovation accélère également. Google intègre désormais l’IA directement dans les smartphones, créant de nouveaux usages impossibles avec l’architecture cloud traditionnelle. Cette miniaturisation de l’intelligence artificielle ouvre des marchés entiers, depuis les objets connectés jusqu’aux véhicules autonomes.

- Réduction des latences grâce au traitement local

- Protection de la vie privée avec des données non transmises

- Nouvelles applications temps réel impossibles via cloud

- Démocratisation de l’IA dans tous les appareils

- Écosystèmes fermés favorisant la fidélisation client

Les implications géopolitiques se renforcent parallèlement. Les puces d’IA deviennent un enjeu de souveraineté nationale, poussant les gouvernements à soutenir leurs champions industriels. Cette dimension politique influence les choix technologiques et crée de nouveaux blocs concurrentiels à l’échelle mondiale.

Les perspectives d’évolution du marché des semi-conducteurs IA

L’horizon 2026-2030 s’annonce décisif pour le marché des puces d’intelligence artificielle. Tesla développe ses propres puces AI5 et AI6, confirmant que l’automotive rejoint la course à l’indépendance technologique. Cette diversification sectorielle multiplie les investissements et accélère l’innovation.

Les technologies émergentes révolutionnent également l’approche traditionnelle. Les puces photoniques promettent des gains de performance spectaculaires pour certaines applications IA. Les architectures neuromorphiques, inspirées du fonctionnement du cerveau humain, ouvrent des perspectives d’efficacité énergétique inédites. Ces innovations de rupture pourraient redistribuer complètement les cartes du secteur.

L’émergence de nouveaux acteurs disruptifs

Parallèlement aux géants établis, de nouvelles startups émergent avec des approches révolutionnaires. Graphcore avec ses IPU (Intelligence Processing Units), Cerebras avec ses wafers géants, ou SambaNova avec son architecture dataflow repoussent les limites techniques traditionnelles. Ces innovateurs forcent les acteurs historiques à repenser leurs stratégies.

| Technologie émergente | Principe | Avantages potentiels | Maturité commerciale | Acteurs principaux |

|---|---|---|---|---|

| Photonique | Calculs optiques | Vitesse lumière, faible consommation | R&D avancée | Lightmatter, Intel |

| Neuromorphique | Architecture cerveau | Efficacité énergétique extrême | Prototypes | Intel Loihi, IBM TrueNorth |

| Quantique | Superposition quantique | Calculs exponentiellement plus rapides | Recherche fondamentale | IBM, Google, IonQ |

| Memristors | Mémoire résistive | Fusion calcul-stockage | Développement | HP, Crossbar |

La consolidation du marché s’accélère également. Les coûts de développement astronomiques favorisent les rapprochements et acquisitions. Seules les entreprises atteignant une taille critique peuvent rivaliser avec les leaders établis. Cette dynamique concentre progressivement l’innovation dans un nombre restreint d’acteurs globaux.

- Investissement minimum pour rester compétitif : 1 milliard de dollars annuels

- Délai de développement raccourci à 18-24 mois sous pression concurrentielle

- Spécialisation croissante par segment applicatif

- Standardisation progressive des interfaces et protocoles

- Émergence de solutions modulaires et configurables

Apple intensifie sa production de puces pour iPhone, illustrant parfaitement cette tendance à la verticalisation complète. L’intégration de l’IA dans chaque composant électronique devient la norme, créant des synergies impossibles avec l’approche modulaire traditionnelle.

Les régulations gouvernementales influencent également l’évolution du secteur. Les restrictions sur les exportations de technologies sensibles fragmentent le marché mondial en blocs géographiques. Cette balkanisation technologique pousse chaque région à développer ses propres solutions, multipliant les investissements mais réduisant les économies d’échelle.

Apple domine désormais le marché PC grâce à ses puces IA intégrées, démontrant l’impact concurrentiel de cette stratégie d’intégration verticale. Cette réussite inspire d’autres acteurs à suivre une approche similaire, accélérant la transformation de l’industrie.

FAQ : Tout savoir sur les puces IA des géants technologiques

Pourquoi les entreprises technologiques développent-elles leurs propres puces IA ?

Les entreprises cherchent principalement à réduire leur dépendance économique envers NVIDIA, dont les marges dépassent 70%. En développant leurs propres puces, elles peuvent optimiser les performances pour leurs besoins spécifiques tout en contrôlant leurs coûts d’infrastructure. Cette stratégie permet également une meilleure intégration entre hardware et software, générant des gains d’efficacité impossibles avec des solutions génériques.

Quels sont les défis techniques du développement de puces IA ?

Concevoir une puce d’IA nécessite d’optimiser les calculs matriciels parallèles, gérer efficacement la mémoire et contrôler la dissipation thermique. Les coûts de développement oscillent entre 300 millions et 1 milliard de dollars, avec des délais de 24 à 36 mois entre conception et production. L’expertise requise est extrêmement rare, avec moins de 10 000 ingénieurs qualifiés mondialement.

Comment cette évolution impact-t-elle la concurrence dans l’IA ?

La prolifération des puces propriétaires crée des écosystèmes fermés où chaque entreprise contrôle sa chaîne complète, du silicium aux applications. Cette verticalisation favorise l’innovation mais fragmente le marché. Les startups et petits acteurs peinent à rivaliser face aux investissements colossaux requis, concentrant progressivement l’innovation dans un nombre restreint de géants technologiques.

Quand les premières puces OpenAI seront-elles disponibles ?

OpenAI vise un lancement commercial de sa première puce interne en 2026. L’entreprise collabore avec Broadcom et a constitué une équipe dédiée de 40 ingénieurs pour ce projet. Cette timeline reste ambitieuse compte tenu de la complexité technique et des défis de production à grande échelle dans l’industrie des semi-conducteurs.

Les puces IA spécialisées remplaceront-elles complètement les GPU NVIDIA ?

Non, une coexistence est plus probable qu’une substitution totale. Les GPU NVIDIA restent excellents pour certaines tâches et offrent une flexibilité appréciée par de nombreux développeurs. Les puces spécialisées domineront les applications où l’optimisation extrême justifie l’investissement, tandis que les GPU généralistes conserveront des segments importants, notamment pour la recherche et les petites structures.