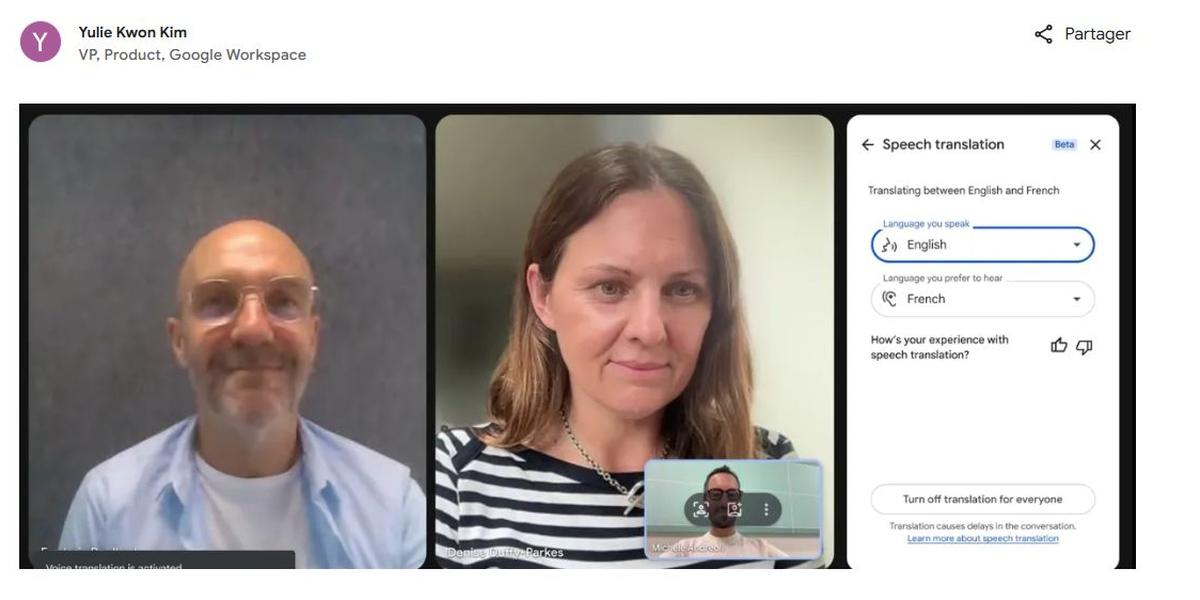

Google Meet franchit un cap décisif dans la communication internationale en déployant la traduction vocale en temps réel sur ses applications mobiles Android et iOS. Cette avancée majeure transforme radicalement l’expérience utilisateur en permettant aux professionnels du monde entier de collaborer sans contrainte linguistique, où qu’ils se trouvent. Disponible pour les abonnés Google Workspace éligibles, cette fonctionnalité intègre l’intelligence artificielle de Google pour offrir des sous-titres traduits instantanément lors des appels vidéo, éliminant ainsi la barrière de la langue pour les équipes nomades et les organisations internationales.

La révolution mobile de la traduction vocale dans Google Meet

Pendant des années, les utilisateurs de Google Meet sur mobile ont dû composer avec une expérience appauvrie comparée à la version bureau. La traduction des sous-titres en temps réel restait l’apanage exclusif des navigateurs web, créant une frustration croissante chez les professionnels en déplacement. Cette asymétrie technologique appartient désormais au passé avec le déploiement officiel de cette capacité sur Android et iOS.

L’impact de cette nouveauté dépasse largement le simple confort d’usage. Dans un contexte professionnel où le télétravail s’est définitivement installé et où les déplacements internationaux reprennent leur rythme d’avant-pandémie, pouvoir participer pleinement à une réunion multilingue depuis un taxi parisien ou une salle d’attente d’aéroport devient un atout stratégique majeur. L’accessibilité à l’information en temps réel n’est plus conditionnée par la présence devant un ordinateur de bureau.

Cette évolution s’inscrit dans une stratégie globale de Google visant à intégrer l’intelligence artificielle au cœur de ses outils de productivité. Les ingénieurs de Mountain View ne se contentent pas d’ajouter des fonctionnalités : ils redéfinissent les standards de la communication professionnelle. L’objectif affiché est de rendre les échanges aussi naturels que possible, indépendamment des langues maternelles des participants.

Les premiers retours d’utilisateurs soulignent la fluidité remarquable du système. Un directeur commercial allemand peut désormais présenter ses résultats en allemand à des collègues français qui suivent la conversation grâce aux sous-titres traduits automatiquement. Cette démocratisation linguistique favorise une participation plus active de tous les membres d’une équipe internationale, quelle que soit leur maîtrise de l’anglais, traditionnellement langue véhiculaire des affaires.

La dimension mobile de cette fonctionnalité transforme également les pratiques de formation à distance. Les formateurs peuvent maintenant animer des sessions pour des publics internationaux sans nécessiter de traducteurs simultanés, réduisant ainsi considérablement les coûts logistiques tout en élargissant leur audience potentielle. Cette accessibilité renforcée ouvre de nouvelles opportunités pour l’éducation et le transfert de compétences à l’échelle mondiale.

Une réponse concrète aux besoins des organisations globales

Les entreprises multinationales ont longtemps cherché des solutions efficaces pour faciliter la collaboration entre leurs équipes dispersées géographiquement. Les services de traduction humaine coûtent cher et ne peuvent pas couvrir toutes les interactions quotidiennes. Les outils de traduction existants nécessitaient souvent de jongler entre plusieurs applications, créant des ruptures dans le flux de communication.

Avec la traduction vocale intégrée nativement dans Google Meet sur mobile, cette complexité disparaît. Les participants se concentrent sur le contenu des échanges plutôt que sur les obstacles techniques. Cette simplification encourage également les collaborateurs moins à l’aise avec les technologies à participer activement aux réunions virtuelles, favorisant ainsi une culture d’entreprise plus inclusive.

| Fonctionnalité | Version Bureau | Version Mobile (2026) |

|---|---|---|

| Sous-titres automatiques | Disponible | Disponible |

| Traduction en temps réel | Disponible depuis 2024 | Disponible depuis 2026 |

| Langues supportées | Plus de 20 langues | Langues principales (expansion progressive) |

| Qualité audio requise | Standard | Connexion stable recommandée |

Le fonctionnement technique de la traduction vocale sur mobile

Derrière l’apparente simplicité d’utilisation se cache une prouesse technologique remarquable. Le processus de traduction vocale repose sur une chaîne de traitements complexes orchestrés par l’intelligence artificielle de Google. Comprendre ces mécanismes permet d’apprécier la sophistication de l’outil et d’optimiser son utilisation dans différents contextes professionnels.

La première étape consiste en une capture audio haute définition de la voix de l’orateur. Cette captation utilise des algorithmes de réduction de bruit sophistiqués pour isoler la voix humaine des bruits ambiants, particulièrement importants dans un environnement mobile où les conditions acoustiques varient considérablement. Le système distingue les voix multiples lors de réunions avec plusieurs participants, attribuant correctement chaque phrase au locuteur correspondant.

Une fois l’audio isolé, la technologie Speech-to-Text de Google entre en action. Cette couche de reconnaissance vocale convertit les ondes sonores en texte brut dans la langue originale. La précision de cette transcription dépend de plusieurs facteurs : la clarté de l’élocution, la qualité de la connexion réseau, et la présence d’accents régionaux. Les modèles linguistiques de Google, entraînés sur des milliards de phrases, gèrent remarquablement bien les variations dialectales et les termes techniques spécialisés.

La troisième phase fait intervenir les modèles de traduction neuronale développés par Google. Ces systèmes d’IA ne traduisent pas mot à mot mais comprennent le contexte sémantique global de chaque phrase pour produire des traductions naturelles et idiomatiques. Cette approche contextuelle évite les traductions littérales maladroites qui caractérisaient les premiers outils de traduction automatique.

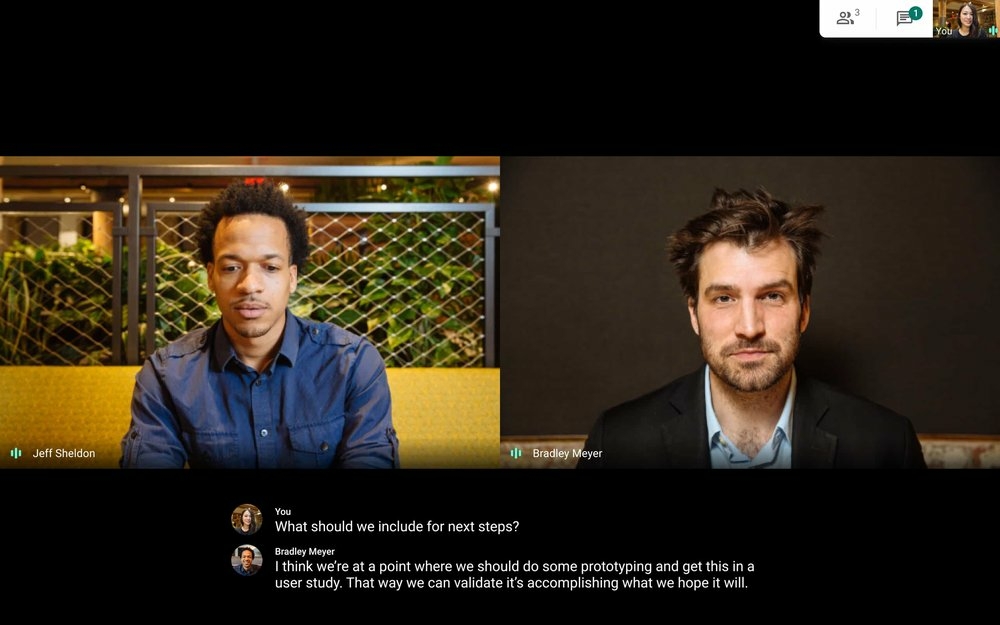

Enfin, les sous-titres traduits s’affichent au bas de l’écran avec une synchronisation quasi parfaite avec la parole originale. Le délai entre l’émission vocale et l’affichage du texte traduit oscille généralement entre une et trois secondes, selon la complexité syntaxique de la phrase et la charge des serveurs. Cette latence minimale préserve la fluidité conversationnelle, permettant des échanges spontanés plutôt que des monologues alternés.

Les technologies d’intelligence artificielle mobilisées

Google s’appuie sur plusieurs générations de ses technologies d’IA pour alimenter cette fonctionnalité. Les réseaux de neurones transformateurs, architecture révolutionnaire introduite en 2017, constituent la colonne vertébrale du système de traduction. Ces modèles analysent simultanément l’ensemble d’une phrase plutôt que de la traiter séquentiellement, capturant ainsi les dépendances longues distance essentielles pour une traduction précise.

L’apprentissage automatique continu améliore constamment la qualité des traductions. Chaque interaction avec le système génère des données d’entraînement supplémentaires, permettant aux algorithmes d’affiner leur compréhension des nuances linguistiques et des contextes professionnels spécifiques. Cette boucle d’amélioration garantit que le service devient progressivement plus performant avec l’usage collectif.

Guide pratique pour activer la traduction vocale sur Android et iOS

L’activation de la traduction dans Google Meet sur mobile suit un processus standardisé conçu pour sa simplicité. Néanmoins, certaines conditions préalables doivent être remplies pour accéder à cette fonctionnalité avancée. La compréhension de ces prérequis évite les déconvenues lors de la première tentative d’utilisation.

Première exigence incontournable : disposer d’un compte Google Workspace éligible. Les utilisateurs gratuits de Google Meet ne peuvent malheureusement pas bénéficier de cette fonctionnalité premium. Les éditions Business Standard, Business Plus, Enterprise Starter, Enterprise Standard et Enterprise Plus donnent accès à la traduction vocale. Les établissements éducatifs bénéficient également de cette capacité via les licences Education Plus et Teaching and Learning Upgrade.

Une fois cette condition remplie, la procédure d’activation proprement dite se déroule en quelques étapes intuitives. Au début de la réunion ou pendant son déroulement, l’utilisateur accède au menu des paramètres en tapant sur les trois points verticaux généralement situés en bas à droite de l’écran. Dans ce menu contextuel, l’option « Sous-titres » apparaît clairement.

- Étape 1 : Rejoindre ou lancer une réunion Google Meet depuis l’application mobile

- Étape 2 : Toucher l’icône des trois points verticaux pour ouvrir le menu des options

- Étape 3 : Sélectionner « Sous-titres » dans la liste des fonctionnalités disponibles

- Étape 4 : Choisir la langue de traduction souhaitée dans le menu déroulant

- Étape 5 : Valider le choix pour voir apparaître les sous-titres traduits en temps réel

La sélection de la langue cible révèle une liste des langues prises en charge. Initialement, les combinaisons les plus courantes sont privilégiées : anglais vers français, allemand, portugais, espagnol, et réciproquement. Google enrichit progressivement ce catalogue avec des langues supplémentaires en fonction des usages constatés et des demandes utilisateurs.

Différences d’interface entre Android et iOS

Bien que la fonctionnalité soit identique sur les deux plateformes, quelques subtilités d’interface méritent d’être soulignées. Sur Android, l’intégration native avec l’écosystème Google permet parfois une activation légèrement plus rapide, avec des suggestions contextuelles de langues basées sur les participants à la réunion et leurs profils linguistiques.

Sur iOS, le respect des guidelines d’Apple impose une présentation légèrement différente des menus, mais l’accessibilité reste optimale. Les utilisateurs d’iPhone apprécient particulièrement l’intégration avec les fonctionnalités d’accessibilité natives d’iOS, comme VoiceOver, qui peuvent lire à voix haute les sous-titres traduits pour les personnes malvoyantes.

Un point essentiel à comprendre : la traduction s’applique exclusivement aux sous-titres affichés à l’écran. L’audio original reste inchangé, préservant l’intonation et l’émotion de l’orateur. Cette approche présente plusieurs avantages : elle maintient l’authenticité de la communication non verbale, permet aux participants bilingues de suivre simultanément l’audio et le texte traduit, et évite les décalages gênants qu’engendreraient des doublages vocaux synthétiques.

Optimisation de l’expérience utilisateur sur smartphone

Tirer pleinement parti de la traduction vocale sur mobile nécessite quelques ajustements techniques et organisationnels. L’environnement mobile présente des contraintes spécifiques absentes lors d’une utilisation sur ordinateur de bureau : écran plus petit, conditions réseau variables, mobilité physique de l’utilisateur. Anticiper ces paramètres garantit une expérience fluide et productive.

La stabilité de la connexion internet constitue le facteur critique numéro un. La traduction en temps réel exige un flux bidirectionnel constant de données entre le smartphone et les serveurs de Google. Une connexion 4G peut suffire dans des conditions optimales, mais la 5G ou un réseau Wi-Fi robuste offrent la sécurité d’une latence minimale et d’une absence d’interruption. Les professionnels fréquemment en déplacement devraient privilégier les forfaits mobiles généreux ou identifier à l’avance les points d’accès Wi-Fi fiables.

L’utilisation d’un casque ou d’écouteurs avec microphone améliore significativement la qualité de capture vocale. Ces accessoires isolent la voix de l’utilisateur des bruits ambiants, permettant au système de reconnaissance vocale de travailler dans des conditions optimales. Les écouteurs sans fil Bluetooth modernes offrent un excellent compromis entre mobilité et qualité audio, bien que les modèles filaires garantissent une latence encore plus faible.

L’orientation de l’écran joue un rôle souvent sous-estimé dans la lisibilité des sous-titres. Le passage en mode paysage (horizontal) permet d’afficher des lignes de texte plus longues sans retour à la ligne prématuré. Cette continuité visuelle facilite grandement la lecture rapide, particulièrement pour les langues à syntaxe complexe ou les phrases techniques comportant de nombreux termes spécialisés. Certains smartphones récents ajustent automatiquement la taille des caractères en fonction de l’orientation, optimisant davantage l’expérience.

Conseils pratiques pour différents contextes d’usage

En situation de mobilité intense, comme dans les transports en commun, activer le mode « Ne pas déranger » sur le smartphone évite que les notifications intempestives n’interrompent la réunion. Cette précaution semble basique mais reste fréquemment négligée, causant des distractions évitables. Configurer Google Meet pour qu’il passe automatiquement en mode plein écran élimine également les distractions visuelles.

Pour les réunions particulièrement importantes nécessitant une accessibilité maximale aux informations échangées, enregistrer la session permet de revisiter ultérieurement les passages cruciaux. Google Meet conserve les sous-titres dans l’enregistrement, offrant la possibilité de vérifier a posteriori la précision de certaines traductions ou de clarifier des points ambigus. Cette fonctionnalité s’avère précieuse lors de négociations contractuelles ou de formations techniques complexes.

Adapter sa propre élocution favorise également une traduction de meilleure qualité. Parler à un rythme modéré, articuler clairement sans exagération, et structurer ses phrases de manière relativement simple facilite le travail des algorithmes de reconnaissance et de traduction. Cette adaptation ne signifie pas simplifier le contenu intellectuel mais plutôt privilégier la clarté syntaxique à l’élégance stylistique complexe.

Impact sur l’accessibilité et l’inclusion professionnelle

Au-delà des considérations purement linguistiques, la traduction vocale dans Google Meet transforme profondément l’accessibilité des appels vidéo professionnels. Les personnes sourdes ou malentendantes disposent désormais d’un outil mobile leur permettant de participer pleinement aux réunions, même en déplacement. Cette autonomie retrouvée modifie les dynamiques de pouvoir au sein des organisations et ouvre des opportunités professionnelles auparavant limitées par des contraintes techniques.

L’impact se révèle particulièrement significatif pour les professionnels issus de pays non anglophones. Historiquement, la maîtrise de l’anglais constituait un prérequis implicite pour accéder à certaines fonctions internationales. La démocratisation de la traduction instantanée redessine progressivement ces hiérarchies linguistiques. Un expert technique japonais peut maintenant partager son expertise avec des collègues brésiliens sans que la langue ne constitue un obstacle insurmontable.

Les équipes multiculturelles constatent également une amélioration de la cohésion interne. Lorsque chaque membre peut s’exprimer dans sa langue maternelle tout en étant compris de tous, les échanges gagnent en authenticité et en profondeur. Les nuances émotionnelles et les subtilités culturelles se transmettent mieux que dans l’utilisation maladroite d’une langue commune imparfaitement maîtrisée. Cette authenticité renforce la confiance mutuelle, ingrédient essentiel de la collaboration efficace.

Les organisations internationales et ONG opérant dans des contextes multilingues complexes trouvent dans cette technologie un levier d’efficacité opérationnelle considérable. Les coûts de traduction diminuent drastiquement, permettant de réallouer ces ressources vers les missions principales. La rapidité de coordination s’améliore, des décisions urgentes pouvant être prises collectivement sans attendre la disponibilité de traducteurs humains.

Vers une redéfinition des compétences professionnelles valorisées

Cette évolution technologique interroge inévitablement la place du multilinguisme comme compétence professionnelle distinctive. Faut-il encore investir temps et ressources dans l’apprentissage des langues étrangères si la traduction instantanée devient omniprésente et fiable ? La réponse nuancée distingue la compréhension fonctionnelle de la maîtrise culturelle profonde.

Les outils de traduction automatique excellent dans la transmission d’informations factuelles et techniques. Ils permettent effectivement de mener des réunions opérationnelles sans connaissance préalable de la langue de l’interlocuteur. En revanche, la subtilité des jeux de mots, la détection de l’ironie, ou la compréhension fine des références culturelles échappent encore largement aux algorithmes, aussi sophistiqués soient-ils.

L’apprentissage des langues conserve donc sa valeur pour les professionnels visant des postes stratégiques nécessitant une compréhension intime des marchés étrangers. La technologie démocratise l’accès à la communication multilingue fonctionnelle, tandis que la maîtrise linguistique humaine se repositionne comme avantage compétitif pour les interactions à forte charge culturelle ou émotionnelle.

Perspectives d’évolution et innovations attendues

Le déploiement actuel de la traduction vocale sur mobile ne représente qu’une première étape dans la feuille de route ambitieuse de Google. Les équipes de développement travaillent déjà sur plusieurs axes d’amélioration qui transformeront encore davantage l’expérience utilisateur dans les mois et années à venir.

L’extension du catalogue linguistique figure parmi les priorités immédiates. Si les langues européennes et asiatiques majeures sont actuellement couvertes, des langues moins répandues mais essentielles pour certaines régions économiques intégreront progressivement le système. Les dialectes régionaux, longtemps négligés par les systèmes de traduction automatique, bénéficient également d’efforts de recherche soutenus.

Une innovation particulièrement attendue concerne la traduction vocale synthétique. Contrairement au système actuel qui traduit uniquement les sous-titres textuels, cette fonctionnalité future générerait une voix de synthèse prononçant la traduction. L’utilisateur pourrait choisir d’écouter soit l’audio original, soit la version traduite vocalement, ou même les deux simultanément avec des niveaux de volume ajustables. Cette évolution soulève toutefois des questions ergonomiques complexes : comment préserver la spontanéité des échanges si chacun écoute une voix robotique plutôt que l’intonation naturelle de l’orateur ?

L’intégration avec les capacités conversationnelles avancées de Gemini promet également des développements intéressants. L’IA pourrait non seulement traduire mais aussi résumer automatiquement les points clés d’une réunion multilingue, identifier les actions à entreprendre, ou même suggérer des clarifications lorsqu’une ambiguïté linguistique risque de générer des malentendus.

L’enjeu de la confidentialité des données

Toute technologie impliquant le traitement vocal et textuel soulève légitimement des questions de confidentialité. Google assure que les données audio transitant par ses systèmes de traduction sont chiffrées de bout en bout et ne sont pas conservées au-delà du temps strictement nécessaire au traitement. Les entreprises particulièrement sensibles à la sécurité informatique peuvent néanmoins s’interroger sur les risques théoriques d’interception ou d’accès non autorisé.

Les options de confidentialité renforcée, actuellement réservées aux comptes Enterprise Plus, permettent un contrôle granulaire sur le stockage et le traitement des données conversationnelles. Les administrateurs IT peuvent désactiver certaines fonctionnalités d’IA si elles entrent en conflit avec les politiques de sécurité organisationnelles, sacrifiant potentiellement une partie de la fonctionnalité au profit d’une sécurité accrue.

La transparence de Google sur ces aspects techniques demeure perfectible. Les utilisateurs professionnels avertis souhaitent des informations détaillées sur les serveurs traitant leurs données vocales, la durée exacte de conservation temporaire, et les protocoles d’anonymisation appliqués. Cette demande de clarté s’intensifiera probablement avec la généralisation de l’usage, poussant l’entreprise à communiquer plus explicitement sur son architecture de sécurité.

Google Meet propose-t-il la traduction vocale sur toutes les formules d’abonnement ?

Non, la traduction vocale en temps réel sur mobile est réservée aux abonnés Google Workspace disposant des éditions Business Standard, Business Plus, Enterprise (toutes versions), Education Plus et Teaching and Learning Upgrade. Les comptes gratuits ne peuvent pas accéder à cette fonctionnalité avancée.

Combien de langues sont prises en charge par la traduction sur Google Meet mobile ?

Au lancement en 2026, les principales combinaisons linguistiques incluent l’anglais, le français, l’allemand, le portugais et l’espagnol. Google enrichit progressivement ce catalogue avec de nouvelles langues en fonction de la demande utilisateur et des développements technologiques de ses modèles d’IA.

La traduction fonctionne-t-elle également pour l’audio ou seulement pour les sous-titres ?

Actuellement, seuls les sous-titres affichés à l’écran sont traduits. L’audio original reste inchangé, préservant l’intonation et l’émotion de l’orateur. Une traduction vocale synthétique pourrait être développée ultérieurement, mais elle n’est pas disponible pour le moment.

Quelle qualité de connexion internet est nécessaire pour utiliser la traduction en temps réel ?

Une connexion 5G ou Wi-Fi stable est fortement recommandée pour garantir une latence minimale entre la parole et l’affichage des sous-titres traduits. Une connexion 4G peut fonctionner dans des conditions optimales, mais risque de générer des décalages gênants ou des interruptions lors de fluctuations du débit réseau.

Cette fonctionnalité aide-t-elle les personnes malentendantes ?

Absolument. Au-delà de la traduction linguistique, les sous-titres automatiques avec traduction offrent une accessibilité précieuse aux personnes sourdes ou malentendantes, leur permettant de participer pleinement aux réunions professionnelles même en situation de mobilité, où les contraintes techniques étaient auparavant plus importantes.