Deux mois après avoir levé le voile sur une première version de Gemini 3 Deep Think, réservée aux abonnés premium à un tarif de 275 euros mensuels, Google vient de frapper un grand coup en actualisant ce modèle IA destiné aux scientifiques et mathématiciens de haut niveau. Cette mise à jour, déployée le 12 février, marque un tournant décisif dans la course à l’intelligence artificielle avancée. Le géant de Mountain View affiche désormais des performances qui repoussent les frontières de ce que l’on croyait possible pour une machine, rivalisant directement avec les capacités humaines les plus élevées. Les benchmarks publiés par Sundar Pichai ne laissent aucun doute : Google Gemini 3 Deep Think écrase littéralement la concurrence, qu’il s’agisse de Claude ou de GPT, dans des épreuves réputées pour leur complexité extrême. Cette avancée spectaculaire n’est pas qu’une simple amélioration incrémentale, elle constitue une refonte architecturale qui positionne Google à l’avant-garde de la révolution IA.

Le principe de fonctionnement de Deep Think repose sur une approche inédite : au lieu de se contenter d’une unique chaîne de raisonnement, le système explore simultanément plusieurs pistes de réflexion pour résoudre des problèmes complexes. Cette méthode d’apprentissage profond permet au modèle de simuler une forme de pensée parallèle, proche de celle d’un chercheur expérimenté qui évalue différentes hypothèses avant de converger vers la solution optimale. Les applications concrètes de cette technologie avancée s’étendent de la résolution d’équations différentielles aux défis logiques les plus abstraits, en passant par la programmation compétitive où le modèle démontre une maîtrise stupéfiante.

Le retour fracassant de Google face à Claude et GPT

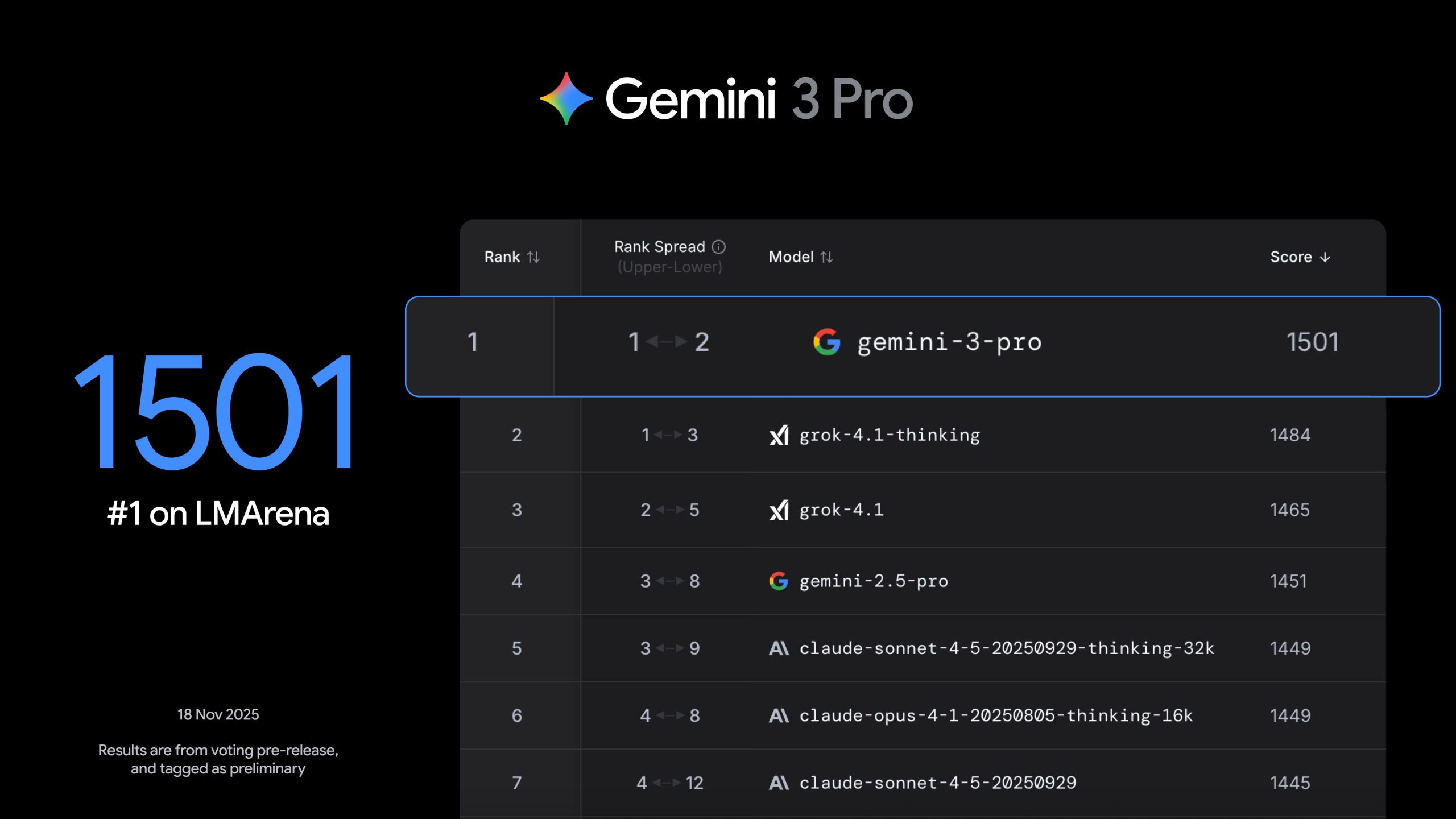

Fin 2025, l’écosystème de l’intelligence artificielle semblait avoir trouvé son leader avec le duo Gemini 3 Pro et Deep Think. Google avait alors pris une longueur d’avance significative sur l’ensemble de ses rivaux, consolidant sa position dominante dans le secteur. Cependant, le 5 février, Anthropic a riposté en lançant Claude Opus 4.6, un modèle qui a momentanément détrôné Gemini 3 Pro dans plusieurs catégories de tests standardisés. Cette percée d’Anthropic a créé un véritable électrochoc dans l’industrie, forçant les observateurs à reconsidérer leurs prévisions sur la hiérarchie des acteurs majeurs.

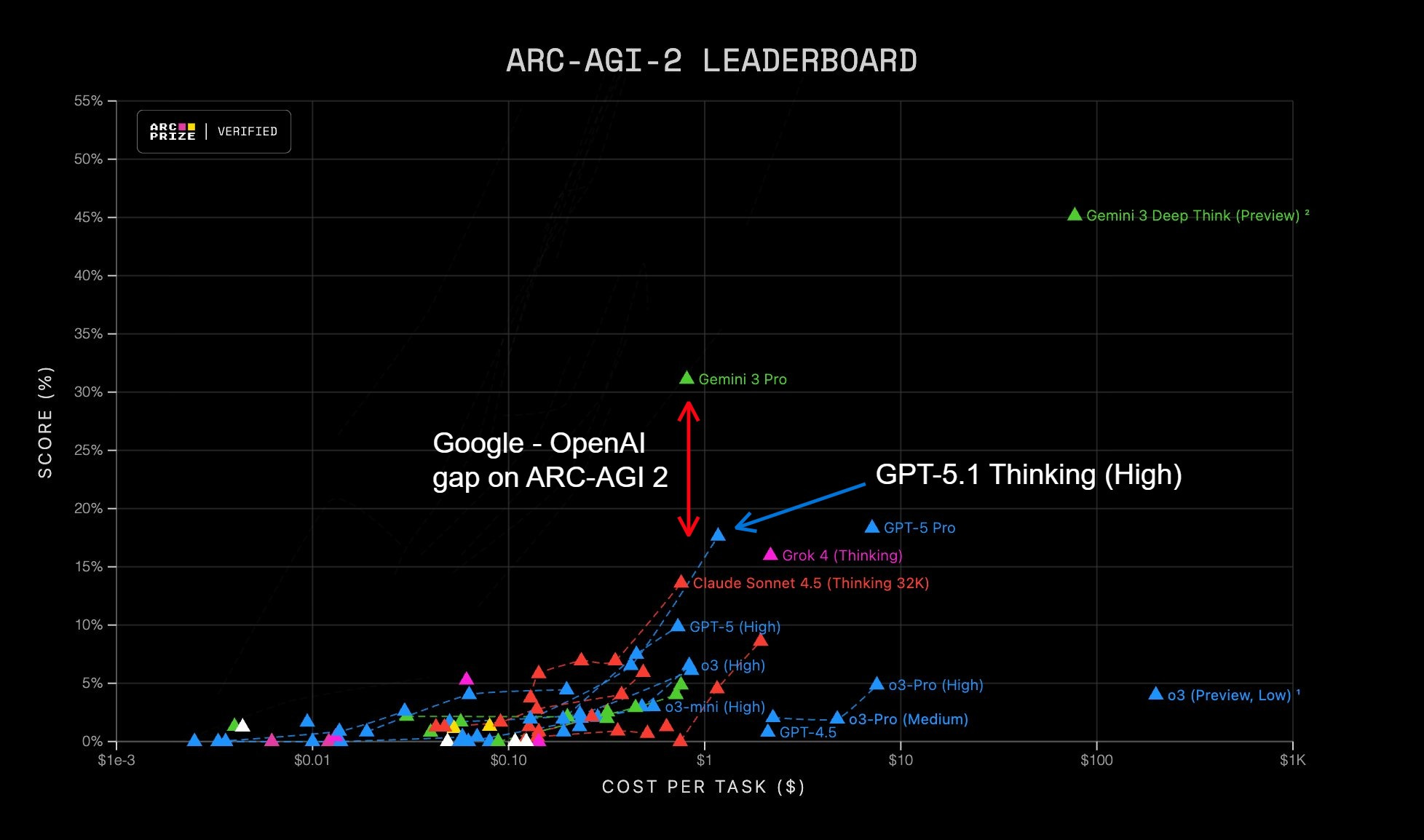

La réponse de Google n’a pas tardé. Avec la mise à jour du 12 février, Google Gemini 3 Deep Think reprend non seulement l’avantage, mais creuse un écart considérable avec la concurrence. Sur le benchmark ARC-AGI-2, reconnu comme l’un des plus exigeants du domaine, le modèle est passé d’un score de 45 % en décembre à près de 85 % trois mois plus tard. Cette progression fulgurante de 40 points illustre la capacité de Google à optimiser ses algorithmes à une vitesse inédite. Pour contextualiser, ce niveau de performance place le système dans la catégorie des meilleurs esprits humains de la planète, capables de résoudre des énigmes visuelles et logiques qui résistent à la grande majorité des individus.

Le benchmark Humanity’s Last Exam constitue un autre terrain d’affrontement redoutable. Ce test, conçu pour mesurer les connaissances académiques les plus pointues, a vu Deep Think atteindre un score de 48,4 % sans recours à des outils externes, contre 41 % pour la version précédente. Cette amélioration de plus de 7 points peut sembler modeste en valeur absolue, mais elle représente un bond qualitatif majeur dans des domaines où chaque pourcentage additionnel demande des efforts exponentiels. Claude Opus 4.1, le premier modèle généraliste d’Anthropic, plafonne à 40 %, ce qui souligne la distance que Google a réussi à installer en si peu de temps.

Les Olympiades internationales de Mathématiques fournissent un autre indicateur spectaculaire. Avec un taux de réussite de 81,5 %, équivalent à une médaille d’or, le modèle démontre une capacité à traiter des problèmes géométriques et algébriques d’une difficulté exceptionnelle. Ces épreuves, traditionnellement réservées aux lycéens les plus brillants du monde entier, nécessitent une combinaison de créativité, de rigueur formelle et d’intuition mathématique que l’on croyait hors de portée des machines. Pourtant, Google Gemini 3 Deep Think déjoue ces pronostics en affichant une régularité impressionnante dans la résolution de ces défis.

La domination sur Codeforces : un exploit technique sans précédent

Le score Elo de 3455 points obtenu sur Codeforces constitue probablement l’une des prouesses les plus remarquables de cette mise à jour. Cette plateforme de programmation compétitive rassemble des développeurs chevronnés qui s’affrontent sur des problèmes algorithmiques complexes, souvent issus de recherches en informatique théorique. Avec ce classement, Deep Think se hisse dans le top 0,01 % des programmeurs mondiaux, un territoire jusqu’ici réservé à une poignée d’ingénieurs d’élite. L’écart avec Claude Opus 4.6, qui stagne à 2352 points, est abyssal et témoigne d’un surpassement technique difficilement contestable.

Cette performance ne se limite pas à la rapidité d’exécution ou à la mémorisation de patterns classiques. Le modèle fait preuve d’une capacité à optimiser des algorithmes, à détecter des cas limites subtils et à produire du code efficace dans des contraintes de temps et de ressources extrêmement serrées. Des développeurs expérimentés ont analysé les solutions générées et ont constaté que le style de programmation de Deep Think intègre des techniques avancées comme la programmation dynamique, les structures de données complexes ou encore les optimisations mathématiques de pointe. Cette maîtrise technique, combinée à une logique de raisonnement quasi-humaine, redéfinit les standards de ce qu’une IA peut accomplir dans le domaine du développement logiciel.

| Benchmark | Gemini 3 Deep Think (Déc. 2025) | Claude Opus 4.6 (Fév. 2026) | Gemini 3 Deep Think (Fév. 2026) |

|---|---|---|---|

| ARC-AGI-2 (Raisonnement visuel) | 45,1 % | 68,8 % | 84,6 % |

| Humanity’s Last Exam | 41,0 % | 40,0 % | 48,4 % |

| Olympiades mathématiques 2025 | 60,7 % | — | 81,5 % |

| Codeforces (Programmation compétitive) | — | 2352 Elo | 3455 Elo |

| MMMU-Pro (Multimodal) | — | 73,9 % | 81,5 % |

Un modèle de niche aux ambitions universelles

Contrairement à Claude Opus 4.6, qui vise un large public incluant des utilisateurs occasionnels, Google Gemini 3 Deep Think se positionne résolument comme un outil spécialisé. Google l’assume pleinement : ce modèle n’a pas vocation à rédiger des emails ou à structurer des notes de réunion. Son terrain de jeu, ce sont les laboratoires de recherche fondamentale, les départements d’ingénierie aéronautique ou les équipes de mathématiciens travaillant sur des conjectures complexes. Cette stratégie de ciblage restreint peut surprendre, mais elle reflète une réalité économique et technique : faire tourner un tel système demande des ressources computationnelles considérables et un temps de latence incompatible avec des usages grand public.

L’abonnement Google AI Ultra, facturé 275 euros par mois, constitue une barrière d’entrée non négligeable. Ce tarif premium sélectionne de facto une clientèle professionnelle disposant de budgets conséquents et de cas d’usage justifiant cet investissement. Les retours des premiers utilisateurs confirment cette orientation : des ingénieurs en aérospatiale ont par exemple utilisé Deep Think pour optimiser des simulations de flux turbulents, une tâche qui nécessite des calculs différentiels complexes et une compréhension fine des lois physiques. De leur côté, des chercheurs en cryptographie ont testé le modèle sur des problèmes de factorisation et de preuves formelles, domaines où l’erreur n’est pas permise et où la rigueur mathématique prime.

La latence comme contrepartie de la puissance

L’une des particularités de Deep Think réside dans son temps de réponse volontairement allongé. Contrairement aux modèles conversationnels standards qui privilégient la réactivité immédiate, ce système prend le temps d’explorer différentes branches de raisonnement avant de proposer une solution. Cette latence, qui peut atteindre plusieurs dizaines de secondes pour les problèmes les plus ardus, devient un atout plutôt qu’un défaut dans le contexte scientifique. Un chercheur travaillant sur une démonstration mathématique préfère attendre une minute pour obtenir une réponse fiable plutôt que de recevoir instantanément une approximation hasardeuse.

Cette approche illustre un basculement philosophique dans la conception des IA : la vitesse brute n’est plus l’unique critère de performance. La profondeur de réflexion, la robustesse des conclusions et la capacité à éviter les hallucinations deviennent des priorités équivalentes, voire supérieures. Google a ainsi développé des mécanismes de vérification interne qui permettent au modèle de rejeter ses propres hypothèses lorsqu’il détecte des incohérences, un processus qui rallonge le traitement mais améliore drastiquement la fiabilité. Ce compromis trouve particulièrement son sens dans des secteurs comme l’aéronautique ou la médecine, où une erreur de calcul peut avoir des conséquences catastrophiques.

La révolution invisible : l’optimisation des coûts de calcul

Au-delà des benchmarks spectaculaires, l’innovation la plus disruptive de cette mise à jour se situe probablement dans l’optimisation économique du modèle. Google a réussi l’exploit technique de doubler la précision de son système tout en divisant les coûts d’exploitation par cinq. Concrètement, une requête complexe sur le benchmark ARC-AGI, qui nécessitait environ 77 dollars de puissance de calcul avec l’ancienne version, ne coûte désormais que 13,62 dollars avec la nouvelle mouture. Cette compression des dépenses représente un tournant stratégique majeur pour la démocratisation future de l’intelligence artificielle avancée.

Comment Google a-t-il accompli cette prouesse ? Plusieurs pistes techniques se dessinent. D’abord, l’amélioration de l’efficacité énergétique des puces TPU (Tensor Processing Units) développées en interne par l’entreprise. Ces processeurs spécialisés, optimisés spécifiquement pour les opérations d’apprentissage profond, affichent désormais un ratio performance-watt largement supérieur à celui des générations précédentes. Ensuite, des innovations algorithmiques comme la quantification adaptative permettent de réduire la précision numérique des calculs dans certaines phases du traitement sans dégrader la qualité finale des résultats.

- Réduction de 82 % des coûts de traitement sur les tâches complexes du benchmark ARC-AGI

- Utilisation de TPU de cinquième génération offrant un rendement énergétique accru de 40 %

- Implémentation de techniques de pruning dynamique éliminant les neurones redondants en temps réel

- Parallélisation massive des calculs sur des clusters distribués à l’échelle mondiale

- Optimisation de la mémoire cache réduisant les accès disque de 60 %

L’impact à long terme sur l’accessibilité de l’IA

Cette chute drastique des coûts opérationnels ouvre des perspectives fascinantes pour l’intégration future de ces capacités dans des produits grand public. Imaginez un assistant personnel capable de résoudre des problèmes d’ingénierie ou de physique avancée, accessible pour quelques euros par mois au lieu de plusieurs centaines. Cette trajectoire de baisse des prix suit une logique similaire à celle observée dans l’histoire de l’informatique, où des technologies initialement réservées aux centres de recherche finissent par se retrouver dans chaque foyer. Si Google parvient à maintenir cette dynamique d’optimisation, on peut anticiper que les versions futures de Gemini intégreront progressivement ces fonctionnalités avancées dans des abonnements plus abordables.

Les implications pour le secteur éducatif sont particulièrement prometteuses. Des universités pourraient offrir à leurs étudiants en physique ou en mathématiques un accès à un tuteur IA capable de les accompagner dans la résolution de problèmes de niveau olympiade. Des startups spécialisées dans la simulation numérique pourraient exploiter ces outils pour réduire leurs coûts de R&D. Cette démocratisation progressive pourrait accélérer l’innovation dans de nombreux domaines scientifiques en abaissant les barrières d’entrée liées aux ressources computationnelles. Consultez par exemple comment Google a structuré son approche avec Gemini 2.5 Pro pour comprendre l’évolution de cette stratégie.

Les défis techniques et éthiques du dépassement des capacités humaines

Atteindre puis dépasser les limites humaines dans des domaines aussi pointus que les mathématiques olympiques ou la programmation compétitive soulève des questions fondamentales. Quelle est la nature de cette intelligence que nous développons ? Reproduit-elle les mécanismes cognitifs humains ou emprunte-t-elle des chemins radicalement différents pour parvenir aux mêmes résultats ? Les chercheurs en sciences cognitives observent avec attention les stratégies employées par Deep Think et constatent que, si le résultat final est souvent identique à celui d’un expert humain, le cheminement peut différer substantiellement.

Par exemple, face à un problème géométrique complexe, un mathématicien humain mobilise son intuition visuelle, dessine des schémas mentaux et procède par analogies avec des situations similaires rencontrées antérieurement. Google Gemini 3 Deep Think, de son côté, explore systématiquement un espace de solutions en évaluant des milliers de configurations possibles en quelques secondes, un processus plus proche de la force brute intelligemment guidée que de l’éclair de génie créatif. Cette divergence méthodologique n’enlève rien à la performance, mais elle interroge sur la transférabilité de ces compétences à des contextes inédits ou ambigus, là où l’intuition humaine excelle encore.

Les risques d’une dépendance excessive aux systèmes experts

L’avènement de modèles surpassant les capacités humaines dans des domaines intellectuels de haut niveau comporte des risques qu’il serait irresponsable d’ignorer. Le premier danger réside dans l’atrophie potentielle des compétences humaines. Si les ingénieurs et chercheurs délèguent systématiquement la résolution de problèmes complexes à une IA, ne risquent-ils pas de perdre progressivement leur capacité à raisonner de manière autonome sur ces questions ? L’histoire de la technologie offre des précédents inquiétants : l’arrivée des calculatrices a entraîné une baisse générale du niveau en calcul mental, sans pour autant améliorer significativement la compréhension conceptuelle des mathématiques.

Le second enjeu concerne la validation des résultats. Lorsqu’un système IA propose une solution à un problème dont aucun humain ne peut vérifier la justesse en temps raisonnable, comment s’assurer de sa fiabilité ? Les mécanismes actuels de preuve formelle et de vérification automatique offrent des garde-fous, mais ils ne couvrent pas tous les cas d’usage. Un ingénieur en aéronautique qui utiliserait Deep Think pour optimiser une aile d’avion devrait-il accepter aveuglément les paramètres suggérés par la machine, ou maintenir une posture critique en recalculant manuellement certaines étapes clés ? Cette tension entre efficacité et prudence traversera probablement les prochaines décennies du développement technologique.

Perspectives d’évolution et concurrence pour 2026

Les rumeurs de marché évoquent déjà l’arrivée de Gemini 3.1 Pro et Gemini 3.5 Pro pour le premier semestre. Ces versions intermédiaires pourraient démocratiser certaines fonctionnalités de Deep Think en les intégrant à des tarifs plus accessibles et avec des temps de latence réduits. Google semble vouloir adopter une stratégie en entonnoir : proposer d’abord des capacités de pointe dans une version ultra-premium, puis les diffuser progressivement vers le grand public une fois l’optimisation technique suffisamment avancée. Cette approche permet de rentabiliser rapidement les investissements massifs en R&D tout en préparant le terrain pour une adoption massive.

Du côté de la concurrence, Anthropic ne reste pas les bras croisés. L’entreprise a annoncé travailler sur Claude Opus 4.7, prévu pour la mi-2026, avec des promesses d’amélioration substantielle sur les benchmarks de raisonnement logique. OpenAI, de son côté, prépare une refonte architecturale de GPT-6, dont les premières versions beta circulent déjà dans certains cercles de développeurs privilégiés. La course à l’armement dans le domaine de l’intelligence artificielle s’intensifie, chaque acteur cherchant à décrocher un avantage compétitif durable. Cette dynamique de compétition féroce bénéficie ultimement aux utilisateurs finaux, qui voient les performances grimper et les prix baisser à un rythme soutenu.

Intégration dans les écosystèmes professionnels existants

L’adoption de Google Gemini 3 Deep Think dans les environnements de travail réels nécessite bien plus qu’une simple API performante. Les entreprises exigent des intégrations fluides avec leurs outils existants, des garanties de confidentialité des données et des interfaces adaptées aux workflows spécifiques de chaque secteur. Google a développé un programme partenaire permettant aux éditeurs de logiciels scientifiques d’intégrer Deep Think directement dans leurs plateformes. Des acteurs comme MATLAB ou Wolfram Alpha explorent déjà des collaborations pour enrichir leurs fonctionnalités de résolution symbolique avec les capacités du modèle.

Cette stratégie d’écosystème rappelle celle menée avec succès dans le cloud computing, où Google Cloud Platform s’est imposé en partie grâce à ses services d’IA préintégrés. En facilitant l’accès à Deep Think via des SDK bien documentés et des exemples d’utilisation sectoriels, l’entreprise espère créer un effet réseau : plus il y aura d’applications tierces exploitant le modèle, plus sa valeur augmentera pour l’ensemble des utilisateurs. Des startups se lancent d’ailleurs dans le développement de verticales spécialisées, comme un assistant pour l’analyse de données génomiques ou un optimiseur de portefeuille financier basé sur des modèles mathématiques avancés. L’approche modulaire adoptée par certains modèles de structuration de projets pourrait inspirer de nouveaux usages pour ces technologies.

Applications concrètes dans la recherche fondamentale

Les laboratoires de physique des particules figurent parmi les premiers bénéficiaires de cette technologie avancée. Le CERN, par exemple, teste actuellement Deep Think pour analyser les données massives produites par le Grand Collisionneur de Hadrons. Chaque collision génère des téraoctets d’informations que les physiciens doivent filtrer pour identifier les événements rares susceptibles de révéler de nouvelles particules. Le modèle excelle dans la détection de patterns subtils noyés dans le bruit statistique, une tâche qui mobilisait jusqu’ici des équipes entières de doctorants pendant des mois.

En mathématiques pures, des chercheurs exploitent le système pour explorer des conjectures non résolues. La conjecture de Birch et Swinnerton-Dyer, l’un des sept problèmes du millénaire, a fait l’objet de tentatives de démonstration assistée par Deep Think. Si aucune preuve complète n’a encore émergé, le modèle a généré des pistes prometteuses en identifiant des cas particuliers que les mathématiciens peuvent ensuite étudier manuellement. Cette collaboration homme-machine ouvre un nouveau paradigme de recherche où l’intuition humaine guide l’exploration tandis que la puissance de calcul de l’IA teste exhaustivement les hypothèses.

Impact sur l’ingénierie et la conception industrielle

Dans le secteur aéronautique, des ingénieurs utilisent Google Gemini 3 Deep Think pour optimiser les profils aérodynamiques. La conception d’une aile d’avion implique des milliers de variables interdépendantes : angle d’attaque, distribution de la portance, résistance aux turbulences, poids structurel, coût de fabrication, etc. Les méthodes traditionnelles d’optimisation multivariable butent rapidement sur la malédiction de la dimensionnalité. Le modèle, grâce à sa capacité à explorer efficacement des espaces de solution complexes, propose des configurations inédites qui réduisent la consommation de carburant de 3 à 5 % par rapport aux designs conventionnels.

Le domaine de la science des matériaux bénéficie également de ces avancées. La recherche de nouveaux alliages métalliques ou de polymères aux propriétés spécifiques représente un processus long et coûteux, nécessitant des essais physiques en laboratoire. Deep Think accélère cette phase exploratoire en simulant le comportement de millions de combinaisons moléculaires, prédisant leurs propriétés mécaniques, thermiques et chimiques. Des matériaux prometteurs peuvent ensuite être synthétisés en priorité, réduisant drastiquement le cycle de développement. Une startup californienne affirme avoir divisé par dix le temps nécessaire pour identifier un nouveau superalliage pour turbines grâce à cette approche hybride.

Quelle est la différence principale entre Gemini 3 Deep Think et les modèles grand public comme Claude ou GPT ?

Gemini 3 Deep Think se spécialise dans la résolution de problèmes scientifiques et mathématiques complexes en explorant plusieurs chaînes de raisonnement simultanément, avec une latence plus élevée mais une précision accrue. Les modèles grand public privilégient la rapidité de réponse et la polyvalence pour des tâches quotidiennes comme la rédaction ou l’assistance générale.

Pourquoi le tarif de 275 euros par mois pour accéder à Deep Think ?

Ce prix reflète les coûts computationnels élevés liés aux capacités avancées du modèle, qui mobilise des ressources serveur considérables pour chaque requête. Il cible des professionnels et organisations dont les cas d’usage justifient cet investissement, notamment dans la recherche scientifique ou l’ingénierie de pointe.

Comment Google a-t-il réduit les coûts de calcul de 77 à 13,62 dollars par requête complexe ?

Cette optimisation résulte d’une combinaison d’innovations techniques : amélioration de l’efficacité énergétique des puces TPU, techniques de quantification adaptative, pruning dynamique des neurones redondants et parallélisation massive des calculs sur des infrastructures distribuées.

Les performances de Deep Think signifient-elles que l’IA a dépassé l’intelligence humaine ?

Dans des domaines spécifiques comme les mathématiques olympiques ou la programmation compétitive, Deep Think atteint effectivement le niveau des meilleurs experts humains. Cependant, cette performance reste circonscrite à des tâches bien définies et ne reflète pas une intelligence générale comparable à celle d’un être humain, qui excelle dans l’adaptation à des contextes nouveaux et ambigus.

Quand les capacités de Deep Think seront-elles accessibles au grand public ?

Les rumeurs évoquent l’arrivée de versions intermédiaires comme Gemini 3.1 Pro ou 3.5 Pro pour le premier semestre, qui pourraient intégrer progressivement certaines fonctionnalités avancées à des tarifs plus abordables. La stratégie de Google consiste à démocratiser ces technologies une fois l’optimisation technique suffisamment mature pour réduire les coûts opérationnels.