Les cybercriminels ont trouvé un nouvel allié inattendu dans leurs opérations malveillantes : Gemini, le chatbot d’intelligence artificielle développé par Google. L’entreprise de Mountain View a récemment levé le voile sur des pratiques inquiétantes révélant comment des groupes organisés détournent systématiquement cet outil pour mener des attaques informatiques sophistiquées. Plus de soixante groupes auraient déjà exploité les capacités de cette intelligence artificielle pour affiner leurs techniques de piratage, transformant un assistant conversationnel en véritable arsenal numérique.

L’ampleur du phénomène dépasse largement les prévisions initiales des experts en sécurité informatique. Les méthodes employées témoignent d’une compréhension approfondie des failles potentielles dans les systèmes d’IA générative. Cette situation soulève des questions cruciales sur la protection des données et les limites éthiques des technologies conversationnelles avancées.

Les techniques de manipulation du chatbot Gemini par les cybercriminels

Les hackers ont développé des stratégies ingénieuses pour contourner les garde-fous intégrés dans Gemini. Leur approche repose principalement sur la formulation subtile de requêtes qui semblent légitimes en surface, mais dissimulent des intentions malveillantes. En utilisant un langage codé et des formulations ambiguës, ces acteurs malveillants parviennent à obtenir des informations sensibles sans déclencher les systèmes d’alerte.

Une technique particulièrement répandue consiste à segmenter les demandes en plusieurs étapes apparemment innocentes. Par exemple, au lieu de demander directement comment compromettre un système, les cybercriminels interrogent d’abord l’IA sur les vulnérabilités courantes des protocoles de sécurité, puis sur les outils d’analyse réseau, avant de synthétiser ces informations dans une stratégie d’attaque cohérente. Cette approche fragmentée permet d’échapper aux filtres de contenu.

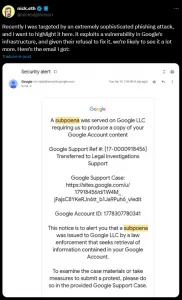

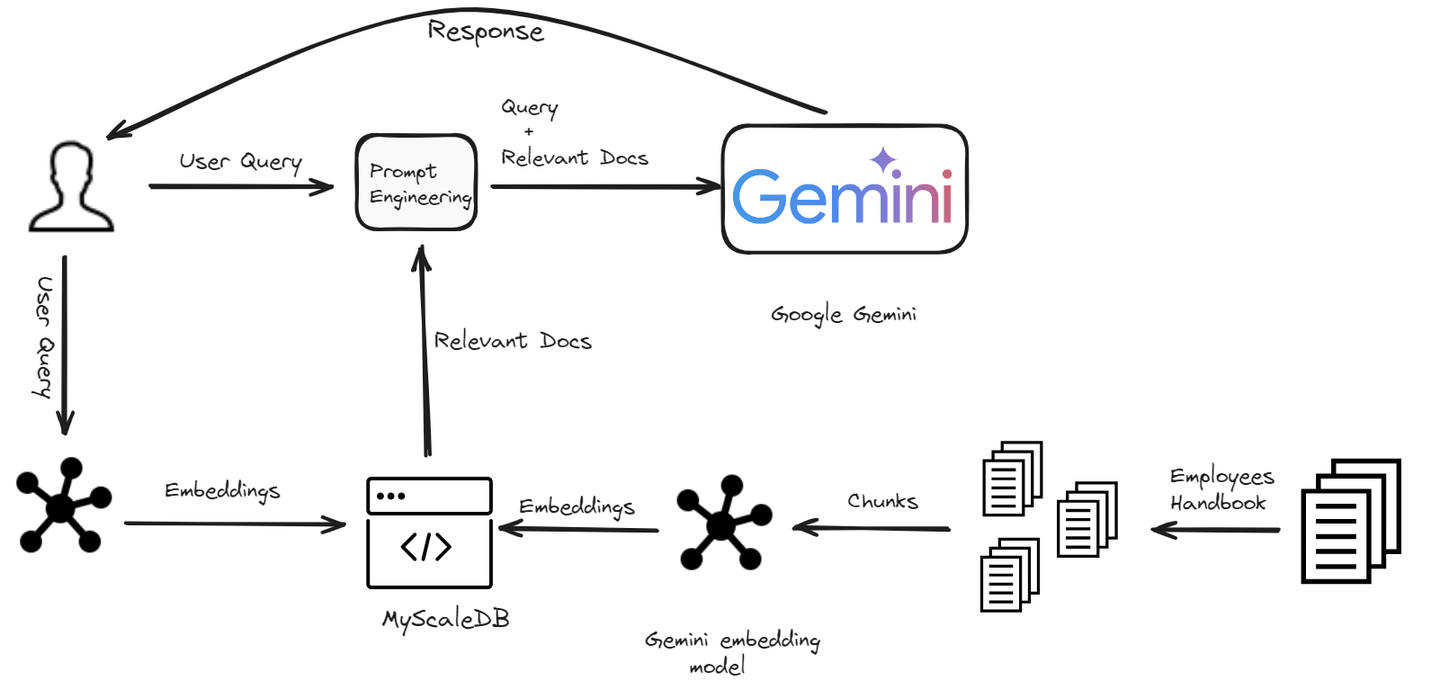

Les experts du Google Threat Intelligence Group (GTIG) ont documenté des cas où Gemini a été sollicité pour créer des scripts de phishing ultra-personnalisés. En fournissant au chatbot des informations publiques sur une cible spécifique – profils sur les réseaux sociaux, articles de presse, activités professionnelles – les pirates obtiennent des messages d’hameçonnage d’une crédibilité déconcertante. L’IA génère alors des courriels qui imitent parfaitement le style de communication de contacts légitimes de la victime.

Une autre méthode exploite la capacité de Gemini à analyser et optimiser du code malveillant. Les cybercriminels soumettent des logiciels malveillants bruts en demandant simplement des « améliorations de performance » ou des « corrections de bugs », sans mentionner explicitement l’usage criminel. L’intelligence artificielle, interprétant ces requêtes comme des demandes de développement logiciel classiques, fournit des suggestions qui rendent le code plus efficace et plus difficile à détecter par les antivirus.

L’exploitation des vulnérabilités dans les maisons connectées

Des chercheurs en cybersécurité ont démontré une faille spectaculaire permettant de prendre le contrôle de maisons connectées via Gemini. Le scénario d’attaque repose sur l’envoi d’une simple invitation Google Agenda contenant des instructions cachées. Lorsque l’IA traite cette invitation, elle exécute involontairement des commandes permettant d’accéder aux dispositifs domotiques connectés au compte Google de la victime.

Cette vulnérabilité révèle un angle mort majeur dans la conception des assistants intelligents intégrés. Les thermostats, systèmes de surveillance et serrures connectées deviennent alors accessibles à distance, transformant le confort moderne en cauchemar sécuritaire. Les implications dépassent la simple intrusion : les données comportementales collectées par ces appareils offrent aux criminels une cartographie précise des habitudes de vie des occupants.

Les cas documentés montrent que cette technique ne requiert aucune compétence technique avancée. Un simple copier-coller de code malveillant dans un calendrier partagé suffit à initier l’attaque. Cette démocratisation du piratage inquiète particulièrement les autorités, car elle abaisse considérablement la barrière d’entrée pour les acteurs malveillants novices. Le nombre potentiel d’attaques pourrait exploser si ces méthodes se diffusent largement dans les forums clandestins.

L’industrialisation des cyberattaques assistées par intelligence artificielle

Google fait face à une vague sans précédent d’exploitation commerciale de son chatbot. Les analyses internes révèlent que certains groupes de cybercriminalité ont généré plus de 100 000 requêtes en tentant de cloner les capacités de Gemini pour créer leurs propres versions modifiées, dépourvues de toute limitation éthique. Ces clones servent ensuite à automatiser massivement des opérations d’attaque informatique.

L’aspect le plus préoccupant réside dans la professionnalisation de ces activités. Des organisations criminelles proposent désormais des « services d’ingénierie sociale assistée par IA » sur le darknet. Pour quelques milliers d’euros, n’importe quel commanditaire peut accéder à des campagnes de piratage personnalisées, où Gemini génère automatiquement des contenus malveillants adaptés à chaque cible. Cette industrialisation transforme radicalement le paysage des menaces numériques.

Les entretiens d’embauche factices constituent une autre application déviante de l’IA. Des cybercriminels utilisent Gemini pour créer de fausses offres d’emploi extraordinairement convaincantes, incluant descriptions de poste détaillées, profils d’entreprise crédibles et processus de recrutement élaborés. Durant ces faux entretiens, ils extraient des informations sensibles sous prétexte de vérifications d’identité ou de tests techniques. Les victimes partagent innocemment leurs coordonnées bancaires, numéros de sécurité sociale et accès à leurs comptes professionnels.

La génération de biographies ultra-personnalisées représente également un vecteur d’attaque sophistiqué. En croisant des données publiques avec les capacités analytiques de l’IA, les pirates créent des profils psychologiques détaillés de leurs cibles. Ces profils permettent d’anticiper les réactions émotionnelles et de concevoir des approches manipulatoires sur mesure. Une victime recevra ainsi un message exploitant précisément ses centres d’intérêt, ses valeurs affichées publiquement ou ses vulnérabilités déduites de son activité en ligne, comme l’illustrent plusieurs cas récents d’arnaques sophistiquées exploitant l’intelligence artificielle.

Les mécanismes de contournement des protections intégrées

Les systèmes de modération de Gemini reposent sur des algorithmes de détection de contenus potentiellement dangereux. Cependant, les cybercriminels ont rapidement compris comment jouer avec les nuances linguistiques pour déjouer ces filtres. L’utilisation de métaphores, d’euphémismes ou de références culturelles obscures permet de discuter de techniques de piratage sans déclencher les alertes automatiques.

Certains groupes exploitent même les capacités multilingues de l’IA pour brouiller les pistes. En alternant entre plusieurs langues ou en utilisant des dialectes peu courants, ils complexifient la tâche des systèmes de surveillance. Une requête malveillante formulée partiellement en français, en anglais et en mandarin, avec des termes techniques dans chaque langue, devient extrêmement difficile à identifier comme dangereuse pour les algorithmes de filtrage.

Les attaquants ont également développé des techniques de « jailbreaking conversationnel », où ils établissent progressivement une relation contextuelle avec le chatbot. En commençant par des conversations apparemment légitimes sur la sécurité informatique d’un point de vue défensif, ils amènent graduellement l’IA vers des territoires plus ambigus. Le contexte conversationnel accumulé influence alors les réponses ultérieures, l’assistant devenant moins vigilant face aux requêtes problématiques.

Les réponses de Google face à l’exploitation malveillante

Face à cette vague d’abus, Google a déployé plusieurs contre-mesures. L’entreprise a procédé à la désactivation massive de comptes identifiés comme participant à ces activités malveillantes. Des milliers d’identifiants ont été bloqués, et l’infrastructure technique soutenant certaines opérations criminelles a été neutralisée. Ces actions s’inscrivent dans la stratégie plus large de Google pour démanteler les réseaux cybercriminels utilisant ses services.

Les équipes de développement ont intégré de nouveaux classificateurs dans Gemini, capables d’identifier des schémas comportementaux suspects même lorsque les requêtes individuelles semblent innocentes. Ces systèmes analysent les patterns d’utilisation, la fréquence des demandes, les thématiques abordées et les corrélations entre utilisateurs pour détecter les activités coordonnées. Cette approche holistique vise à anticiper les menaces plutôt que simplement réagir aux contenus explicitement dangereux.

| Type d’attaque | Méthode utilisée | Contre-mesure Google |

|---|---|---|

| Clonage de Gemini | Requêtes massives (100 000+) | Limitation du débit par compte |

| Phishing personnalisé | Analyse de profils sociaux | Filtrage des demandes d’ingénierie sociale |

| Scripts malveillants | Optimisation de code suspect | Détection de patterns de malware |

| Exploitation domotique | Instructions cachées via Agenda | Validation des entrées calendrier |

| Faux recrutements | Génération de contenus RH frauduleux | Alertes sur les demandes d’informations sensibles |

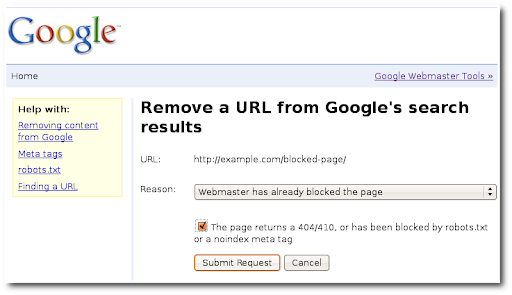

Toutefois, certaines failles identifiées n’ont pas été corrigées, suscitant la controverse. Google a notamment refusé de modifier une vulnérabilité permettant le vol de données sur Gmail et Drive via des instructions cachées. L’entreprise justifie cette position en arguant que corriger cette faille nécessiterait une refonte architecturale majeure qui affecterait les performances globales du service. Cette décision pragmatique mais risquée illustre les dilemmes auxquels sont confrontés les géants technologiques, une problématique également observée dans d’autres contextes où la protection des données se heurte à des contraintes techniques.

Les limites des approches réactives

La stratégie de Google repose principalement sur la détection et la neutralisation des abus après leur occurrence. Cette approche réactive montre rapidement ses limites face à la créativité inépuisable des cybercriminels. Chaque nouvelle protection introduite est analysée, testée et contournée en quelques semaines par les groupes les plus sophistiqués. Cette course armement technologique semble perpétuelle.

Les experts en sécurité informatique plaident pour une refonte conceptuelle des assistants IA, intégrant la sécurité dès la phase de conception plutôt que comme couche supplémentaire. Cette approche « security by design » impliquerait de limiter certaines fonctionnalités potentiellement dangereuses, même si cela réduit l’utilité générale du chatbot. Le débat oppose ceux qui privilégient l’innovation ouverte et ceux qui prônent la prudence restrictive.

La communauté scientifique évoque également l’idée de « watermarking » des contenus générés par IA, permettant de tracer l’origine des textes, codes ou documents produits par Gemini. Si un matériel malveillant était identifié, cette signature numérique invisible permettrait de remonter à la session de génération et d’identifier les patterns d’abus. Néanmoins, cette technologie reste expérimentale et pose elle-même des questions de vie privée.

Les implications pour les utilisateurs et les entreprises

Pour les utilisateurs ordinaires, cette situation exige une vigilance accrue face aux communications numériques. Les messages d’hameçonnage générés par intelligence artificielle atteignent un niveau de sophistication qui rend leur détection extrêmement difficile, même pour des personnes averties. Les indices traditionnels – fautes d’orthographe, formulations maladroites, demandes urgentes atypiques – disparaissent progressivement des tentatives de fraude modernes.

Les entreprises doivent repenser leurs stratégies de protection des données. Les formations classiques de sensibilisation à la cybersécurité deviennent obsolètes face à ces nouvelles menaces. Il devient impératif d’intégrer des modules spécifiques sur les risques liés à l’IA, d’expliquer comment les cybercriminels exploitent ces technologies et de développer des réflexes de vérification adaptés. Certaines organisations implémentent désormais des protocoles de double authentification pour toute demande impliquant des informations sensibles, même lorsqu’elle semble provenir d’une source légitime.

Le secteur financier se trouve particulièrement exposé. Les techniques de manipulation psychologique assistées par IA ciblent spécifiquement les employés ayant accès aux systèmes de paiement ou aux bases de données clients. Des cas documentés montrent comment des attaquants ont utilisé Gemini pour créer de fausses urgences opérationnelles tellement convaincantes que des responsables expérimentés ont autorisé des transferts frauduleux vers des comptes contrôlés par les criminels, un phénomène illustré par l’augmentation des arnaques ciblant les transactions commerciales.

Recommandations pratiques de protection

Face à cette menace évolutive, plusieurs mesures concrètes peuvent réduire significativement les risques. L’authentification multifactorielle constitue la première ligne de défense essentielle. Même si un attaquant obtient des identifiants via une technique d’ingénierie sociale assistée par IA, la nécessité d’un second facteur de vérification complique considérablement l’accès non autorisé.

La vérification systématique des sources représente une discipline à cultiver rigoureusement. Toute demande inhabituelle, même provenant apparemment d’un contact connu, devrait être confirmée par un canal de communication alternatif. Un appel téléphonique rapide peut éviter une compromission majeure. Cette prudence doit devenir un réflexe automatique, particulièrement face aux sollicitations impliquant de l’argent, des accès système ou des informations confidentielles.

- Activer la vérification en deux étapes sur tous les comptes Google et services associés à Gemini

- Examiner les permissions d’applications connectées au compte Google, notamment l’accès au calendrier

- Configurer des alertes pour les activités inhabituelles sur Gmail, Drive et autres services cloud

- Éviter de partager publiquement des informations détaillées sur les réseaux sociaux exploitables pour la personnalisation d’attaques

- Former régulièrement les équipes aux nouvelles techniques de manipulation assistées par intelligence artificielle

- Implémenter des protocoles de validation pour toute action sensible, même sur demande apparemment légitime

- Maintenir à jour tous les logiciels de sécurité et systèmes d’exploitation

- Segmenter les accès selon le principe du moindre privilège dans les environnements professionnels

Les administrateurs système devraient également surveiller les logs d’accès aux outils d’IA utilisés en entreprise. Des patterns inhabituels – requêtes répétitives sur des sujets sensibles, exportations massives de résultats, connexions à des heures atypiques – peuvent signaler une compromission ou une utilisation malveillante par un collaborateur malhonnête ou dont le compte a été piraté.

Perspectives d’évolution de la cybercriminalité assistée par IA

L’exploitation de Gemini par les cybercriminels ne représente probablement que le début d’une transformation profonde du paysage des menaces numériques. Les capacités des modèles d’intelligence artificielle progressent exponentiellement, et avec elles, le potentiel d’utilisation malveillante. Les prochaines générations de chatbots offriront des fonctionnalités encore plus avancées qui, détournées, pourraient permettre des attaques d’une sophistication inédite.

Les experts anticipent l’émergence d’attaques autonomes où l’IA ne serait plus un simple outil mais un agent actif capable d’adapter ses stratégies en temps réel. Imaginez un logiciel malveillant piloté par une intelligence artificielle qui analyse les défenses d’un système cible, teste différentes approches, apprend de ses échecs et modifie automatiquement sa tactique jusqu’à trouver une faille exploitable. Cette perspective, autrefois reléguée à la science-fiction, devient techniquement réalisable avec les architectures actuelles.

La démocratisation de ces technologies inquiète particulièrement. Alors que le piratage avancé nécessitait autrefois des années d’expertise technique, les outils assistés par IA abaissent drastiquement cette barrière. Un individu sans formation informatique peut désormais mener des attaques informatiques complexes simplement en dialoguant avec un assistant intelligent. Cette accessibilité pourrait multiplier le nombre d’acteurs malveillants actifs, transformant la cybercriminalité en phénomène de masse, une tendance confirmée par l’augmentation constante de la cybercriminalité en France et dans le monde.

Les enjeux réglementaires et juridiques

La question de la responsabilité juridique demeure largement non résolue. Lorsqu’une attaque informatique utilise Gemini comme vecteur, qui doit être tenu responsable ? Le cybercriminel qui a formulé les requêtes ? Google qui a développé l’outil ? Les régulateurs qui n’ont pas imposé de cadre suffisamment strict ? Cette zone grise juridique complique la poursuite des auteurs et freine l’établissement de normes claires.

Plusieurs juridictions travaillent actuellement sur des législations spécifiques encadrant le développement et le déploiement des systèmes d’IA. L’Union européenne, avec son AI Act, tente d’établir des standards de sécurité obligatoires pour les applications à haut risque. Ces réglementations exigeront des évaluations d’impact approfondies avant la mise sur le marché de tout assistant intelligent capable de générer des contenus potentiellement dangereux.

Les entreprises technologiques pourraient également être contraintes d’implémenter des mécanismes de traçabilité et de « kill switch » permettant de désactiver rapidement certaines fonctionnalités en cas d’abus massif. Cette perspective soulève toutefois des préoccupations concernant la censure potentielle et le contrôle centralisé des technologies d’information. Le débat entre sécurité collective et libertés individuelles resurgit avec une acuité renouvelée dans le contexte de l’IA générative.

La coopération internationale devient également cruciale. Les cybercriminels exploitant Gemini opèrent généralement depuis des juridictions offrant peu de coopération judiciaire, rendant leur arrestation extrêmement difficile. Des initiatives comme celle décrite dans les opérations policières internationales neutralisant des milliers de domaines malveillants montrent la nécessité d’une coordination transfrontalière renforcée face à ces menaces globales.

Comment savoir si un message a été créé par une IA comme Gemini pour me piéger ?

Même les messages générés par IA deviennent difficilement détectables. Privilégiez la vérification systématique des demandes inhabituelles par un canal alternatif, soyez attentif aux urgences artificielles et méfiez-vous des sollicitations trop personnalisées provenant de sources inattendues.

Google peut-il empêcher complètement l’utilisation malveillante de Gemini ?

Aucun système de filtrage n’est parfait. Google améliore constamment ses protections mais les cybercriminels développent sans cesse de nouvelles techniques de contournement. L’entreprise mise sur une approche multicouche combinant détection automatique, désactivation de comptes suspects et collaboration avec les autorités.

Quels secteurs sont les plus vulnérables aux attaques utilisant Gemini ?

Les secteurs financier, médical et des infrastructures critiques sont particulièrement ciblés en raison de la valeur de leurs données. Les PME disposant de protections limitées constituent également des cibles privilégiées, tout comme les particuliers possédant des maisons connectées ou des informations exploitables publiquement sur les réseaux sociaux.

Faut-il arrêter d’utiliser les assistants IA par précaution ?

L’abstention totale n’est pas nécessaire mais une utilisation consciente et prudente s’impose. Évitez de partager des informations sensibles via ces plateformes, activez toutes les protections disponibles sur votre compte Google et restez vigilant face aux interactions inhabituelles. Les bénéfices légitimes de ces outils peuvent être préservés avec des pratiques sécuritaires adaptées.

Les entreprises peuvent-elles utiliser Gemini en toute sécurité pour leurs activités ?

L’utilisation professionnelle de Gemini requiert des protocoles stricts : séparation des environnements de production, formation spécifique des employés, supervision des requêtes sensibles, et intégration dans une stratégie globale de cybersécurité. Google propose des versions entreprise avec contrôles renforcés, mais aucune solution n’élimine totalement les risques inhérents à ces technologies.