Le géant de Mountain View vient de franchir une nouvelle étape dans sa bataille contre le scraping massif de ses données. En déposant une plainte fédérale contre SerpApi, une société texane spécialisée dans l’extraction automatisée de résultats de recherche, Google entend protéger ses investissements technologiques et les contenus protégés par le droit d’auteur qui transitent par sa plateforme. Cette offensive juridique révèle les tensions croissantes entre les géants du numérique et les entreprises qui exploitent leurs données à des fins commerciales, dans un contexte où l’intelligence artificielle décuple les besoins en information structurée.

Les fondements juridiques de l’action en justice engagée par Google

La plainte déposée par Google contre SerpApi repose sur plusieurs piliers juridiques solides. Le Copyright Act américain constitue le principal fondement de cette action, notamment la section 1201 qui interdit le contournement des mesures techniques de protection. Google affirme que SerpApi aurait délibérément développé des outils pour neutraliser ses dispositifs de sécurité, permettant ainsi l’extraction massive de contenus protégés.

Au cœur du litige se trouve SearchGuard, une technologie déployée en janvier dernier pour restreindre l’accès automatisé aux pages de résultats. Cette mesure technologique vise à distinguer les utilisateurs humains légitimes des robots automatisés qui aspirent les données à grande échelle. Selon les documents judiciaires, SerpApi aurait immédiatement entrepris de contourner ces protections, développant des méthodes sophistiquées pour masquer la nature réelle de ses requêtes.

Les violations alléguées dans le cadre du litige

Google détaille plusieurs types de violations dans sa plainte. La première concerne le contournement des mesures de protection techniques, considéré comme une infraction fédérale aux États-Unis. La seconde porte sur l’appropriation et la revente de contenus protégés par le droit d’auteur, notamment des images et des informations structurées apparaissant dans les modules de recherche enrichis.

| Type de violation | Description | Base légale |

|---|---|---|

| Contournement technique | Neutralisation de SearchGuard et autres protections | DMCA Section 1201 |

| Extraction illégale | Collecte massive de données protégées | Copyright Act |

| Usurpation d’identité | Création de faux navigateurs simulant des utilisateurs réels | Computer Fraud and Abuse Act |

| Violation contractuelle | Non-respect des conditions d’utilisation de Google | Droit des contrats |

Les demandes formulées par Google auprès du tribunal fédéral sont sans ambiguïté. Le géant technologique exige non seulement l’arrêt immédiat des activités de scraping, mais également la destruction de toute technologie développée pour contourner ses mesures de protection. Cette approche radicale témoigne de la gravité avec laquelle Google perçoit cette menace pour son modèle économique.

- Cessation immédiate de toutes les activités d’extraction automatisée

- Destruction des outils et technologies de contournement

- Dommages et intérêts pour les préjudices subis

- Remboursement des frais juridiques engagés

- Interdiction permanente d’accès aux systèmes de Google

Cette action en justice s’inscrit dans une stratégie plus large de protection de la propriété intellectuelle. Google investit des milliards dans le développement de son moteur de recherche, l’acquisition de contenus sous licence et l’amélioration continue de ses algorithmes. L’entreprise considère que permettre à des tiers d’extraire et de revendre ces données sape directement ces investissements colossaux.

Le cadre légal du scraping aux États-Unis

La légalité du scraping web reste un terrain juridique complexe et évolutif aux États-Unis. Plusieurs décisions récentes ont établi que le scraping de données publiquement accessibles pouvait être légal dans certaines circonstances. Cependant, le contournement actif de mesures techniques de protection change radicalement la donne juridique.

L’affaire hiQ Labs contre LinkedIn en 2022 avait créé un précédent en faveur du scraping de données publiques. Toutefois, la Cour suprême a refusé d’examiner ce cas, laissant la question juridique partiellement irrésolue. La plainte de Google contre SerpApi se distingue en mettant l’accent sur le contournement délibéré de protections techniques, un aspect qui pourrait orienter favorablement la décision judiciaire.

Les implications de cette affaire dépassent le seul cas de SerpApi. De nombreuses entreprises technologiques surveillent attentivement l’évolution de ce dossier, conscientes que la décision judiciaire pourrait redéfinir les limites du scraping légal. Dans un contexte où les géants technologiques font face à une pression croissante, cette bataille juridique revêt une importance stratégique majeure.

Les techniques de contournement déployées par SerpApi selon Google

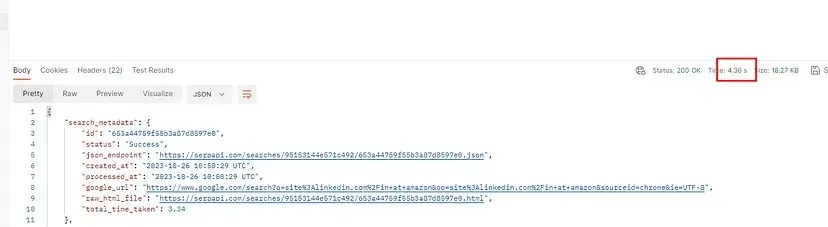

Les documents judiciaires révèlent l’ampleur et la sophistication des méthodes employées par SerpApi pour extraire les résultats de recherche. Selon Google, l’entreprise texane aurait mis en place une infrastructure massive permettant d’envoyer des centaines de millions de requêtes quotidiennes, tout en dissimulant leur nature automatisée.

Le fondateur de SerpApi aurait décrit publiquement son processus comme la « création de faux navigateurs utilisant une multitude d’adresses IP ». Cette technique vise à simuler le comportement d’utilisateurs humains normaux, rendant difficile pour les systèmes de Google de distinguer les requêtes légitimes des opérations d’extraction automatisée. L’entreprise aurait ainsi développé des outils capables de reproduire fidèlement les caractéristiques des navigateurs web standards.

L’explosion du volume de requêtes frauduleuses

Les chiffres avancés par Google dans sa plainte sont vertigineux. Le volume de requêtes provenant de SerpApi aurait augmenté de 25 000 % en seulement deux ans, atteignant des centaines de millions de requêtes quotidiennes. Cette croissance exponentielle correspond à l’explosion de la demande en données structurées, alimentée notamment par le développement des modèles d’intelligence artificielle.

| Période | Volume quotidien estimé | Évolution |

|---|---|---|

| Début 2023 | 1-2 millions de requêtes | Base de référence |

| Mi-2024 | 50-75 millions de requêtes | +5000% |

| Début 2025 | 250-300 millions de requêtes | +25000% |

Pour contourner les mesures de détection, SerpApi aurait déployé plusieurs stratégies techniques sophistiquées. La rotation massive d’adresses IP constitue la première ligne de défense contre les blocages. En utilisant des milliers voire des dizaines de milliers d’adresses IP différentes, l’entreprise dilue le trafic et rend plus difficile son identification comme provenant d’une source unique.

- Rotation automatique de milliers d’adresses IP résidentielles et commerciales

- Émulation précise des empreintes digitales de navigateurs réels

- Simulation de comportements humains avec délais aléatoires

- Distribution géographique du trafic pour imiter des utilisateurs naturels

- Adaptation continue des techniques en réponse aux contre-mesures

La réponse de Google avec SearchGuard

Face à cette escalade technologique, Google a déployé SearchGuard en janvier comme bouclier numérique. Cette mesure de protection des données combine plusieurs technologies pour identifier et bloquer les tentatives d’accès automatisé. Les mécanismes exacts restent confidentiels pour des raisons de sécurité, mais ils impliquent probablement l’analyse comportementale, la détection d’anomalies dans les patterns de requêtes et des systèmes de vérification avancés.

La rapidité avec laquelle SerpApi aurait contourné SearchGuard témoigne de la course aux armements technologiques entre les plateformes et les scrapers. Selon la plainte, l’entreprise aurait adapté ses outils dans les jours suivant le déploiement de la protection, suggérant une surveillance active des changements apportés par Google et des ressources dédiées à l’ingénierie inverse.

Cette dynamique rappelle les défis auxquels font face d’autres secteurs confrontés à des problématiques similaires. Les techniques déployées dans la lutte contre les activités numériques malveillantes évoluent constamment, nécessitant des innovations permanentes.

Les enjeux économiques et stratégiques de l’extraction illégale

Au-delà des aspects purement juridiques, cette bataille oppose deux modèles économiques radicalement différents. Google investit massivement dans la production et la structuration d’informations, négociant des accords de licence avec des milliers de créateurs de contenu. SerpApi, de son côté, propose un service permettant d’accéder à ces données structurées sans passer par les canaux officiels, court-circuant ainsi tout le modèle économique traditionnel.

Le modèle d’affaires de SerpApi repose sur la vente d’accès à des données extraites de Google et d’autres moteurs de recherche. L’entreprise propose des API permettant à ses clients d’interroger les résultats de recherche de manière programmatique, sans avoir à développer leurs propres infrastructures de scraping. Ce service trouve preneur auprès de développeurs, chercheurs, entreprises de référencement et probablement des sociétés d’intelligence artificielle.

Le parasitisme économique dénoncé par Google

Google qualifie explicitement le modèle de SerpApi de « parasitisme économique ». Cette accusation repose sur l’idée que l’entreprise texane profite des investissements colossaux de Google sans contribuer à leur financement. Le moteur de recherche dépense des milliards annuellement pour maintenir son infrastructure, développer ses algorithmes, acquérir des licences de contenu et rémunérer les créateurs via des programmes comme Google News Showcase.

| Type d’investissement Google | Montant estimé annuel | Impact du scraping |

|---|---|---|

| Infrastructure technique | 15-20 milliards USD | Surcharge des serveurs sans revenu |

| Licences de contenu | 3-5 milliards USD | Contournement des accords commerciaux |

| Développement algorithmique | 8-10 milliards USD | Appropriation de la valeur créée |

| Rémunération créateurs | 2-3 milliards USD | Court-circuitage des partenariats |

La question de la propriété intellectuelle des résultats de recherche reste complexe. Google ne crée pas le contenu original qui apparaît dans ses résultats, mais il structure, enrichit et présente ces informations d’une manière qui génère de la valeur. Les modules comme le Knowledge Panel, les featured snippets ou les résultats enrichis sont des créations propres à Google, incorporant souvent des images et des données sous licence.

- Structures de données propriétaires développées par Google

- Images sous licence affichées dans les modules enrichis

- Graphes de connaissances construits sur des années

- Algorithmes de pertinence et de classement

- Enrichissements sémantiques et contextuels

L’impact sur l’écosystème numérique global

Cette affaire s’inscrit dans un contexte plus large de tensions autour de l’accès aux données numériques. Reddit a également poursuivi SerpApi en octobre, accusant l’entreprise d’extraire massivement son contenu. D’autres plateformes comme Twitter (devenu X) ont considérablement restreint l’accès à leurs API, citant des préoccupations similaires concernant l’utilisation de leurs données pour entraîner des modèles d’IA.

Les entreprises d’intelligence artificielle figurent parmi les principaux bénéficiaires potentiels des services comme ceux offerts par SerpApi. L’entraînement de modèles de langage performants nécessite des quantités astronomiques de données structurées et à jour. Bien que la plainte de Google ne mentionne pas explicitement Perplexity ou d’autres acteurs de l’IA, les observateurs établissent des liens avec les investigations menées par Reddit sur l’utilisation de son contenu.

L’équilibre entre l’accès ouvert à l’information et la protection des investissements commerciaux reste un défi majeur. Certains défenseurs du web ouvert craignent que des restrictions trop strictes n’entravent l’innovation et la recherche académique. D’autres soulignent que sans protection des investissements, les plateformes n’auront plus les moyens de maintenir des services de qualité, comme on le voit dans d’autres secteurs confrontés à des défis similaires.

Les précédents juridiques et leurs implications pour l’avenir du scraping

L’affaire Google contre SerpApi ne constitue pas un cas isolé dans le paysage juridique du scraping web. Plusieurs litiges importants ont façonné la compréhension légale de cette pratique au cours des dernières années, créant un corpus jurisprudentiel complexe et parfois contradictoire.

L’affaire hiQ Labs contre LinkedIn demeure l’une des références majeures en la matière. Dans ce cas, LinkedIn avait tenté d’empêcher hiQ Labs d’extraire les profils publics de ses utilisateurs pour proposer des services d’analyse prédictive aux employeurs. Les tribunaux avaient initialement donné raison à hiQ, jugeant que les données publiquement accessibles pouvaient être extraites. Cette décision avait créé un précédent favorable aux scrapers, avant d’être partiellement remise en question par des évolutions judiciaires ultérieures.

Les différences fondamentales entre les affaires de scraping

Chaque litige lié au scraping présente des spécificités qui influencent son issue juridique. Dans le cas de Google contre SerpApi, plusieurs éléments distinguent cette affaire des précédents et pourraient orienter la décision judiciaire dans un sens différent.

| Critère | hiQ vs LinkedIn | Google vs SerpApi |

|---|---|---|

| Nature des données | Profils publics d’utilisateurs | Résultats incluant contenus sous licence |

| Mesures de protection | Blocages IP basiques | SearchGuard, système de protection avancé |

| Contournement actif | Non allégué | Au cœur de l’accusation |

| Volume d’extraction | Modéré | Centaines de millions de requêtes quotidiennes |

| Impact commercial | Indirect | Revente directe des données extraites |

La question du contournement actif de mesures techniques représente l’élément central qui distingue cette affaire. Le Digital Millennium Copyright Act (DMCA) interdit explicitement la neutralisation de protections techniques, une disposition qui pourrait jouer en faveur de Google. Contrairement aux affaires précédentes où les accusés se contentaient d’extraire des données publiquement accessibles, SerpApi aurait délibérément développé des outils pour contourner des barrières de sécurité.

- Développement d’outils spécifiques de contournement

- Adaptation continue aux contre-mesures déployées

- Documentation interne potentiellement compromettante

- Échelle industrielle des opérations d’extraction

- Commercialisation directe des données obtenues illégalement

L’évolution de la jurisprudence sur la protection des données web

Les tribunaux américains ont progressivement affiné leur approche du scraping, reconnaissant que toutes les situations ne se valent pas. La distinction entre extraction passive de données publiques et contournement actif de protections semble se cristalliser comme critère déterminant. Cette évolution pourrait bénéficier à Google dans sa bataille contre SerpApi.

D’autres affaires récentes ont également contribué à dessiner les contours légaux du scraping. Le procès intenté par Meta contre BrandTotal et Unimania pour extraction de données via de fausses extensions de navigateur a établi que les techniques trompeuses constituaient une violation légale, indépendamment de l’accessibilité publique des données.

La multiplication des litiges témoigne d’un phénomène plus large. À mesure que les modèles d’intelligence artificielle nécessitent des volumes de données toujours plus importants, la pression sur les sources de données structurées s’intensifie. Les plateformes comme Google, Reddit ou LinkedIn voient leurs infrastructures sollicitées massivement, sans compensation ni accord préalable. Cette situation rappelle les enjeux observés dans d’autres domaines, comme les débats autour de l’utilisation détournée d’outils numériques.

Les conséquences potentielles pour l’industrie du scraping et de l’IA

L’issue de cette bataille juridique pourrait redéfinir les règles du jeu pour toute l’industrie de l’extraction de données. Des dizaines d’entreprises proposent des services similaires à ceux de SerpApi, permettant d’accéder programmatiquement aux résultats de moteurs de recherche, réseaux sociaux ou sites d’e-commerce. Une décision favorable à Google créerait un précédent juridique applicable à l’ensemble de cet écosystème.

Les entreprises technologiques surveillent cette affaire avec une attention particulière. Les géants du numérique investissent massivement dans la sécurisation de leurs plateformes, mais le retour sur investissement de ces mesures dépend largement de leur reconnaissance juridique. Une victoire de Google légitimerait les dépenses consacrées à la protection contre le scraping et encouragerait d’autres acteurs à durcir leurs défenses.

L’impact sur le développement des modèles d’intelligence artificielle

L’intelligence artificielle constitue probablement le principal enjeu sous-jacent de cette bataille juridique. Les modèles de langage comme GPT, Claude ou Gemini nécessitent des volumes considérables de données web pour leur entraînement. Les services d’extraction automatisée facilitent l’accès à ces données, mais leur légalité conditionnera les stratégies futures des entreprises d’IA.

| Scénario juridique | Impact sur l’IA | Conséquences économiques |

|---|---|---|

| Victoire de Google | Obligation d’accords de licence formels | Augmentation drastique des coûts d’entraînement |

| Victoire de SerpApi | Maintien de l’accès via scraping | Statu quo pour les entreprises d’IA |

| Décision nuancée | Distinction entre usages commerciaux et recherche | Fragmentation du marché des données |

Plusieurs entreprises d’intelligence artificielle ont déjà anticipé ce durcissement réglementaire en négociant des accords de licence directement avec les plateformes. OpenAI a signé des partenariats avec Reddit, l’Associated Press et d’autres médias. Google dispose évidemment d’un avantage concurrentiel majeur avec l’accès à ses propres données. Anthropic et d’autres acteurs explorent des modèles alternatifs de collecte respectant davantage les droits des créateurs.

- Multiplication des accords de licence entre IA et plateformes

- Développement de datasets synthétiques pour contourner les restrictions

- Émergence de places de marché pour données d’entraînement certifiées

- Concentration du pouvoir chez les entreprises disposant de données propriétaires

- Exploration de techniques d’entraînement nécessitant moins de données

Les alternatives légales à l’extraction automatisée

Face aux risques juridiques croissants, l’industrie explore des alternatives au scraping traditionnel. Les API officielles constituent la première option, bien que leur coût et leurs limitations en restreignent l’attractivité. Google propose déjà des API permettant d’accéder à certaines données de recherche, mais avec des quotas et des tarifications qui rendent impossibles les extractions massives.

Les partenariats directs représentent une autre voie, particulièrement pour les acteurs majeurs capables de négocier. Ces accords permettent un accès structuré aux données tout en rémunérant les plateformes pour leurs investissements. Le modèle rappelle l’évolution observée dans d’autres secteurs face à des défis similaires, comme l’innovation dans les technologies émergentes qui nécessitent des cadres collaboratifs.

Les données synthétiques et le web crawling éthique émergent comme alternatives prometteuses. Plutôt que d’extraire massivement des plateformes commerciales, certaines entreprises se concentrent sur les données ouvertes, les archives publiques et les contenus explicitement autorisés. Cette approche limite les risques juridiques mais nécessite des efforts supplémentaires de curation et de validation.

L’affaire Google contre SerpApi pourrait catalyser l’émergence d’un nouveau paradigme où l’accès aux données numériques repose davantage sur des relations contractuelles formelles que sur l’extraction opportuniste. Cette évolution transformerait profondément l’économie numérique, avec des gagnants et des perdants clairement identifiés selon leur capacité à s’adapter à ce nouveau cadre.

Qu’est-ce que SerpApi et pourquoi Google la poursuit en justice ?

SerpApi est une entreprise texane spécialisée dans l’extraction automatisée de résultats de moteurs de recherche. Google la poursuit pour avoir contourné ses mesures de sécurité, notamment SearchGuard, afin d’extraire et revendre massivement des données protégées par le droit d’auteur, violant ainsi le Copyright Act américain et les conditions d’utilisation de la plateforme.

Le scraping de données web est-il légal ?

La légalité du scraping dépend de plusieurs facteurs : l’accessibilité publique des données, l’existence de mesures techniques de protection, les conditions d’utilisation du site et l’usage fait des données extraites. Le scraping de données publiques sans contournement de protections peut être légal, mais le contournement actif de mesures de sécurité constitue généralement une violation du DMCA.

Quel volume de données SerpApi extrayait-il selon Google ?

Selon la plainte de Google, SerpApi envoyait des centaines de millions de requêtes quotidiennes, avec une croissance explosive de 25 000 % en deux ans. L’entreprise aurait utilisé des milliers d’adresses IP différentes et créé de faux navigateurs pour masquer la nature automatisée de ses opérations et contourner les systèmes de détection de Google.

Quelles conséquences cette affaire pourrait-elle avoir sur l’intelligence artificielle ?

Une victoire de Google pourrait obliger les entreprises d’IA à négocier des accords de licence formels pour accéder aux données d’entraînement, augmentant considérablement leurs coûts. Cela favoriserait les grandes entreprises disposant de données propriétaires et pourrait stimuler le développement d’alternatives comme les données synthétiques ou les datasets ouverts.

Qu’est-ce que SearchGuard et comment fonctionne-t-il ?

SearchGuard est une mesure technologique de protection déployée par Google en janvier pour restreindre l’accès automatisé à ses pages de résultats. Bien que les mécanismes exacts restent confidentiels, cette technologie combine probablement analyse comportementale, détection d’anomalies dans les patterns de requêtes et systèmes de vérification avancés pour distinguer utilisateurs humains et robots automatisés.