L’intégration de l’intelligence artificielle dans les moteurs de recherche devait simplifier l’accès à l’information. Pourtant, la récente polémique autour de Google démontre que la technologie n’est pas infaillible, surtout lorsqu’il s’agit de santé publique. Le géant américain a dû retirer en urgence plusieurs résumés générés automatiquement après qu’une enquête du Guardian a révélé la diffusion de fausses informations potentiellement dangereuses dans le domaine médical.

Cette affaire soulève des questions fondamentales sur la fiabilité des réponses automatisées et la responsabilité des plateformes dans la sécurité en ligne. Alors que des millions d’utilisateurs consultent quotidiennement Chrome pour obtenir des conseils de santé, la désinformation générée par l’IA pourrait avoir des conséquences graves sur les décisions médicales des internautes.

AI Overviews et la promesse d’une recherche intelligente devenue risquée

La fonctionnalité AI Overviews, développée par Google pour son navigateur Chrome, propose des réponses synthétiques générées par l’IA Gemini. Cette innovation visait à offrir aux utilisateurs des informations instantanées sans avoir à parcourir plusieurs pages de résultats. Déployée depuis plusieurs mois aux États-Unis et en Grande-Bretagne, elle affiche des résumés en haut des résultats de recherche, avant même les liens classiques.

Le principe semble séduisant : poser une question et obtenir immédiatement une réponse claire, structurée par l’intelligence artificielle. Mais cette apparente simplicité cache des failles majeures dans le traitement des données sensibles. Contrairement aux résultats de recherche traditionnels qui renvoient vers des sources identifiables, ces résumés présentent l’information comme une vérité absolue, sans nuance ni contexte médical approprié.

L’enquête du Guardian a mis en lumière des erreurs alarmantes dans les recommandations de santé. Par exemple, l’IA conseillait aux patients atteints d’un cancer du pancréas d’éviter les aliments riches en matières grasses, alors que les professionnels de santé recommandent exactement l’inverse pour ce type de pathologie. Cette contradiction flagrante avec les protocoles médicaux établis illustre les risques considérables des résumés automatisés dans le domaine de la santé.

Les mécanismes défaillants de la génération automatique

Pour comprendre comment l’IA de Google a pu commettre de telles erreurs, il faut analyser son fonctionnement. Les modèles de langage comme Gemini sont entraînés sur d’immenses volumes de données textuelles récupérées sur Internet. Or, le web regorge d’informations contradictoires, obsolètes ou simplement erronées sur la santé. L’algorithme compile ces données sans exercer de jugement critique ni vérifier leur pertinence médicale.

Le problème s’aggrave lorsque l’IA tente de synthétiser des informations complexes en quelques phrases. Les nuances médicales, les exceptions selon les profils de patients et les recommandations contextuelles disparaissent au profit de généralités potentiellement dangereuses. Cette simplification excessive transforme la navigation sûre en parcours semé d’embûches pour les personnes cherchant des conseils de santé.

- Absence de validation médicale des contenus générés avant publication

- Mélange de sources fiables et non fiables sans hiérarchisation

- Incapacité à contextualiser les recommandations selon les cas individuels

- Présentation autoritaire d’informations parfois contradictoires

- Manque de transparence sur les sources utilisées pour générer les résumés

| Pathologie | Recommandation de l’IA | Avis médical réel | Risque potentiel |

|---|---|---|---|

| Cancer du pancréas | Éviter les matières grasses | Privilégier les aliments caloriques | Dénutrition et aggravation |

| Maladies hépatiques | Minimisation des symptômes | Consultation urgente recommandée | Retard de diagnostic |

| Maladies du foie | Normalisation de signes alarmants | Dépistage précoce essentiel | Évolution silencieuse de la maladie |

Les conséquences alarmantes pour la santé publique

Pamela Healy, directrice de l’association British Liver Trust, a exprimé des préoccupations majeures concernant ces fausses informations. Selon elle, de nombreuses personnes atteintes de maladies hépatiques ne présentent aucun symptôme avant un dépistage spécifique. Les résumés générés par l’IA peuvent minimiser ou normaliser des signes qui devraient alerter, conduisant les patients à repousser une consultation médicale nécessaire.

Cette désinformation médicale va bien au-delà d’une simple erreur technique. Elle touche directement à la capacité des individus à prendre des décisions éclairées concernant leur santé. Lorsqu’un utilisateur cherche des informations sur des symptômes inquiétants, il s’attend légitimement à recevoir des conseils fiables de la part d’une plateforme aussi établie que Google. La confiance accordée au moteur de recherche amplifie l’impact des erreurs diffusées.

Les professionnels de santé s’inquiètent particulièrement de la présentation autoritaire des informations. Contrairement aux forums ou sites douteux que les internautes peuvent identifier comme sources à vérifier, les résumés AI Overviews apparaissent comme une réponse officielle de Google lui-même. Cette légitimité perçue rend la désinformation encore plus insidieuse et difficile à contrer.

L’impact psychologique de l’information médicale erronée

Au-delà des risques physiques directs, la diffusion d’informations trompeuses par l’IA génère des conséquences psychologiques importantes. Un patient qui reçoit des informations rassurantes sur des symptômes graves peut développer un faux sentiment de sécurité, retardant ainsi des interventions médicales cruciales. À l’inverse, des informations anxiogènes ou contradictoires peuvent provoquer une détresse inutile chez des personnes en bonne santé.

Le phénomène de cyberchondrie, cette tendance à s’auto-diagnostiquer via Internet, s’aggrave avec ces résumés automatisés. Plutôt que d’encourager une consultation médicale appropriée, l’IA peut orienter vers des conclusions hâtives et inappropriées. La vérification des faits devient alors quasi impossible pour un utilisateur non expert face à une réponse présentée comme définitive par une technologie réputée fiable.

- Retard de diagnostic pour des pathologies graves nécessitant une prise en charge rapide

- Automédication inappropriée basée sur des recommandations erronées

- Anxiété accrue face à des informations contradictoires ou alarmistes

- Perte de confiance dans les sources d’information légitimes

- Abandon de traitements sur la base de conseils inadaptés

| Type d’erreur | Exemple concret | Conséquence possible | Population à risque |

|---|---|---|---|

| Minimisation des symptômes | Présenter une fatigue extrême comme normale | Non-détection d’une anémie sévère | Personnes âgées, femmes enceintes |

| Recommandations alimentaires | Conseils inappropriés pour diabétiques | Déséquilibre glycémique dangereux | Patients diabétiques |

| Sous-estimation de l’urgence | Banalisation de douleurs thoraciques | Retard face à un infarctus | Personnes à risque cardiovasculaire |

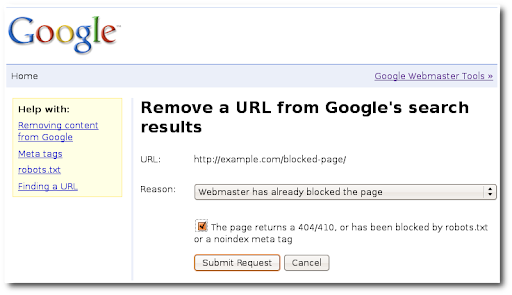

La réaction de Google face à la controverse

Suite à la publication de l’enquête du Guardian, le site TechCrunch a tenté de reproduire les recherches problématiques mentionnées dans l’article. Surprise : les résumés générés par l’intelligence artificielle avaient disparu. Google avait discrètement retiré les informations incriminées sans communiquer publiquement sur cette action corrective. Cette gestion opaque de la crise soulève des interrogations sur la transparence de l’entreprise face aux erreurs de ses systèmes automatisés.

Interrogé sur ces suppressions, Google a refusé de commenter directement les retraits spécifiques. L’entreprise s’est contentée d’indiquer qu’elle effectuait régulièrement des améliorations sur la fonctionnalité AI Overviews. Cette réponse évasive contraste avec la gravité des erreurs médicales diffusées et l’urgence d’une communication claire envers les utilisateurs potentiellement affectés.

Les mesures correctives insuffisantes

Le retrait silencieux des résumés problématiques pose la question de la gouvernance des systèmes d’IA. Les AI Overviews continuent de fonctionner pour d’autres requêtes, sans qu’il soit possible de savoir quelles autres erreurs subsistent. L’absence de processus transparent de vérification des faits avant publication et de correction systématique après détection laisse planer un doute sur la fiabilité globale du système.

Les experts en sécurité en ligne recommandent la mise en place de garde-fous stricts pour les domaines sensibles comme la santé. Certains suggèrent qu’une validation humaine par des professionnels médicaux devrait être obligatoire avant la diffusion de tout résumé IA concernant des pathologies ou des traitements. D’autres plaident pour un étiquetage clair indiquant que les informations générées automatiquement ne remplacent pas un avis médical professionnel.

- Suppression réactive des contenus signalés sans correction proactive du système

- Absence de notification aux utilisateurs ayant consulté les informations erronées

- Manque de transparence sur les critères de retrait des résumés

- Poursuite du déploiement malgré les failles identifiées

- Communication minimale sur les risques potentiels

| Action requise | Statut actuel | Impact potentiel | Délai nécessaire |

|---|---|---|---|

| Validation médicale des résumés santé | Non implémentée | Réduction des erreurs graves | 3-6 mois |

| Avertissement systématique | Absent | Responsabilisation des utilisateurs | Immédiat |

| Audit complet des contenus médicaux | Inconnu | Identification des failles systémiques | 6-12 mois |

| Transparence sur les sources | Limitée | Amélioration de la confiance | 1-3 mois |

Les enjeux plus larges de l’IA dans l’information médicale

Cette affaire dépasse largement le cas isolé de Google. Elle révèle les défis systémiques de l’intégration de l’intelligence artificielle dans des domaines où l’exactitude est vitale. La concurrence entre géants technologiques pour proposer des expériences toujours plus fluides et instantanées conduit parfois à négliger les étapes essentielles de validation et de contrôle qualité. La rivalité avec des plateformes comme ChatGPT pousse les entreprises à accélérer leurs déploiements sans toujours garantir la fiabilité requise.

Les algorithmes d’IA excellent dans certaines tâches, mais la médecine requiert une compréhension contextuelle, une évaluation nuancée et une responsabilité que les systèmes actuels ne peuvent assumer. Lorsqu’un médecin se trompe, des mécanismes de responsabilité juridique et déontologique existent. Lorsqu’une IA diffuse une information erronée à des millions d’utilisateurs, qui porte la responsabilité légale et éthique de ces erreurs potentiellement fatales ?

Les défis techniques de la fiabilité médicale

Les modèles de langage actuels présentent des limitations fondamentales pour traiter l’information médicale. Ils ne comprennent pas véritablement le contenu qu’ils génèrent, mais identifient des patterns statistiques dans les données d’entraînement. Cette approche fonctionne raisonnablement pour des questions générales, mais s’avère catastrophique pour des domaines nécessitant précision et expertise. Une erreur de quelques mots dans une recommandation peut faire la différence entre un traitement approprié et une aggravation de l’état du patient.

La technologie devrait servir d’outil d’orientation vers des sources médicales fiables plutôt que de prétendre fournir directement des conseils de santé. Un système responsable indiquerait clairement les limites de ses capacités et redirigerait systématiquement vers des professionnels qualifiés pour toute question impliquant des décisions médicales. Cette approche humble mais honnête protégerait mieux les utilisateurs tout en exploitant les capacités réelles de l’IA.

- Absence de compréhension sémantique réelle du contenu médical

- Incapacité à évaluer la crédibilité des sources utilisées

- Manque d’actualisation face à l’évolution rapide des connaissances médicales

- Impossibilité de personnalisation selon les profils individuels des patients

- Absence de conscience des implications éthiques et légales

| Limitation technique | Manifestation concrète | Solution envisageable | Difficulté de mise en œuvre |

|---|---|---|---|

| Hallucinations de l’IA | Invention d’informations inexistantes | Vérification systématique par sources | Élevée |

| Biais des données d’entraînement | Reproduction de désinformation courante | Curation stricte des sources | Très élevée |

| Manque de contextualisation | Conseils génériques inadaptés | Redirection vers professionnels | Moyenne |

| Obsolescence rapide | Informations dépassées | Mise à jour continue des modèles | Élevée |

Vers une navigation plus sûre et responsable

L’incident des résumés médicaux erronés de Google constitue un signal d’alarme pour l’ensemble de l’industrie technologique. Les utilisateurs de Chrome et d’autres plateformes intégrant l’IA attendent désormais des garanties concrètes concernant la fiabilité des informations automatisées, particulièrement dans les domaines critiques. La navigation sûre ne peut se limiter à la protection contre les virus et malwares, elle doit également englober la protection contre la désinformation potentiellement mortelle.

Plusieurs pistes s’ouvrent pour améliorer la situation. Les régulateurs commencent à s’intéresser à la responsabilité des plateformes diffusant des contenus générés par IA. Des cadres juridiques spécifiques pourraient imposer des standards minimaux de qualité et de vérification pour les informations médicales automatisées. En parallèle, les entreprises technologiques doivent développer une culture de prudence et d’humilité face aux limites actuelles de leurs systèmes.

Le rôle crucial de la formation des utilisateurs

Au-delà des améliorations techniques, l’éducation des utilisateurs devient essentielle. Trop de personnes accordent une confiance aveugle aux résultats affichés par les moteurs de recherche, sans exercer leur esprit critique. Des campagnes de sensibilisation devraient rappeler que les résumés automatisés ne remplacent jamais l’expertise d’un professionnel de santé. Cette prise de conscience collective constitue une défense importante contre les risques de la désinformation médicale en ligne.

Les établissements de santé et les autorités médicales ont également un rôle à jouer en proposant des ressources fiables facilement accessibles. Plutôt que de laisser les patients se tourner vers des IA non validées, le développement de plateformes médicales officielles exploitant l’IA de manière responsable pourrait offrir une alternative crédible. La garantie de la sécurité dans l’information numérique requiert une approche globale associant technologie, réglementation et éducation.

- Développement de labels de qualité pour les sources d’information médicale en ligne

- Intégration d’avertissements clairs sur les limites des résumés automatisés

- Promotion de la littératie numérique dès l’école pour développer l’esprit critique

- Création de plateformes médicales officielles exploitant l’IA de manière sécurisée

- Renforcement de la collaboration entre technologues et professionnels de santé

| Acteur | Responsabilité | Action concrète | Échéance |

|---|---|---|---|

| Entreprises technologiques | Garantir la fiabilité des contenus | Validation médicale systématique | Court terme |

| Régulateurs | Établir des standards obligatoires | Législation sur l’IA médicale | Moyen terme |

| Professionnels de santé | Fournir des alternatives fiables | Plateformes médicales officielles | Moyen terme |

| Éducation nationale | Former à l’esprit critique | Programmes de littératie numérique | Long terme |

| Utilisateurs | Exercer leur discernement | Consultation systématique de professionnels | Immédiat |

La route vers une utilisation responsable de l’intelligence artificielle dans le domaine médical reste longue. Les erreurs commises par Google démontrent que la rapidité technologique ne doit pas primer sur la sécurité sanitaire. Chaque résumé erroné diffusé à des millions d’utilisateurs représente un risque multiplié à l’échelle collective. La vérification des faits et la validation par des experts doivent redevenir des priorités absolues avant toute diffusion d’informations de santé.

Les prochains mois seront déterminants pour observer si les plateformes technologiques sauront tirer les leçons de cet incident. L’enjeu dépasse les intérêts commerciaux d’une entreprise : il s’agit de protéger la santé publique à l’ère de l’automatisation croissante de l’information. La technologie peut être un formidable outil au service de la santé, à condition qu’elle soit développée et déployée avec la rigueur que ce domaine exige.

Qu’est-ce que la fonctionnalité AI Overviews de Google ?

AI Overviews est une fonctionnalité développée par Google pour Chrome qui génère automatiquement des résumés de réponses via l’intelligence artificielle Gemini. Ces résumés apparaissent en haut des résultats de recherche, avant les liens traditionnels, pour fournir une réponse rapide aux requêtes des utilisateurs. Cette fonction est actuellement déployée dans certains pays comme les États-Unis et la Grande-Bretagne, mais pas encore en France.

Pourquoi Google a-t-il retiré certains résumés médicaux générés par IA ?

Google a retiré des résumés médicaux après qu’une enquête du Guardian a révélé que ces contenus diffusaient des informations incorrectes et potentiellement dangereuses. Par exemple, l’IA conseillait aux patients atteints de cancer du pancréas d’éviter les aliments riches en matières grasses, alors que les médecins recommandent l’inverse. Ces erreurs représentaient un risque majeur pour la santé publique.

Peut-on faire confiance aux résumés médicaux générés par intelligence artificielle ?

Les résumés médicaux générés par IA présentent actuellement des risques importants car ils manquent de validation par des professionnels de santé. Les algorithmes peuvent mélanger des sources fiables et non fiables, simplifier excessivement des recommandations complexes, et présenter des informations erronées avec une apparence d’autorité. Il est recommandé de toujours consulter un professionnel de santé plutôt que de se fier uniquement à ces résumés automatisés.

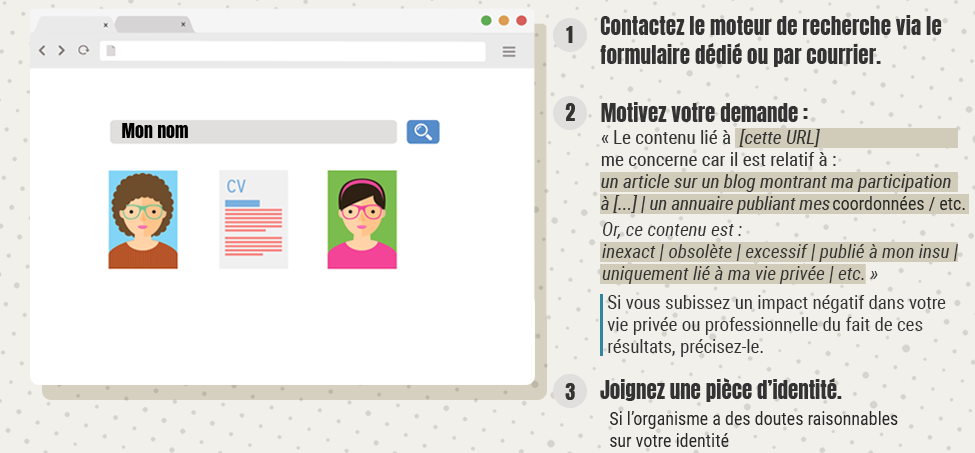

Comment identifier les informations médicales fiables en ligne ?

Pour identifier des informations médicales fiables, privilégiez les sites officiels d’établissements de santé, les publications d’organisations médicales reconnues, et les plateformes validées par des professionnels. Vérifiez toujours la date de publication, l’existence de sources citées, et la présence de signatures par des experts identifiables. Méfiez-vous des conseils présentés de manière définitive sans nuances ni renvoi vers une consultation médicale.

Quelles sont les limites actuelles de l’IA dans le domaine médical ?

Les principales limites de l’IA médicale incluent l’absence de compréhension réelle du contenu, l’incapacité à contextualiser selon les profils individuels, la reproduction de biais présents dans les données d’entraînement, et le phénomène d’hallucinations où l’IA invente des informations. Les modèles actuels ne peuvent pas remplacer le jugement clinique d’un professionnel de santé qui prend en compte l’historique complet du patient et les subtilités de chaque cas.