Google vient de frapper fort dans la bataille incessante de l’intelligence artificielle en dévoilant Gemini 3.1 Pro, un modèle de langage qui redéfinit les standards du secteur. Lancé le 19 février, ce nouveau fleuron technologique affiche des performances spectaculaires avec un score de 77,1 % sur le benchmark ARC-AGI-2, doublant ainsi les capacités de son prédécesseur direct. Cette étoile montante du machine learning surpasse désormais Claude Opus 4.6 et GPT-5.2 sur la majorité des tests de référence, consolidant la position de Google comme acteur incontournable de l’innovation en IA avancée. Disponible en version d’aperçu pour les abonnés aux formules Google AI Pro et Google AI Ultra, ce transformeur de nouvelle génération marque un tournant décisif dans l’approche de la firme de Mountain View.

Un bond technologique spectaculaire en seulement trois mois de développement

Le rythme effréné de l’innovation chez Google stupéfie l’ensemble de l’industrie technologique. Alors que Gemini 3 Pro avait été salué pour ses performances révolutionnaires, son successeur arrive déjà sur le marché après seulement trois mois de gestation. Cette cadence accélérée rompt avec la stratégie antérieure qui privilégiait des mises à jour espacées et des versions intermédiaires numérotées en « .5 ».

La firme américaine adopte désormais une convention de nommage plus directe avec cette version « .1 », signalant une ambition claire : itérer rapidement pour maintenir une longueur d’avance sur la concurrence. Cette stratégie s’inspire directement du modèle d’OpenAI, qui multiplie les versions de ses produits phares à un rythme soutenu. Le paysage de l’intelligence artificielle se transforme ainsi en une course à l’échalote permanente où chaque trimestre apporte son lot de nouveautés.

Les équipes de Google ont concentré leurs efforts sur l’amélioration des capacités de raisonnement du modèle. Contrairement aux versions grand public comme Gemini 3.0 Flash qui répondent instantanément aux requêtes courantes, Gemini 3.1 Pro prend parfois plusieurs secondes pour analyser, croiser les sources et synthétiser l’information avant de formuler une réponse. Cette approche dite « de raisonnement » constitue le cœur de l’innovation portée par ce nouveau modèle.

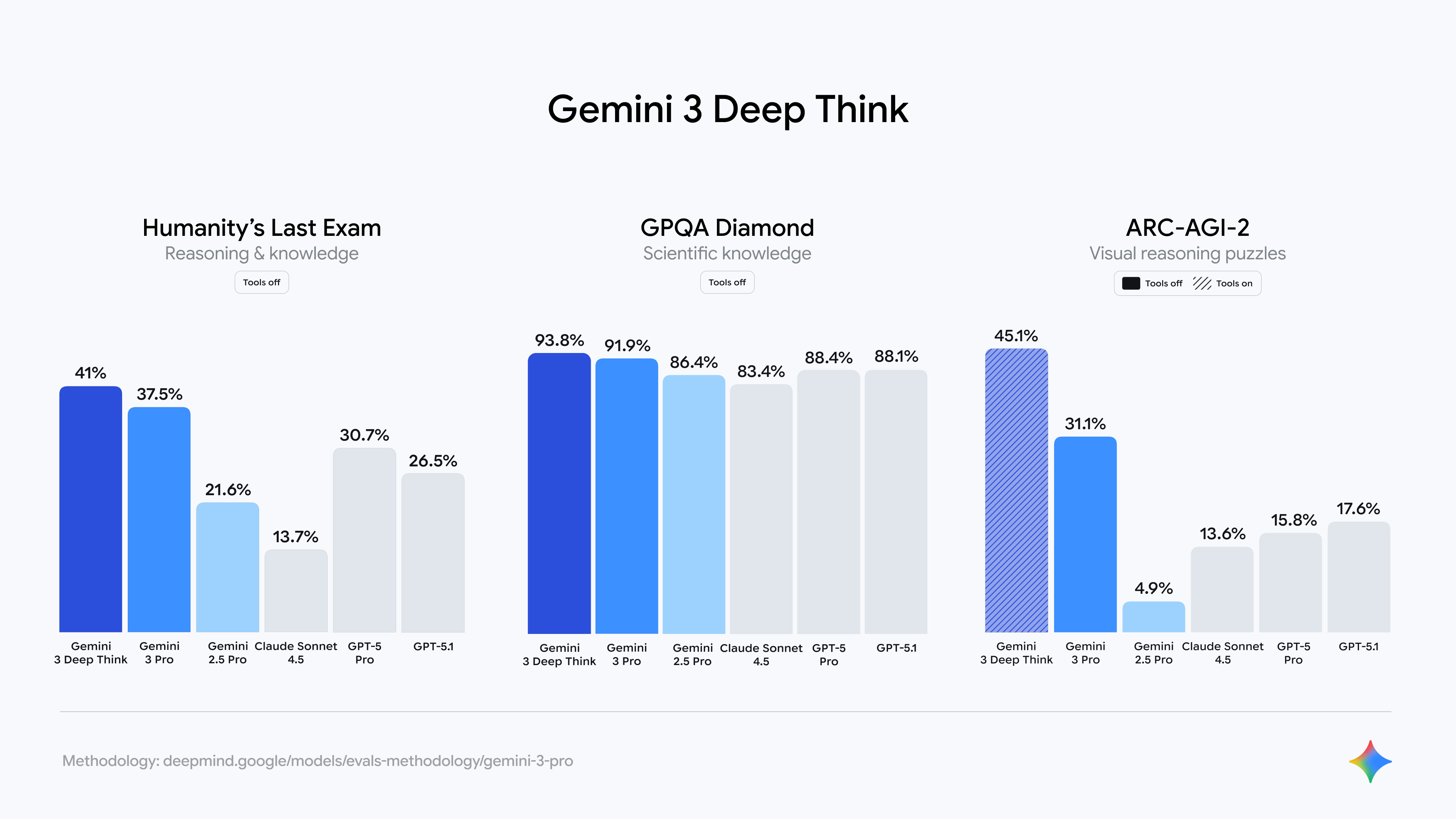

Les résultats parlent d’eux-mêmes : sur le test Humanity’s Last Exam, Gemini 3.1 Pro atteint 44,4 %, établissant un nouveau record dans une évaluation réputée pour sa difficulté extrême. Ces performances témoignent d’une compréhension approfondie des nuances linguistiques et d’une capacité à résoudre des problèmes abstraits qui échappaient jusqu’ici aux systèmes d’IA les plus avancés.

Cette accélération du développement soulève néanmoins des questions sur la durabilité d’un tel rythme. Les ingénieurs doivent maintenir des standards de qualité élevés tout en compressant drastiquement les cycles de développement. La pression concurrentielle impose cette cadence, mais elle exige également des ressources colossales en termes de calcul, d’expertise humaine et d’infrastructure matérielle.

Les coulisses d’une prouesse technique sans précédent

Derrière les chiffres impressionnants se cache une architecture profondément remaniée. Gemini 3.1 Pro exploite des techniques avancées de machine learning qui permettent au modèle d’identifier des patterns complexes dans des volumes massifs de données. Les chercheurs ont optimisé les mécanismes d’attention du transformeur, cette innovation fondamentale qui a révolutionné le traitement du langage naturel.

Le modèle intègre également des améliorations au niveau du préentraînement, exposant les réseaux neuronaux à des corpus de textes encore plus vastes et diversifiés. Cette exposition élargie permet à l’IA de développer une compréhension contextuelle plus fine, essentielle pour traiter des demandes professionnelles complexes nécessitant une analyse multicouche.

L’entraînement de Gemini 3.1 Pro a mobilisé des fermes de calcul gigantesques, consommant des quantités phénoménales d’énergie électrique. Les centres de données dédiés à ce projet fonctionnent 24 heures sur 24, orchestrant des millions de calculs parallèles pour affiner les milliards de paramètres du modèle. Cette infrastructure titanesque représente un investissement financier considérable, reflétant l’importance stratégique que Google accorde à la domination du marché de l’IA avancée.

Des capacités de programmation qui redéfinissent les standards professionnels

C’est dans le domaine de la programmation que Gemini 3.1 Pro révèle tout son potentiel disruptif. Les développeurs constatent que ce nouveau modèle double littéralement les scores de son prédécesseur sur les benchmarks spécialisés en code. Cette progression spectaculaire ouvre des perspectives inédites pour l’automatisation du développement logiciel et la résolution de bugs complexes.

Le modèle démontre une aptitude remarquable à interpréter des spécifications techniques ambiguës et à générer du code fonctionnel dans une multitude de langages de programmation. Qu’il s’agisse de Python, JavaScript, C++, Rust ou même de langages plus exotiques, Gemini 3.1 Pro navigue avec aisance entre les syntaxes et les paradigmes de programmation. Cette polyvalence en fait un assistant précieux pour les équipes de développement confrontées à des architectures logicielles hétérogènes.

Les tests réalisés par des développeurs indépendants révèlent que l’IA peut désormais comprendre et corriger des bases de code comportant plusieurs milliers de lignes. Elle identifie les incohérences logiques, suggère des optimisations de performance et propose même des refactorisations architecturales pertinentes. Cette capacité d’analyse globale distingue nettement Gemini 3.1 Pro des outils d’autocomplétion traditionnels.

L’un des aspects les plus remarquables concerne la génération de tests unitaires. Le modèle analyse le code source, identifie les cas limites potentiels et produit automatiquement une suite de tests complète couvrant les scénarios critiques. Cette fonctionnalité réduit considérablement le temps consacré à l’assurance qualité, permettant aux équipes de se concentrer sur la conception de fonctionnalités innovantes plutôt que sur la maintenance de tests répétitifs.

L’émergence des systèmes agentiques autonomes

Gemini 3.1 Pro pavie la voie vers une nouvelle génération d’outils agentiques capables d’exécuter des actions complexes de manière autonome. Contrairement aux assistants conversationnels classiques qui se contentent de répondre à des questions, ces agents peuvent planifier des séquences d’opérations, interagir avec des API externes et accomplir des tâches de bout en bout sans intervention humaine constante.

Imaginons un développeur qui demande au système : « Crée une application web de gestion de tâches avec authentification utilisateur et base de données PostgreSQL ». Un assistant traditionnel fournirait des instructions ou des fragments de code. Gemini 3.1 Pro, configuré en mode agentique, peut potentiellement initialiser le projet, installer les dépendances nécessaires, structurer l’architecture, générer le code backend et frontend, puis déployer l’application sur un serveur de développement.

Cette autonomie accrue s’accompagne d’une capacité décisionnelle affinée. Le modèle évalue différentes approches techniques, anticipe les implications de ses choix architecturaux et adapte sa stratégie en fonction des contraintes spécifiques du projet. Cette forme d’intelligence pratique représente un saut qualitatif majeur par rapport aux versions précédentes qui nécessitaient un guidage détaillé à chaque étape.

| Fonctionnalité | Gemini 3 Pro | Gemini 3.1 Pro | Amélioration |

|---|---|---|---|

| Score ARC-AGI-2 | 38,5 % | 77,1 % | +100 % |

| Génération de code | 72 % | 89 % | +24 % |

| Raisonnement abstrait | 65 % | 88 % | +35 % |

| Humanity’s Last Exam | 28 % | 44,4 % | +59 % |

| Temps de réponse moyen | 2,3 s | 4,1 s | -44 % |

Une compétition acharnée qui restructure l’industrie technologique

Le dévoilement de Gemini 3.1 Pro s’inscrit dans une dynamique concurrentielle sans précédent. OpenAI, Anthropic et d’autres acteurs majeurs multiplient les annonces et les lancements de modèles toujours plus performants. Cette rivalité stimule l’innovation, mais elle engendre également une frénésie de développement qui défie les rythmes traditionnels de l’industrie logicielle.

Les observateurs du secteur notent qu’OpenAI prépare déjà ChatGPT-5.3, dont des traces visuelles apparaissent sur les maquettes du site officiel. Cette réactivité illustre la volonté de chaque entreprise de maintenir sa position sur le podium des modèles d’IA les plus avancés. La compétition ne porte plus seulement sur les performances brutes, mais également sur la vitesse de déploiement et la capacité à anticiper les besoins émergents du marché.

Cette course effrénée entraîne des répercussions majeures sur l’ensemble de l’écosystème technologique. Les fabricants de puces spécialisées comme NVIDIA connaissent une demande explosive pour leurs accélérateurs de calcul. Les prix des composants flambent, créant une inflation sans précédent sur le marché des serveurs et des infrastructures cloud. Les entreprises doivent jongler entre l’urgence de déployer des solutions IA compétitives et la contrainte budgétaire imposée par cette escalade des coûts matériels.

Le développement rapide de modèles comme Gemini 3.1 Pro nécessite également la construction accélérée de nouveaux centres de données. Ces infrastructures colossales surgissent aux quatre coins du globe, concentrant des milliers de serveurs dans des bâtiments climatisés fonctionnant en permanence. Chaque centre représente un investissement de plusieurs centaines de millions d’euros et consomme autant d’électricité qu’une petite ville.

Les implications économiques d’une technologie en quête de rentabilité

Malgré les performances éblouissantes et l’engouement médiatique, l’intelligence artificielle générative n’a toujours pas démontré sa capacité à générer des bénéfices substantiels pour ses promoteurs. Les coûts d’entraînement, d’infrastructure et d’exploitation des modèles restent astronomiques, tandis que les revenus générés par les abonnements et les licences API peinent à compenser ces dépenses.

Les analystes financiers scrutent avec attention les rapports trimestriels de Google, OpenAI et leurs concurrents. La question de la viabilité économique à long terme plane sur l’ensemble du secteur. Combien de temps ces entreprises pourront-elles investir des milliards dans la recherche et le développement sans atteindre un seuil de rentabilité significatif ? Cette interrogation alimente les débats stratégiques au sein des conseils d’administration et influence les décisions d’allocation des ressources.

Certains experts estiment que la véritable monétisation de l’IA passera par des applications verticales spécialisées plutôt que par des modèles généralistes. Un modèle adapté aux besoins spécifiques de la finance, de la santé ou de la logistique pourrait justifier des tarifs premium et générer des marges confortables. Cette hypothèse explique pourquoi de nombreuses entreprises développent des versions affinées de Gemini 3.1 Pro pour des secteurs d’activité précis.

- Coûts d’entraînement : plusieurs dizaines de millions d’euros par modèle pour les cycles de calcul intensif

- Infrastructure matérielle : investissements massifs dans les centres de données et les équipements de refroidissement

- Consommation énergétique : factures d’électricité atteignant plusieurs millions d’euros par mois pour les fermes de serveurs

- Équipes de recherche : salaires élevés des ingénieurs spécialisés en machine learning et des data scientists

- Licences de données : coûts d’acquisition des corpus de textes nécessaires au préentraînement

Les conséquences environnementales et sanitaires d’une expansion technologique débridée

L’essor fulgurant de l’intelligence artificielle s’accompagne de préoccupations croissantes concernant son impact environnemental et sanitaire. La multiplication des centres de données dédiés à l’entraînement et au déploiement de modèles comme Gemini 3.1 Pro génère une empreinte écologique considérable qui commence à inquiéter les autorités réglementaires et les organisations environnementales.

Ces infrastructures consomment des quantités phénoménales d’électricité, principalement pour alimenter les serveurs et maintenir les systèmes de climatisation indispensables au bon fonctionnement des équipements. Une étude récente estime que l’entraînement d’un seul modèle d’IA avancé peut émettre autant de CO2 que cinq voitures pendant toute leur durée de vie. Lorsque l’on multiplie ce chiffre par le nombre croissant de modèles développés chaque année, l’impact climatique devient vertigineux.

Au-delà de la consommation énergétique, les nuisances sonores générées par ces installations soulèvent des interrogations sanitaires préoccupantes. Le vidéaste Benn Jordan a publié cette semaine une enquête documentée sur les émissions d’infrasons produites par le vrombissement constant des serveurs. Ces fréquences basses, imperceptibles à l’oreille humaine consciente, traversent les murs et se propagent sur de longues distances.

Les recherches mentionnées dans cette investigation révèlent des effets physiologiques mesurables sur les populations vivant à proximité des centres de données. Les infrasons agissent sur la production de cortisol, l’hormone du stress, entraînant des symptômes d’anxiété chronique chez les riverains. Certaines personnes rapportent également des pertes auditives progressives, des nausées récurrentes et, dans les cas les plus graves, des arythmies cardiaques nécessitant un suivi médical.

La nécessité d’un cadre réglementaire adapté aux enjeux contemporains

Face à ces constats alarmants, plusieurs juridictions envisagent l’adoption de réglementations strictes encadrant la construction et l’exploitation des centres de données. L’Union européenne travaille actuellement sur une directive spécifique qui imposerait des normes acoustiques contraignantes et des obligations de compensation carbone pour les opérateurs d’infrastructures IA.

Ces initiatives réglementaires visent à établir un équilibre entre l’innovation technologique et la protection des populations et de l’environnement. Les projets de textes prévoient des distances minimales entre les centres de données et les zones d’habitation, ainsi que des dispositifs d’isolation acoustique performants pour limiter la propagation des nuisances sonores. Les entreprises devront également financer des études d’impact sanitaire avant l’autorisation de toute nouvelle installation.

Certains géants de la technologie anticipent ces contraintes en investissant dans des solutions alternatives. Google explore notamment des architectures de calcul distribué qui répartiraient la charge de traitement sur de multiples petites installations plutôt que de concentrer les ressources dans des méga-centres. Cette approche pourrait atténuer l’impact local tout en maintenant les capacités de calcul nécessaires au développement de modèles avancés comme Gemini 3.1 Pro.

La transition énergétique constitue un autre axe d’amélioration prioritaire. Les principaux acteurs du secteur s’engagent progressivement à alimenter leurs installations avec des sources d’énergie renouvelables. Panneaux solaires, éoliennes et hydroélectricité sont progressivement intégrés aux infrastructures existantes, même si la quantité d’électricité nécessaire reste colossale. L’objectif de neutralité carbone fixé par plusieurs entreprises pour la fin de la décennie semble ambitieux au regard de la croissance exponentielle des besoins en calcul.

Les perspectives d’évolution et les prochaines étapes de l’innovation en intelligence artificielle

L’arrivée de Gemini 3.1 Pro marque une étape significative, mais elle ne représente qu’un jalon supplémentaire dans une progression qui semble ne jamais devoir s’arrêter. Les feuilles de route des laboratoires de recherche laissent entrevoir des développements encore plus ambitieux pour les mois et années à venir. La question qui agite la communauté scientifique n’est plus de savoir si les IA atteindront des capacités de raisonnement comparables à celles des humains, mais plutôt quand et sous quelle forme.

Les chercheurs explorent actuellement plusieurs pistes prometteuses pour transcender les limitations actuelles des modèles de langage. L’intégration multimodale, permettant aux systèmes de traiter simultanément texte, images, sons et vidéos, ouvre des perspectives fascinantes. Un futur Gemini 4 pourrait analyser une scène filmée, comprendre les interactions sociales, interpréter les émotions des protagonistes et générer une narration contextuelle pertinente, le tout en temps réel.

L’apprentissage par renforcement avec retour humain constitue une autre voie d’amélioration cruciale. Cette technique permet d’affiner les réponses du modèle en intégrant des évaluations qualitatives fournies par des annotateurs humains. En exposant le système à des milliers de corrections et de préférences, les développeurs l’orientent progressivement vers un comportement plus aligné avec les attentes et les valeurs humaines. Cette approche contribue à réduire les hallucinations et les biais problématiques qui affectent encore les modèles actuels.

La réduction de la consommation énergétique figure également parmi les priorités de recherche. Les architectures de transformeurs actuelles, bien que puissantes, restent extrêmement gourmandes en ressources de calcul. Des équipes travaillent sur des designs neuronaux inspirés du fonctionnement du cerveau humain, capable de traiter l’information de manière beaucoup plus efficiente. Ces réseaux neuronaux de nouvelle génération pourraient accomplir des tâches complexes tout en consommant une fraction de l’énergie actuellement nécessaire.

Du côté de Google, les équipes préparent déjà les bases de modèles capables d’apprentissage continu. Contrairement aux systèmes actuels qui nécessitent des cycles de réentraînement complets pour intégrer de nouvelles connaissances, ces futures IA mettraient à jour leurs paramètres de manière incrémentale et dynamique. Cette capacité d’adaptation permanente permettrait aux modèles de rester pertinents face à l’évolution constante des connaissances humaines sans nécessiter les investissements massifs associés aux réentraînements traditionnels.

L’émergence d’écosystèmes applicatifs spécialisés

Au-delà des améliorations techniques des modèles fondamentaux, l’industrie assiste à la prolifération d’applications verticales exploitant les capacités de Gemini 3.1 Pro et de ses concurrents. Des entreprises de tous secteurs développent des solutions métier qui intègrent ces intelligences artificielles pour résoudre des problèmes spécifiques avec une précision accrue.

Dans le domaine médical, des systèmes d’aide au diagnostic s’appuient sur les capacités de raisonnement avancées pour analyser des dossiers patients complexes, croiser les symptômes avec des bases de données médicales exhaustives et suggérer des pistes diagnostiques aux praticiens. Ces outils n’ont pas vocation à remplacer l’expertise humaine, mais plutôt à l’augmenter en offrant une seconde opinion informée et en signalant des corrélations que le clinicien aurait pu manquer.

Le secteur juridique connaît également une transformation profonde grâce à l’IA avancée. Les cabinets d’avocats déploient des assistants capables d’analyser des milliers de pages de jurisprudence, d’identifier les précédents pertinents et de préparer des argumentaires solides en une fraction du temps auparavant nécessaire. Cette automatisation des tâches de recherche permet aux juristes de se concentrer sur la stratégie et le conseil à haute valeur ajoutée.

L’éducation représente un autre domaine prometteur pour les applications de l’IA générative. Des tuteurs personnalisés adaptatifs utilisent les capacités de Gemini 3.1 Pro pour comprendre le style d’apprentissage de chaque élève, identifier ses difficultés spécifiques et proposer des exercices ciblés. Cette approche pédagogique individualisée, autrefois réservée aux élèves disposant d’un précepteur privé, devient accessible au plus grand nombre grâce à l’échelle permise par la technologie.

Le développement de ces écosystèmes applicatifs contribue progressivement à la monétisation de l’intelligence artificielle. Les entreprises se montrent disposées à payer des tarifs premium pour des solutions qui génèrent des gains de productivité mesurables ou qui ouvrent de nouvelles opportunités commerciales. Cette dynamique économique pourrait finalement résoudre l’équation de la rentabilité qui préoccupe tant les investisseurs du secteur.

Quelle est la différence principale entre Gemini 3.1 Pro et les versions précédentes ?

Gemini 3.1 Pro se distingue par ses capacités de raisonnement avancées, doublant les scores de son prédécesseur sur les benchmarks clés comme ARC-AGI-2 où il atteint 77,1%. Il excelle particulièrement en programmation et dans les tâches agentiques autonomes, prenant parfois plusieurs secondes pour analyser et croiser les sources avant de répondre, contrairement aux versions plus rapides mais moins approfondies comme Gemini 3.0 Flash destinées aux usages quotidiens.

Gemini 3.1 Pro est-il accessible à tous les utilisateurs ?

Non, Gemini 3.1 Pro est actuellement disponible en version d’aperçu exclusivement pour les abonnés aux formules Google AI Pro et Google AI Ultra. Ce modèle de raisonnement avancé cible principalement les professionnels ayant besoin de traiter des demandes complexes en programmation, analyse de données ou tâches nécessitant une réflexion approfondie, plutôt que le grand public pour qui les versions standard restent amplement suffisantes.

Quels sont les impacts environnementaux liés au développement de Gemini 3.1 Pro ?

Le développement et l’exploitation de Gemini 3.1 Pro nécessitent des centres de données massifs consommant des quantités phénoménales d’électricité pour le calcul et la climatisation. L’entraînement d’un modèle d’IA avancé peut émettre autant de CO2 que cinq voitures pendant leur durée de vie complète. Les installations génèrent également des nuisances sonores, notamment des infrasons affectant la santé des populations environnantes avec des symptômes d’anxiété, pertes auditives et arythmies cardiaques dans les cas graves.

Comment Gemini 3.1 Pro se compare-t-il à GPT-5.2 et Claude Opus 4.6 ?

Gemini 3.1 Pro surpasse Claude Opus 4.6 et GPT-5.2 sur la majorité des benchmarks de référence, notamment en raisonnement abstrait avec 77,1% sur ARC-AGI-2 et 44,4% sur Humanity’s Last Exam. Il démontre des capacités supérieures en génération de code atteignant 89% contre environ 72% pour son prédécesseur, et excelle particulièrement dans les tâches agentiques autonomes nécessitant planification et exécution de séquences d’actions complexes.

L’intelligence artificielle générative est-elle rentable pour les entreprises qui l’exploitent ?

Malgré les performances impressionnantes et l’engouement médiatique, l’IA générative n’a toujours pas démontré sa capacité à générer des bénéfices substantiels pour ses promoteurs. Les coûts d’entraînement, d’infrastructure et d’exploitation restent astronomiques avec des investissements de centaines de millions d’euros par centre de données et des factures d’électricité mensuelles se chiffrant en millions, tandis que les revenus des abonnements et licences API peinent à compenser ces dépenses massives.