Google et Gemini : une mobilisation industrielle pour réinventer la course technologique

La compétition mondiale autour de l’intelligence artificielle générative ressemble désormais à un marathon où chaque acteur espère trouver son second souffle. Le phénomène ChatGPT a provoqué un électrochoc dans l’industrie technologique, déclenchant une véritable course à l’armement entre géants du numérique. Pendant plusieurs mois, le constat semblait implacable : OpenAI avait pris une longueur d’avance spectaculaire, laissant les autres acteurs dans une position délicate. Mais aujourd’hui, le vent tourne progressivement.

Google mobilise ses ressources colossales pour imposer Gemini comme une alternative crédible, voire supérieure. Cette stratégie ne repose pas uniquement sur la performance brute des modèles d’apprentissage automatique, mais sur une approche globale combinant innovation technique, déploiement massif et intégration profonde dans l’écosystème existant. L’évolution de Gemini sur Google Trends témoigne de cette montée en puissance progressive, reflétant un intérêt grandissant du public et des professionnels.

Les mouvements stratégiques de Google révèlent une détermination sans faille. La firme de Mountain View ne se contente pas de rattraper son retard : elle déploie une vision industrielle articulée autour de plusieurs piliers. D’abord, l’intégration native dans les services existants, depuis la recherche jusqu’aux outils collaboratifs. Ensuite, la puissance de calcul, avec des investissements massifs dans les infrastructures de machine learning. Enfin, la distribution massive, exploitant la base d’utilisateurs de l’écosystème Google pour créer un effet de réseau.

| Axe stratégique | Caractéristiques | Impact attendu |

|---|---|---|

| Intégration écosystème | Déploiement dans Gmail, Docs, Search | Adoption naturelle par milliards d’utilisateurs |

| Infrastructure matérielle | Data centers spécialisés, TPU nouvelle génération | Performances accrues, coûts optimisés |

| Alliance commerciale | Partenariats B2B et cloud | Revenus récurrents, fidélisation entreprise |

| Recherche fondamentale | Laboratoires DeepMind, publications académiques | Crédibilité scientifique, recrutement talents |

Ce retour en force ne s’improvise pas. Google s’appuie sur une décennie de recherches en apprentissage automatique, notamment grâce aux travaux fondateurs de DeepMind. La technologie Transformer, pierre angulaire des modèles génératifs actuels, a été développée par des chercheurs de Google en 2017. Cette antériorité technique constitue un atout considérable, même si l’entreprise a semblé surprise par la rapidité avec laquelle OpenAI a commercialisé ChatGPT.

- Expertise scientifique : équipes de chercheurs parmi les plus réputées au monde

- Ressources financières : capacité d’investissement quasi illimitée dans les infrastructures

- Données d’entraînement : accès privilégié à des volumes massifs de contenus web

- Distribution globale : présence sur des milliards d’appareils à travers le monde

- Culture d’innovation : historique de projets ambitieux et disruptifs

L’annonce récente de restructurations internes souligne l’importance accordée à Gemini. Sundar Pichai, PDG de Google, a clairement affiché l’ambition : positionner ce modèle comme leader incontesté du secteur. Cette détermination se traduit par des décisions organisationnelles audacieuses, notamment le retour de Sergey Brin dans les équipes de développement, signal fort envoyé à l’industrie sur le caractère prioritaire de cette bataille technologique.

La reconfiguration stratégique des équipes internes

La direction de Google a opéré plusieurs remaniements significatifs pour accélérer le développement de Gemini. Ces changements ne sont pas anodins : ils traduisent une volonté de casser les silos organisationnels et de mobiliser l’ensemble des talents sur un objectif commun. Les équipes de Google Brain et DeepMind, autrefois distinctes, collaborent désormais étroitement pour maximiser les synergies.

Cette réorganisation s’accompagne d’un recrutement agressif. À l’instar de Meta l’été dernier, Google lance un mercato à prix d’or, attirant les meilleurs profils de l’industrie. Chercheurs spécialisés en traitement du langage naturel, ingénieurs en optimisation de modèles, experts en éthique de l’IA : tous les profils stratégiques sont courtisés. Cette concentration de talents vise à créer une dynamique d’innovation capable de produire des avancées régulières et spectaculaires.

Pourtant, l’histoire récente montre qu’une accumulation de talents ne garantit pas le succès. Les investisseurs ont rappelé cette réalité à Meta après l’emballement initial autour de sa dream team. La stratégie de Sundar Pichai semble donc plus nuancée : combiner excellence technique et exécution commerciale rigoureuse, évitant ainsi l’écueil d’une approche purement scientifique déconnectée des besoins utilisateurs.

L’architecture technique de Gemini : innovation et performances au service de l’ambition

Derrière l’interface utilisateur de Gemini se cache une architecture technique sophistiquée, fruit de plusieurs années de recherche en machine learning. Google a conçu ce modèle pour exceller dans plusieurs dimensions simultanément : compréhension du langage naturel, génération de contenus multimodaux, raisonnement logique et contextualisation avancée. Cette polyvalence constitue un avantage compétitif majeur face à des modèles plus spécialisés.

L’approche multimodale représente une rupture importante. Contrairement aux premières générations de modèles génératifs, Gemini traite nativement texte, images, audio et vidéo. Cette capacité ouvre des perspectives considérables pour les applications professionnelles : analyse automatique de documents complexes, génération de présentations enrichies, assistance conversationnelle contextuelle. Les avancées de Google en intelligence artificielle permettent désormais d’imaginer des usages auparavant inaccessibles.

| Fonctionnalité | Description technique | Cas d’usage |

|---|---|---|

| Traitement multimodal | Analyse simultanée texte, image, audio | Analyse documents scannés, transcription enrichie |

| Contextualisation longue | Fenêtre de contexte étendue | Synthèse de rapports longs, continuité conversationnelle |

| Raisonnement logique | Chaînes de pensée structurées | Résolution problèmes mathématiques, programmation |

| Personnalisation adaptative | Apprentissage des préférences utilisateur | Assistance personnalisée, suggestions pertinentes |

L’optimisation des performances constitue un défi permanent. Les modèles d’intelligence artificielle générative consomment des ressources considérables, tant en phase d’entraînement qu’en inférence. Google investit massivement dans des TPU (Tensor Processing Units) spécialement conçues pour ces charges de travail. Cette maîtrise verticale de la chaîne technologique procure un avantage économique significatif, permettant de réduire les coûts tout en améliorant les performances.

- Entraînement distribué : utilisation de milliers de processeurs en parallèle

- Compression de modèles : techniques avancées pour réduire la taille sans perte de qualité

- Optimisation énergétique : réduction de l’empreinte carbone des infrastructures

- Cache intelligent : mémorisation des requêtes fréquentes pour accélérer les réponses

- Mise à jour continue : amélioration progressive sans interruption de service

La sécurité et l’éthique occupent une place centrale dans la conception de Gemini. Google a intégré dès la phase de développement des mécanismes de détection des biais, de filtrage des contenus problématiques et de traçabilité des décisions. Ces précautions répondent aux préoccupations croissantes des régulateurs et de la société civile concernant les risques associés aux systèmes d’IA puissants. L’utilisation éthique de l’intelligence artificielle devient un enjeu différenciant majeur dans cette compétition.

Les innovations algorithmiques qui distinguent Gemini

Au-delà de la puissance brute de calcul, Gemini intègre plusieurs innovations algorithmiques issues des laboratoires de recherche de Google. L’une des plus significatives concerne l’apprentissage par renforcement avec retour humain, technique permettant d’affiner progressivement les réponses du modèle selon les préférences des utilisateurs. Cette approche itérative améliore constamment la pertinence et la qualité des contenus générés.

Une autre avancée notable porte sur la gestion de la mémoire contextuelle. Gemini peut maintenir une cohérence conversationnelle sur de très longues interactions, mémorisant les éléments clés des échanges précédents. Cette capacité transforme l’expérience utilisateur, permettant des conversations réellement suivies où l’IA comprend les références implicites et maintient le fil conducteur.

Les chercheurs de Google ont également développé des techniques de raisonnement explicite, où le modèle décompose les problèmes complexes en étapes intermédiaires. Cette transparence améliore la fiabilité des réponses, particulièrement dans les domaines nécessitant rigueur et précision comme les mathématiques ou la programmation. La création artistique assistée par intelligence artificielle bénéficie également de ces avancées, permettant un contrôle plus fin sur le processus créatif.

L’intégration écosystémique : transformer les services Google en plateforme d’intelligence artificielle

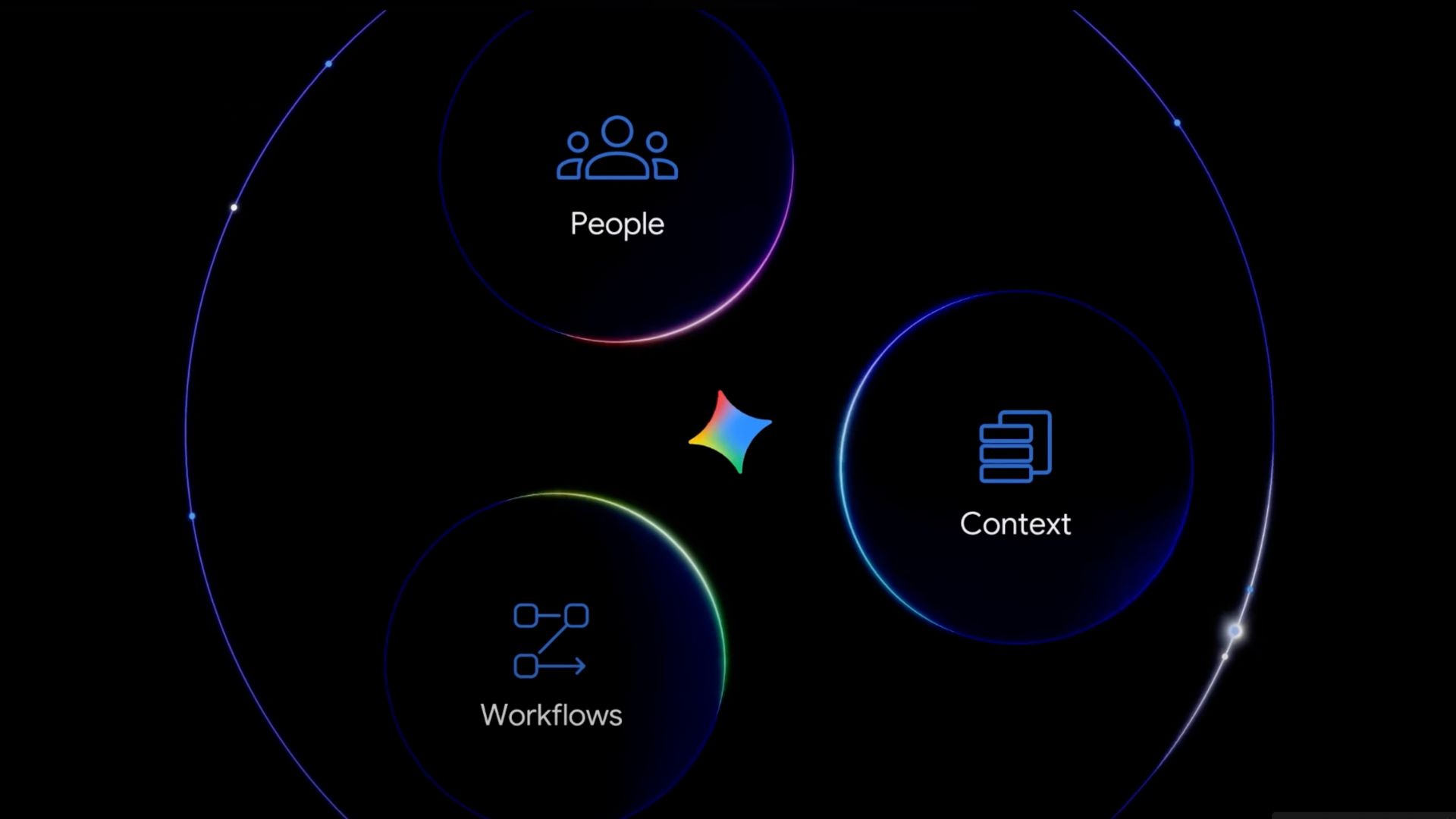

La véritable force de Google réside dans sa capacité à déployer Gemini à travers son écosystème tentaculaire. Plutôt que de proposer une application isolée, la stratégie consiste à infuser l’intelligence artificielle dans chaque service existant. Gmail, Google Docs, Sheets, Meet, Photos : tous ces outils familiers deviennent progressivement des interfaces d’accès à Gemini, créant une expérience fluide et naturelle.

Cette approche présente plusieurs avantages décisifs. D’abord, elle élimine les frictions d’adoption : les utilisateurs n’ont pas besoin d’apprendre un nouvel outil ou de changer leurs habitudes. L’IA s’intègre discrètement dans leurs workflows quotidiens, apportant une valeur ajoutée immédiate. Ensuite, elle génère un effet de réseau puissant : plus les utilisateurs interagissent avec Gemini à travers différents services, plus le système comprend leurs besoins spécifiques et personnalise ses réponses.

| Service Google | Fonctionnalités Gemini intégrées | Bénéfices utilisateur |

|---|---|---|

| Gmail | Rédaction assistée, synthèse emails, réponses suggérées | Gain de temps, amélioration communication |

| Google Docs | Génération contenu, réécriture, mise en forme | Productivité accrue, qualité rédactionnelle |

| Google Search | Réponses conversationnelles, synthèse résultats | Recherche plus intuitive, réponses directes |

| Google Photos | Recherche sémantique, montage automatique | Organisation simplifiée, créativité facilitée |

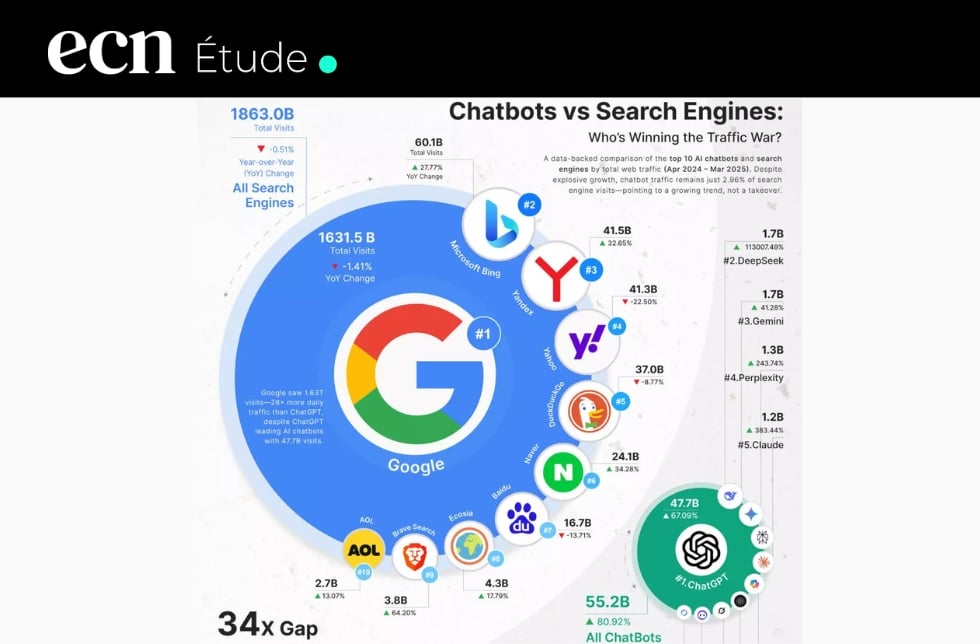

Le déploiement dans Google Search représente l’enjeu le plus stratégique. Le moteur de recherche, cœur historique de l’entreprise, évolue progressivement vers une expérience conversationnelle. Les utilisateurs peuvent désormais poser des questions complexes en langage naturel et obtenir des réponses synthétiques plutôt qu’une liste de liens. L’impact de ChatGPT sur la publicité Google a précipité cette transformation, forçant l’entreprise à repenser son modèle économique historique.

- Recherche conversationnelle : questions de suivi sans répéter le contexte

- Synthèse multi-sources : compilation intelligente d’informations provenant de plusieurs sites

- Suggestions proactives : anticipation des besoins utilisateur selon le contexte

- Vérification factuelle : croisement automatique des sources pour valider l’information

- Personnalisation poussée : adaptation des réponses selon l’historique et les préférences

Cette intégration soulève néanmoins des questions importantes. Les éditeurs de contenus s’inquiètent légitimement de l’impact sur leur trafic : si Google fournit directement les réponses, pourquoi les internautes cliqueraient-ils vers les sites sources ? Les tensions avec les éditeurs italiens illustrent ces préoccupations. Google tente de trouver un équilibre, affichant des citations et des liens vers les sources, mais la tension persiste.

L’intégration dans les outils professionnels représente un autre axe majeur. Google Workspace, concurrent direct de Microsoft 365, devient une suite bureautique augmentée par l’intelligence artificielle. Rédaction collaborative assistée, analyse automatique de données dans Sheets, transcription enrichie des visioconférences Meet : chaque fonctionnalité vise à améliorer la productivité et à justifier les abonnements premium. Les formations Google dédiées à l’IA accompagnent cette transition, permettant aux professionnels de maîtriser ces nouveaux outils.

La stratégie mobile et l’intégration dans Android

Les smartphones représentent un terrain de bataille crucial. Google dispose d’un avantage considérable avec Android, système d’exploitation équipant près de 70% des terminaux mobiles mondiaux. L’intégration native de Gemini dans Android offre des possibilités considérables : assistant vocal enrichi, automatisation contextuelle, interaction multimodale via caméra et micro.

Cette présence mobile transforme Gemini en compagnon quotidien omniprésent. Identification visuelle d’objets, traduction instantanée, aide à la navigation, suggestions contextuelles selon la localisation : les cas d’usage se multiplient. L’intégration dans Android Auto étend ces capacités à l’automobile, domaine stratégique où la compétition s’intensifie également.

Apple, concurrent direct sur le segment premium, développe ses propres capacités d’IA. La rivalité Apple-Google-Microsoft structure désormais toute l’industrie technologique. Chaque acteur cherche à créer un écosystème fermé où son IA constitue la couche d’intelligence unifiante. Cette fragmentation inquiète certains observateurs, qui craignent une balkanisation de l’expérience utilisateur selon les plateformes.

Les alliances stratégiques et le repositionnement concurrentiel face à Microsoft et OpenAI

La compétition autour de l’intelligence artificielle générative ne se limite pas à une rivalité technique. Elle implique des alliances complexes, des partenariats industriels et des stratégies d’influence auprès des régulateurs. Microsoft a ouvert la voie en investissant massivement dans OpenAI, obtenant ainsi un accès privilégié à ChatGPT et intégrant cette technologie dans ses produits phares comme Office et Bing.

Cette alliance Microsoft-OpenAI a créé un choc dans l’industrie. Pendant plusieurs mois, le duo semblait imbattable, combinant l’excellence scientifique d’OpenAI et la puissance commerciale de Microsoft. Les parts de marché de Bing ont légèrement progressé, même si Google Search conserve une position largement dominante. Plus significativement, Microsoft a réussi à moderniser l’image de ses produits, autrefois perçus comme vieillissants.

| Acteur | Modèle IA principal | Avantages stratégiques | Points de vigilance |

|---|---|---|---|

| Gemini | Écosystème, infrastructure, recherche | Perception de retard, régulation | |

| Microsoft-OpenAI | GPT-4 | Avance commerciale, intégration Office | Coûts élevés, dépendance partenariat |

| Meta | Llama | Open source, communauté développeurs | Monétisation incertaine, ressources |

| Anthropic | Claude | Sécurité, éthique, qualité réponses | Échelle limitée, notoriété |

Face à cette menace, Google a dû repenser sa stratégie d’alliances. L’entreprise multiplie les partenariats avec des acteurs complémentaires : éditeurs de logiciels professionnels, fabricants de terminaux, opérateurs télécoms. L’objectif : créer un réseau de distribution aussi puissant que celui de Microsoft, voire le dépasser grâce à la présence mobile d’Android. Les accords avec des géants du divertissement comme Disney illustrent cette volonté d’étendre l’influence de Gemini à de nouveaux secteurs.

- Partenariats cloud : intégration Gemini dans Google Cloud Platform pour clients B2B

- Alliances hardware : collaboration avec Samsung, Xiaomi pour intégration native

- Accords contenu : licences avec éditeurs pour enrichir données d’entraînement

- Coopérations académiques : financement recherche universitaire, bourses doctorales

- Initiatives open source : publication modèles légers pour créer dynamique communautaire

La montée en puissance de Meta constitue un autre élément perturbateur. Avec sa stratégie open source pour Llama, Mark Zuckerberg cherche à créer un écosystème parallèle où les développeurs peuvent accéder librement aux modèles. Cette approche radicalement différente séduit une partie de la communauté technique, inquiète de la concentration du pouvoir entre quelques acteurs. Google doit composer avec cette dynamique, publiant certains modèles légers tout en conservant Gemini comme atout propriétaire.

Les acteurs chinois, notamment avec le phénomène DeepSeek, rappellent que la compétition se joue également sur le plan géopolitique. Ces modèles performants développés avec des ressources supposément limitées ont semé le doute sur les stratégies occidentales massives. Google, comme ses concurrents américains, doit désormais intégrer cette dimension internationale dans sa réflexion stratégique. Les tensions commerciales et les restrictions sur les semi-conducteurs complexifient encore davantage l’équation.

L’enjeu réglementaire et la navigation dans un environnement juridique incertain

La régulation de l’intelligence artificielle évolue rapidement, créant un contexte d’incertitude pour tous les acteurs. L’Union européenne a adopté l’AI Act, première législation complète sur le sujet. Les États-Unis multiplient les initiatives au niveau fédéral et des États. La Chine impose ses propres règles strictes. Google doit naviguer dans ce patchwork réglementaire complexe, adaptant Gemini selon les juridictions.

Cette complexité génère des coûts significatifs mais offre aussi des opportunités. Les entreprises capables de démontrer leur conformité et leur approche responsable de l’IA gagnent un avantage concurrentiel, particulièrement auprès des clients institutionnels et des grandes entreprises sensibles aux risques juridiques. Les contentieux juridiques autour de l’IA se multiplient, rendant la prudence indispensable.

Google investit massivement dans les relations avec les régulateurs et les décideurs politiques. Lobbying, participation aux consultations publiques, financement de recherches sur la gouvernance de l’IA : tous les leviers sont actionnés pour influencer favorablement l’évolution du cadre légal. Cette diplomatie technologique devient aussi stratégique que le développement technique lui-même. Les autorisations obtenues pour certains algorithmes témoignent de ces efforts soutenus.

Les infrastructures matérielles et la course aux ressources de calcul pour soutenir l’innovation

Derrière la sophistication logicielle de Gemini se cache une infrastructure matérielle colossale. Les modèles d’intelligence artificielle générative exigent des ressources de calcul considérables, tant pour l’entraînement initial que pour l’inférence en temps réel. Google a construit au fil des années un réseau mondial de data centers parmi les plus puissants et efficaces de la planète.

L’investissement dans les infrastructures atteint des montants vertigineux. L’annonce de 40 milliards de dollars pour des data centers au Texas illustre l’ampleur des engagements financiers. Ces installations ultra-modernes intègrent les dernières générations de processeurs spécialisés, des systèmes de refroidissement innovants et des sources d’énergie renouvelable pour limiter l’empreinte environnementale.

| Composant infrastructure | Spécifications | Objectif |

|---|---|---|

| TPU v5 | Processeurs tensoriels optimisés IA | Accélération entraînement et inférence |

| Réseau haute vitesse | Interconnexions ultra-rapides entre serveurs | Distribution calcul parallèle |

| Stockage distribué | Systèmes pétaoctets résilients | Conservation datasets massifs |

| Alimentation électrique | Contrats énergies renouvelables long terme | Réduction impact carbone |

La maîtrise verticale de la chaîne technologique constitue un avantage compétitif majeur. Contrairement à des acteurs dépendant de fournisseurs externes, Google conçoit ses propres puces spécialisées, les TPU (Tensor Processing Units). Cette intégration verticale permet d’optimiser finement l’architecture matérielle pour les algorithmes de machine learning, améliorant performances et efficacité énergétique simultanément.

- Conception hardware propriétaire : contrôle complet architecture matérielle

- Optimisation logiciel-matériel : co-design pour performances maximales

- Évolutivité infrastructure : capacité d’expansion rapide selon besoins

- Redondance géographique : répartition mondiale pour fiabilité et latence

- Innovation énergétique : techniques avancées de gestion thermique

L’efficacité énergétique devient un enjeu stratégique autant qu’éthique. Les modèles d’IA générative consomment des quantités d’électricité considérables, soulevant des préoccupations environnementales légitimes. Les discussions autour de la réactivation de centrales nucléaires pour alimenter les data centers illustrent l’ampleur du défi énergétique. Google s’engage publiquement vers la neutralité carbone, mais la croissance exponentielle des besoins complique l’équation.

Les pénuries de semi-conducteurs compliquent encore la situation. Les puces spécialisées pour l’IA sont produites en volumes limités, créant une compétition féroce entre acteurs. NVIDIA domine largement ce marché, position qui lui confère un pouvoir considérable. Les efforts d’OpenAI et Google pour développer leurs propres puces visent à réduire cette dépendance stratégique, mais nécessitent des investissements colossaux et un savoir-faire complexe.

Les défis de scalabilité et d’optimisation des coûts

Déployer Gemini à l’échelle de milliards d’utilisateurs pose des défis techniques redoutables. Chaque requête nécessite des ressources de calcul, et la multiplication des interactions génère une charge exponentielle. Google doit constamment optimiser ses algorithmes pour réduire les coûts d’inférence, sous peine de rendre le modèle économiquement insoutenable.

Plusieurs techniques permettent d’améliorer l’efficacité. La quantization réduit la précision numérique des calculs sans dégrader significativement la qualité des résultats. Le caching intelligent mémorise les réponses aux requêtes fréquentes. La distribution géographique rapproche les serveurs des utilisateurs pour minimiser la latence. Ces optimisations combinées permettent de servir des millions de requêtes simultanées avec des temps de réponse acceptables.

L’équilibre économique reste néanmoins fragile. Les revenus générés par Gemini doivent couvrir les coûts infrastructurels colossaux. Google explore plusieurs modèles de monétisation : abonnements premium, intégration dans services payants existants, licences B2B pour entreprises. Les interrogations sur une potentielle bulle spéculative reflètent les incertitudes sur la soutenabilité économique à long terme de ces investissements massifs.

Les perspectives d’évolution et les prochaines étapes de développement de Gemini

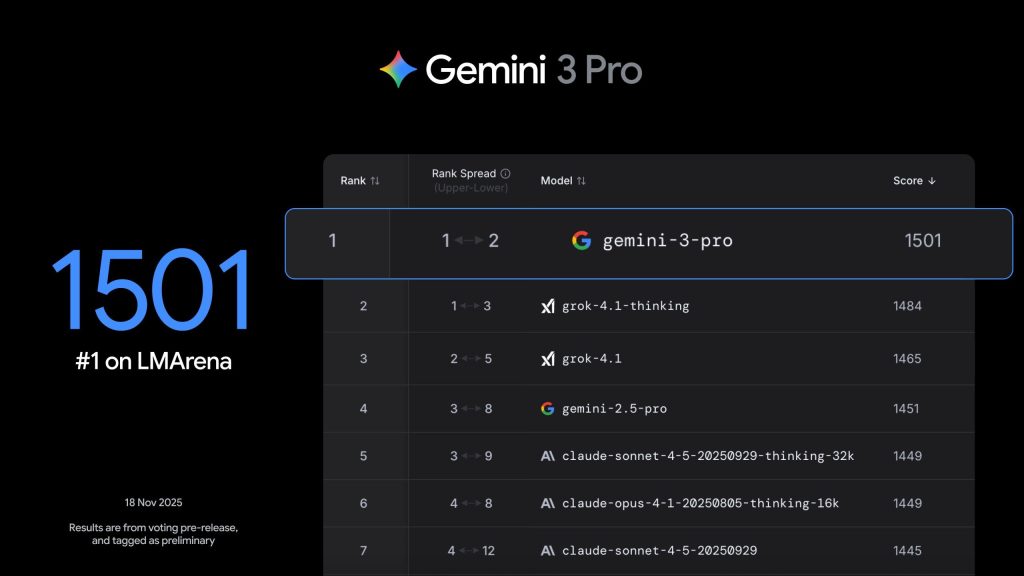

L’intelligence artificielle générative ne constitue qu’une première étape vers des systèmes encore plus sophistiqués. Les chercheurs de Google travaillent déjà sur les prochaines générations de modèles, visant des capacités de raisonnement plus avancées, une compréhension contextuelle plus fine et une autonomie décisionnelle accrue. Gemini 2.0, puis 3.0, promettent des ruptures technologiques significatives.

L’évolution vers une véritable intelligence artificielle générale (AGI) reste l’objectif ultime, même si le calendrier reste très incertain. Une AGI désignerait un système capable de performances comparables à l’intelligence humaine sur l’ensemble des tâches cognitives, pas seulement dans des domaines spécifiques. Cette perspective fascine autant qu’elle inquiète, soulevant des questions philosophiques, éthiques et sociétales profondes.

| Génération | Capacités anticipées | Horizon temporel estimé |

|---|---|---|

| Gemini 2.0 | Raisonnement complexe multi-étapes, autonomie accrue | 2025-2026 |

| Gemini 3.0 | Compréhension contextuelle approfondie, créativité originale | 2027-2028 |

| Gemini 4.0 | Apprentissage continu, adaptation dynamique | 2029-2030 |

| AGI hypothétique | Intelligence générale comparable humain | Incertain, potentiellement décennies |

Les applications futures de Gemini toucheront probablement tous les secteurs économiques. Santé, éducation, finance, industrie, administration publique : chaque domaine pourrait bénéficier d’assistants intelligents spécialisés. L’utilisation de Gemini comme tuteur personnalisé illustre le potentiel éducatif. Les applications pour la surveillance climatique montrent l’intérêt pour les enjeux environnementaux.

- Médecine personnalisée : assistance diagnostic, recommandations thérapeutiques individualisées

- Éducation adaptative : parcours d’apprentissage sur mesure selon profil étudiant

- Recherche scientifique : accélération découvertes par analyse massive littérature

- Gestion urbaine : optimisation trafic, énergie, services publics

- Création artistique : collaboration humain-IA pour productions originales

L’interopérabilité entre systèmes d’IA représente un défi majeur pour l’avenir. Aujourd’hui, chaque acteur développe son écosystème fermé, créant des silos incompatibles. Les utilisateurs doivent jongler entre différentes plateformes, perdant en efficacité. L’émergence de standards communs faciliterait les échanges, mais les intérêts commerciaux freinent cette convergence. Le défi pour les éditeurs de contenu s’inscrit dans cette problématique plus large d’un écosystème fragmenté.

Les questions éthiques accompagneront inévitablement chaque progrès technique. Transparence des algorithmes, protection de la vie privée, gestion des biais, impact sur l’emploi, concentration du pouvoir : ces enjeux exigent un débat démocratique approfondi. Google, comme ses concurrents, devra démontrer sa capacité à développer ces technologies puissantes de manière responsable, sous peine de déclencher des réactions réglementaires sévères ou un rejet social.

L’impact sociétal et la transformation des métiers par l’intelligence artificielle

L’introduction massive de systèmes comme Gemini transformera profondément le monde du travail. Certaines tâches actuellement réalisées par des humains seront automatisées, tandis que de nouveaux métiers émergeront. Cette transition soulève des inquiétudes légitimes sur le chômage technologique, mais l’histoire montre que l’innovation crée généralement autant d’emplois qu’elle en détruit, même si les compétences requises évoluent radicalement.

Les professions intellectuelles, longtemps considérées à l’abri de l’automatisation, sont désormais concernées. Rédacteurs, analystes, programmeurs, graphistes : tous voient leurs métiers évoluer avec l’arrivée d’assistants IA performants. L’enjeu devient la complémentarité humain-machine plutôt que la substitution pure. Les formations proposées par Google visent à préparer cette transition, permettant aux professionnels de maîtriser ces nouveaux outils.

L’éducation doit s’adapter rapidement à cette réalité. Former les nouvelles générations à collaborer efficacement avec l’IA, développer leur esprit critique face aux contenus générés automatiquement, cultiver les compétences spécifiquement humaines comme la créativité, l’empathie et le jugement éthique : telles sont les priorités. Les systèmes éducatifs peinent souvent à suivre le rythme des évolutions technologiques, creusant un fossé préoccupant entre les compétences enseignées et celles requises par le marché du travail.

Au-delà du travail, c’est toute la société qui se transforme. Communication, information, divertissement, relations sociales : chaque dimension de la vie quotidienne est progressivement impactée par l’intelligence artificielle. Les ambitions de Google pour transformer Hollywood illustrent la pénétration de cette technologie dans l’industrie culturelle. Cette omniprésence croissante exige une réflexion collective sur le type de société que nous souhaitons construire avec ces outils puissants.

Quelle est la principale différence entre Gemini et ChatGPT ?

Gemini se distingue par son intégration profonde dans l’écosystème Google, permettant une utilisation naturelle à travers Gmail, Search, Docs et autres services familiers. Techniquement, Gemini excelle particulièrement dans le traitement multimodal natif, analysant simultanément texte, images et audio. ChatGPT conserve néanmoins une avance en termes de notoriété et d’adoption initiale, grâce à son lancement précoce et sa stratégie de communication efficace.

Gemini est-il accessible gratuitement ou nécessite-t-il un abonnement ?

Google propose plusieurs niveaux d’accès à Gemini. Une version gratuite offre des fonctionnalités de base, intégrée notamment dans Google Search et certains services. Pour bénéficier des capacités avancées, des réponses prioritaires et de l’intégration complète dans Workspace, un abonnement payant est nécessaire. Cette stratégie de freemium vise à démocratiser l’accès tout en monétisant les usages professionnels intensifs.

Quels sont les risques éthiques associés à l’utilisation de Gemini ?

Les préoccupations éthiques concernent principalement les biais potentiels dans les réponses, la protection de la confidentialité des données utilisées, la transparence des mécanismes décisionnels et l’impact sur la désinformation. Google affirme intégrer des garde-fous dès la conception, filtrer les contenus problématiques et auditer régulièrement ses systèmes. La vigilance collective reste néanmoins indispensable pour identifier et corriger les dérives éventuelles.

Comment Gemini impacte-t-il le référencement naturel et le trafic des sites web ?

L’intégration de Gemini dans Google Search modifie progressivement les comportements de recherche. Les réponses conversationnelles directes réduisent potentiellement les clics vers les sites sources, inquiétant légitimement les éditeurs de contenu. Google tente d’équilibrer cette équation en citant systématiquement les sources et en maintenant des liens visibles. L’évolution du SEO devra intégrer cette nouvelle réalité, privilégiant contenus de qualité et autorité thématique.

Quelle est la feuille de route de Google pour les prochaines versions de Gemini ?

Google vise des améliorations continues sur plusieurs axes : capacités de raisonnement logique avancé, compréhension contextuelle étendue, personnalisation accrue et intégration encore plus profonde dans l’écosystème. Les versions 2.0 et 3.0 devraient apporter des ruptures significatives, rapprochant progressivement le système d’une véritable intelligence artificielle générale. Le calendrier précis reste confidentiel, mais les observateurs anticipent des annonces majeures dans les prochaines années.