Les annonces spectaculaires de Google dans le domaine quantique

Le géant de la technologie vient de secouer l’univers scientifique avec deux révélations majeures qui propulsent l’informatique quantique vers de nouveaux horizons. La puce Willow et l’algorithme Quantum Echoes représentent des avancées que les spécialistes du secteur attendaient depuis des années. Ces innovations ne surgissent pas du néant : elles résultent d’investissements colossaux et d’une stratégie délibérée visant à positionner Google comme le leader incontesté de cette course technologique.

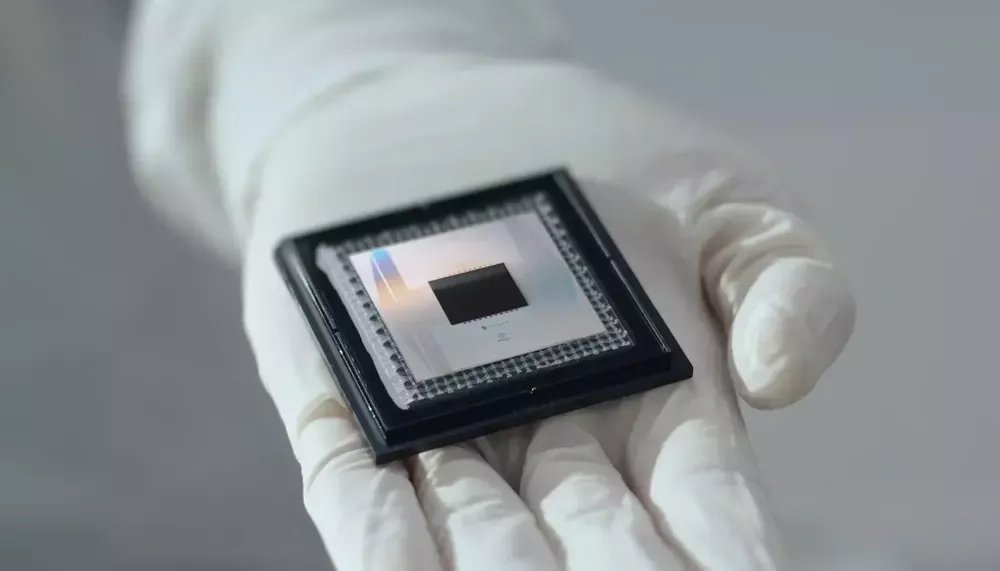

Willow constitue un processeur quantique capable d’exploiter les principes de superposition et d’intrication quantique avec une précision jamais atteinte. Ce dispositif fonctionne avec des qubits arrangés selon une architecture spécifique qui minimise les interférences externes. Les chercheurs ont réussi à maintenir la cohérence quantique suffisamment longtemps pour effectuer des calculs complexes, une prouesse technique qui semblait irréalisable il y a quelques années encore. La conception de cette puce repose sur des matériaux supraconducteurs refroidis à des températures proches du zéro absolu.

Quantum Echoes se présente comme un algorithme révolutionnaire qui exploite la puissance des algorithmes quantiques pour résoudre des problèmes considérés comme insolubles par les systèmes classiques. Cette approche informatique permet d’accélérer certains calculs de manière exponentielle. Les tests réalisés démontrent une rapidité 13 000 fois supérieure aux supercalculateurs traditionnels pour certaines tâches spécifiques. Cette performance spectaculaire attire naturellement l’attention des médias et des investisseurs, créant un enthousiasme parfois démesuré autour du potentiel réel de ces technologies.

Les démonstrations effectuées par Google montrent que ces systèmes peuvent traiter simultanément des millions de possibilités grâce aux propriétés uniques des particules quantiques. Cette capacité ouvre des perspectives fascinantes dans des domaines variés comme la cryptographie, la simulation moléculaire ou l’optimisation logistique. Néanmoins, la distance entre une expérience de laboratoire réussie et un produit commercialement viable reste considérable. Les conditions nécessaires au fonctionnement de ces machines demeurent extrêmement contraignantes et coûteuses.

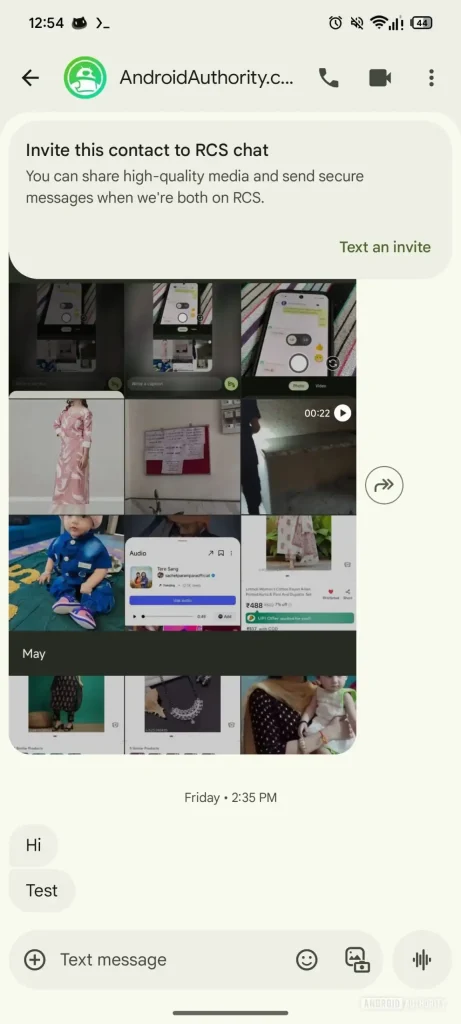

| Innovation | Caractéristique principale | Performance annoncée | Application potentielle |

|---|---|---|---|

| Puce Willow | Processeur quantique supraconducteur | Maintien de cohérence prolongé | Calculs complexes |

| Quantum Echoes | Algorithme quantique avancé | 13 000 fois plus rapide | Résolution de problèmes complexes |

| Système de correction | Réduction des erreurs quantiques | Taux d’erreur divisé par 10 | Fiabilité accrue |

| Architecture modulaire | Évolutivité du système | Passage à 1000 qubits | Expansion future |

Ces annonces s’inscrivent dans une stratégie plus large de Google visant à dominer plusieurs secteurs technologiques simultanément. L’entreprise combine ses recherches en intelligence artificielle avec ses avancées quantiques, créant des synergies potentiellement puissantes. Cette approche multidimensionnelle explique en partie pourquoi les investisseurs manifestent un intérêt croissant pour les projets du géant américain. Les collaborations avec des universités prestigieuses et des centres de recherche renforcent la crédibilité scientifique de ces travaux.

- Développement de qubits supraconducteurs avec durée de vie prolongée

- Création d’algorithmes spécialisés pour exploiter la puissance quantique

- Mise en place de systèmes de refroidissement ultra-performants

- Établissement de partenariats académiques internationaux

- Publication de résultats dans des revues scientifiques à comité de lecture

- Organisation de conférences techniques pour partager les découvertes

La course mondiale vers la suprématie quantique

La compétition internationale dans le domaine quantique s’intensifie avec l’entrée en lice de nombreux acteurs institutionnels et privés. Microsoft a récemment dévoilé Majorana One, une puce reposant sur une approche différente qui pourrait accélérer le développement technologique. IBM poursuit ses propres recherches avec une feuille de route ambitieuse visant à commercialiser des systèmes quantiques accessibles. Les gouvernements chinois et européen investissent massivement dans leurs programmes nationaux, conscients des enjeux stratégiques.

Cette rivalité stimule l’innovation mais génère également une pression considérable sur les équipes de recherche. Les annonces se succèdent à un rythme accéléré, parfois au détriment de la validation approfondie des résultats. Certains observateurs craignent que cette précipitation ne conduise à des promesses exagérées qui pourraient décevoir les attentes du public et des investisseurs. La notion de « suprématie quantique » elle-même fait débat au sein de la communauté scientifique, certains la jugeant prématurée ou marketing.

Les différentes approches technologiques adoptées par les concurrents reflètent des paris scientifiques distincts sur l’architecture optimale. Certains privilégient les qubits topologiques, d’autres les ions piégés ou les photons. Cette diversité constitue un atout pour le progrès global du domaine, car elle permet d’explorer simultanément plusieurs pistes prometteuses. Les échecs d’une méthode peuvent informer et affiner les stratégies alternatives, créant un processus d’apprentissage collectif.

Les défis colossaux de la correction d’erreurs quantiques

La fragilité des qubits représente l’obstacle majeur au déploiement pratique des ordinateurs quantiques. Contrairement aux bits classiques qui maintiennent leur état de manière stable, les qubits subissent constamment des perturbations provenant de leur environnement. Les vibrations thermiques, les champs électromagnétiques parasites et même les rayons cosmiques peuvent provoquer des erreurs de calcul. Cette sensibilité extrême impose des conditions opératoires draconiennes qui compliquent énormément la mise en œuvre concrète.

Les systèmes actuels nécessitent des températures de fonctionnement inférieures à 0,015 kelvin, soit plus froid que l’espace interstellaire. Maintenir de telles conditions requiert des équipements de réfrigération sophistiqués et coûteux. Les cryostats utilisés consomment des quantités importantes d’énergie et demandent une maintenance régulière. Cette contrainte thermique limite drastiquement les environnements où un ordinateur quantique peut opérer, excluant de facto toute utilisation nomade ou décentralisée à court terme.

La décohérence quantique survient lorsque les qubits perdent leurs propriétés quantiques à cause d’interactions avec leur environnement. Ce phénomène s’accélère avec l’augmentation du nombre de qubits, créant un défi d’échelle considérable. Pour construire des machines réellement utiles, il faudrait disposer de milliers voire de millions de qubits fonctionnant de concert. Or, chaque qubit supplémentaire augmente exponentiellement la complexité du système et les sources potentielles d’erreurs.

| Type d’erreur | Origine | Impact sur les calculs | Solution envisagée |

|---|---|---|---|

| Erreur de bit-flip | Interférences électromagnétiques | Inversion de l’état quantique | Codes de correction spécifiques |

| Erreur de phase | Fluctuations thermiques | Perte de cohérence | Isolation thermique renforcée |

| Décohérence | Interaction environnementale | Dégradation progressive | Temps d’opération réduit |

| Erreur de mesure | Imprécision des capteurs | Résultats erronés | Calibration fréquente |

Les techniques de correction d’erreurs quantiques développées par les chercheurs utilisent des qubits redondants pour détecter et corriger les défaillances. Cette approche consomme une proportion importante des ressources disponibles. Pour chaque qubit logique fonctionnel, des dizaines voire des centaines de qubits physiques servent uniquement à la correction. Ce ratio défavorable explique pourquoi les machines actuelles, bien qu’impressionnantes techniquement, restent limitées dans leurs applications pratiques.

- Implémentation de codes de correction topologiques pour protéger l’information

- Développement de qubits plus robustes avec des temps de cohérence prolongés

- Optimisation des circuits quantiques pour minimiser la profondeur des calculs

- Création de nouveaux matériaux moins sensibles aux perturbations externes

- Mise au point de protocoles de vérification en temps réel des états quantiques

- Conception d’architectures hybrides combinant approches classiques et quantiques

Les contraintes matérielles et énergétiques

La construction d’un système quantique fonctionnel exige des composants de précision extrême. Les circuits doivent être fabriqués avec des tolérances de l’ordre du nanomètre, ce qui représente un défi manufacturier considérable. Les techniques de lithographie utilisées s’approchent des limites physiques des procédés actuels. Chaque imperfection microscopique dans la structure peut compromettre les performances de l’ensemble du système. Les taux de rebut lors de la production restent élevés, ce qui explique en partie les coûts prohibitifs.

L’alimentation énergétique constitue un autre point critique. Les systèmes de refroidissement cryogénique consomment des dizaines de kilowatts en permanence. À cela s’ajoutent les besoins des équipements électroniques de contrôle et de mesure. L’empreinte carbone d’un ordinateur quantique dépasse largement celle des serveurs classiques, soulevant des questions environnementales légitimes. Cette réalité contraste avec le discours optimiste sur les capacités supposées illimitées de ces machines.

Les défis logistiques ne se limitent pas à l’équipement principal. Les installations nécessitent des bâtiments spécialement conçus avec des protections contre les vibrations, des blindages électromagnétiques et des systèmes de surveillance sophistiqués. L’approvisionnement en hélium liquide, ressource rare et coûteuse, pose des problèmes de chaîne logistique. Certains laboratoires explorent des alternatives comme les qubits fonctionnant à température plus élevée, mais ces recherches en sont à leurs débuts.

Applications concrètes : entre promesses et réalité du terrain

Les secteurs pharmaceutique et chimique figurent parmi les premiers bénéficiaires potentiels de l’informatique quantique. La simulation de molécules complexes dépasse rapidement les capacités des supercalculateurs classiques, car le nombre de configurations possibles croît exponentiellement avec la taille de la molécule. Un système quantique pourrait modéliser précisément les interactions atomiques, accélérant considérablement la découverte de nouveaux médicaments ou de catalyseurs efficaces. Cette perspective mobilise d’importants financements de la part des laboratoires pharmaceutiques.

Dans le domaine financier, l’optimisation de portefeuilles d’investissement complexes représente un cas d’usage séduisant. Les algorithmes quantiques pourraient analyser simultanément des millions de scénarios de marché, identifiant des opportunités inaccessibles aux méthodes traditionnelles. Les institutions bancaires suivent attentivement ces développements, certaines établissant des partenariats avec des entreprises spécialisées. Toutefois, la nature probabiliste des résultats quantiques soulève des interrogations sur leur applicabilité dans un contexte réglementaire strict.

La cryptographie constitue un enjeu stratégique majeur, avec des implications contradictoires. D’un côté, les ordinateurs quantiques menacent les systèmes de chiffrement actuels en rendant obsolètes certains protocoles de sécurité. De l’autre, ils permettent le développement de nouvelles méthodes de communication ultra-sécurisées basées sur l’intrication quantique. Les agences gouvernementales investissent massivement dans la « cryptographie post-quantique » pour anticiper ces bouleversements. La migration vers ces nouveaux standards prendra des années et coûtera des milliards.

| Secteur | Application envisagée | Avantage attendu | Horizon temporel |

|---|---|---|---|

| Pharmacie | Simulation moléculaire | Accélération de la découverte | 5-10 ans |

| Finance | Optimisation de portefeuilles | Meilleure gestion des risques | 3-7 ans |

| Logistique | Optimisation des routes | Réduction des coûts | 5-8 ans |

| Intelligence artificielle | Apprentissage quantique | Amélioration des modèles | 7-12 ans |

Les applications militaires et de renseignement demeurent largement confidentielles mais mobilisent des ressources considérables. Le décryptage de communications adverses, la simulation de systèmes d’armement ou l’optimisation de réseaux de défense figurent parmi les priorités stratégiques. Cette dimension sécuritaire alimente une course technologique entre grandes puissances, avec des investissements publics massifs souvent non divulgués. La frontière entre recherche civile et militaire reste floue dans ce domaine sensible.

- Modélisation du comportement de matériaux supraconducteurs pour l’énergie

- Prévision météorologique à long terme avec modèles climatiques avancés

- Conception de batteries plus performantes pour véhicules électriques

- Optimisation des chaînes logistiques mondiales en temps réel

- Découverte de nouveaux composés pour capturer le CO2 atmosphérique

- Amélioration des algorithmes de compression de données

Les services cloud quantiques : une démocratisation progressive

Les grandes entreprises technologiques proposent désormais un accès à distance à leurs systèmes quantiques via des plateformes cloud. Cette approche permet aux chercheurs et développeurs d’expérimenter sans investir dans des infrastructures coûteuses. Google, IBM et Amazon proposent des environnements de programmation simplifiés avec des bibliothèques d’algorithmes prêtes à l’emploi. Ces services démocratisent progressivement l’accès à cette technologie autrefois réservée aux laboratoires d’élite.

Les tarifications restent néanmoins prohibitives pour les petites structures. Les coûts d’utilisation se chiffrent en centaines de dollars par heure de calcul, limitant l’expérimentation aux projets disposant de budgets conséquents. Des programmes académiques offrent des crédits gratuits aux universités, favorisant l’émergence d’une nouvelle génération de spécialistes. Cette stratégie vise à créer un écosystème de développeurs capable de concevoir les applications de demain.

La qualité et la disponibilité des services cloud quantiques varient considérablement selon les fournisseurs. Les temps d’attente pour accéder aux machines peuvent atteindre plusieurs semaines durant les périodes de forte demande. Les performances réelles diffèrent souvent des spécifications annoncées, créant des frustrations parmi les utilisateurs. Les interfaces de programmation manquent encore de standardisation, obligeant les développeurs à apprendre des langages spécifiques à chaque plateforme. Ces frictions ralentissent l’adoption et compliquent la portabilité des applications.

Le fossé entre annonces médiatiques et réalité scientifique

Les communiqués de presse des entreprises technologiques amplifient systématiquement l’importance de leurs découvertes. Cette tendance au sensationnalisme crée une distorsion entre les avancées réelles et leur perception publique. Les journalistes, souvent peu familiers avec les subtilités techniques, relaient ces annonces sans analyse critique approfondie. Le résultat produit un cycle d’enthousiasme excessif suivi de désillusion lorsque les applications concrètes tardent à se matérialiser. Ce phénomène n’est pas nouveau : il rappelle les cycles d’emballement observés autour de l’innovation technologique à travers l’histoire.

Les publications scientifiques racontent une histoire plus nuancée. Les articles soumis à l’examen par les pairs révèlent les limitations expérimentales et les incertitudes que les communiqués marketing omettent soigneusement. La reproductibilité des résultats pose problème dans certains cas, avec des expériences difficiles à dupliquer en dehors du laboratoire d’origine. Cette situation génère des débats vigoureux au sein de la communauté scientifique, certains chercheurs accusant leurs pairs de sacrifier la rigueur sur l’autel de la visibilité médiatique.

Les délais de développement se révèlent invariablement plus longs que les prévisions initiales. Les feuilles de route ambitieuses annoncées en grande pompe subissent régulièrement des ajustements discrets. Les obstacles techniques imprévus surgissent à chaque étape, rappelant que la recherche fondamentale ne suit pas un calendrier marketing. Cette réalité frustre les investisseurs en quête de retours rapides et alimente le scepticisme du grand public envers les promesses technologiques.

| Annonce type | Formulation marketing | Réalité technique | Impact réel |

|---|---|---|---|

| Suprématie quantique | Supériorité absolue démontrée | Avantage sur tâche spécifique | Limité à des cas précis |

| Révolution imminente | Applications dans 2-3 ans | Prototypes fonctionnels | Commercialisation lointaine |

| Percée majeure | Problème résolu définitivement | Amélioration incrémentale | Progrès significatif mais partiel |

| Ordinateur quantique universel | Machine polyvalente disponible | Système spécialisé expérimental | Fonctionnalités restreintes |

Les experts indépendants appellent à la prudence face aux affirmations spectaculaires. Plusieurs physiciens renommés ont publiquement critiqué le battage médiatique entourant certaines annonces, soulignant l’écart entre les démonstrations de principe et les applications pratiques. Ils insistent sur la nécessité de maintenir des standards rigoureux de validation expérimentale et de transparence dans la communication des résultats. Cette vigilance critique constitue un garde-fou essentiel contre les dérives commerciales.

- Vérification indépendante des résultats par des laboratoires tiers

- Publication complète des protocoles expérimentaux et données brutes

- Distinction claire entre démonstrations de laboratoire et produits commerciaux

- Communication transparente sur les limitations et défis restants

- Évaluation réaliste des délais de développement technologique

- Contextualisation des avancées par rapport à l’état de l’art global

Les enjeux économiques et les bulles spéculatives

Les investissements dans les startups quantiques ont explosé ces dernières années, créant un écosystème financier dynamique mais fragile. Les valorisations atteignent des niveaux vertigineux pour des entreprises n’ayant encore généré aucun revenu commercial. Cette situation évoque les bulles technologiques passées, avec des capitaux abondants poursuivant des promesses lointaines. Certains fonds spécialisés misent sur une diversification large, pariant que quelques succès compenseront les nombreux échecs inévitables.

Les gouvernements compliquent l’équation en injectant des subventions massives dans les programmes nationaux. Ces financements publics faussent parfois les signaux de marché, maintenant artificiellement en vie des projets peu viables. La dimension stratégique du quantique justifie selon les décideurs politiques ces interventions, même en l’absence de perspectives commerciales claires. Cette approche soulève des questions sur l’allocation optimale des ressources de recherche et développement.

Les rachats et consolidations commencent à restructurer le paysage industriel. Les géants technologiques absorbent les startups prometteuses, concentrant l’expertise au sein de quelques acteurs dominants. Cette dynamique suscite des inquiétudes sur la concurrence et l’accessibilité future de ces technologies. Les partenariats stratégiques se multiplient, créant des alliances complexes entre entreprises traditionnellement rivales. Le secteur quantique pourrait ainsi reproduire les structures oligopolistiques observées dans d’autres domaines technologiques.

Les perspectives d’évolution et alternatives technologiques

Les approches alternatives à l’informatique quantique universelle gagnent en crédibilité. Les simulateurs quantiques, machines spécialisées dans des tâches précises, offrent une voie pragmatique vers des applications utiles. Ces systèmes sacrifient la polyvalence au profit de la fiabilité et de la simplicité opérationnelle. Plusieurs laboratoires ont démontré des résultats probants dans la simulation de systèmes physiques spécifiques, validant cette stratégie incrémentale. Cette philosophie contraste avec la quête du graal d’un ordinateur quantique universel capable de surpasser les machines classiques sur tous les fronts.

Les architectures hybrides combinant calcul classique et quantique représentent probablement la réalité pratique à moyen terme. Ces systèmes exploitent les forces de chaque paradigme, déléguant aux circuits quantiques uniquement les sous-problèmes où ils excellent. Cette division du travail maximise l’utilité réelle tout en contournant les limitations actuelles. Les développeurs conçoivent des algorithmes hybrides qui orchestrent élégamment ces ressources hétérogènes. L’avenir pourrait ressembler davantage à une coopération entre technologies qu’à un remplacement radical.

Les progrès dans les technologies classiques compliquent le tableau. Les supercalculateurs traditionnels continuent de s’améliorer, relevant progressivement leur barre de performance. Les processeurs spécialisés pour l’intelligence artificielle offrent des alternatives compétitives pour certains problèmes. Les innovations en architecture matérielle repoussent les frontières du calcul conventionnel. Cette course parallèle réduit la fenêtre d’opportunité pour les applications quantiques, qui doivent constamment prouver leur avantage face à des concurrents en évolution rapide.

| Approche technologique | Avantages principaux | Limitations actuelles | Maturité estimée |

|---|---|---|---|

| Quantique universel | Polyvalence théorique maximale | Taux d’erreur élevés, scalabilité | 15-20 ans |

| Simulateurs quantiques | Applicabilité immédiate ciblée | Fonctionnalités restreintes | 3-5 ans |

| Hybride classique-quantique | Pragmatisme et fiabilité | Complexité d’orchestration | 5-8 ans |

| Quantique photonique | Température ambiante possible | Contrôle et détection difficiles | 10-15 ans |

La diversification géographique des efforts de recherche enrichit le paysage des possibles. L’Europe mise sur les communications quantiques sécurisées, la Chine sur les réseaux de distribution de clés quantiques, tandis que l’Amérique du Nord privilégie le calcul pur. Ces priorités différenciées reflètent des contextes stratégiques et industriels variés. Les collaborations internationales permettent de mutualiser les investissements sur les infrastructures les plus coûteuses, tout en maintenant une compétition stimulante sur les aspects applicatifs.

- Développement de qubits photoniques fonctionnant à température ambiante

- Exploration de matériaux topologiques naturellement protégés contre les erreurs

- Conception de compilateurs optimisant automatiquement les circuits quantiques

- Création de standards industriels pour l’interopérabilité des systèmes

- Formation massive de spécialistes via des programmes universitaires dédiés

- Établissement de benchmarks rigoureux pour comparer objectivement les performances

Les implications sociétales et éthiques à anticiper

L’émergence des ordinateurs quantiques fonctionnels posera des questions éthiques inédites. La capacité théorique à briser les chiffrements actuels menace la confidentialité des communications privées et professionnelles. Les données sensibles stockées aujourd’hui pourraient devenir accessibles rétrospectivement une fois la technologie mature. Cette perspective inquiétante pousse certains États à légiférer préventivement sur la conservation des données chiffrées. Le concept de « voler maintenant, déchiffrer plus tard » hante les responsables de la sécurité informatique.

L’accès inégal à ces technologies puissantes risque de creuser de nouveaux fossés numériques. Les nations et organisations disposant de capacités quantiques jouiront d’avantages stratégiques considérables dans de nombreux domaines. Cette asymétrie pourrait exacerber les tensions géopolitiques et créer des monopoles technologiques durables. Les débats sur la souveraineté numérique prennent une dimension nouvelle face à ces enjeux de puissance computationnelle. Les initiatives de recherche collaborative tentent de contrebalancer ces tendances centrifuges.

L’impact environnemental des infrastructures quantiques mérite une évaluation critique. La consommation énergétique colossale des systèmes actuels entre en contradiction avec les objectifs climatiques. Cette tension pourrait limiter le déploiement massif si des solutions plus économes ne sont pas trouvées. Les chercheurs explorent des architectures alternatives moins gourmandes, mais ces pistes restent exploratoires. Le bilan écologique global devra intégrer les bénéfices potentiels, comme l’optimisation des processus industriels ou la découverte de matériaux durables.

Quand les ordinateurs quantiques seront-ils réellement opérationnels pour le grand public?

Les ordinateurs quantiques accessibles au grand public ne seront probablement pas disponibles avant 15 à 20 ans minimum. Les systèmes actuels restent des prototypes de recherche nécessitant des conditions opératoires extrêmes. Les applications commerciales se développeront d’abord via des services cloud spécialisés pour professionnels avant toute démocratisation. Les défis de stabilité, de coût et de miniaturisation demeurent colossaux.

Les ordinateurs quantiques remplaceront-ils complètement les ordinateurs classiques?

Non, les ordinateurs quantiques ne remplaceront pas les systèmes classiques mais les compléteront pour des tâches spécifiques. Ils excellent dans certains calculs comme la factorisation ou la simulation quantique, mais restent inefficaces pour les opérations courantes. L’avenir verra probablement des architectures hybrides combinant les deux approches selon les besoins. Les ordinateurs traditionnels conserveront leur prédominance pour la majorité des applications quotidiennes.

Pourquoi les annonces de Google sur le quantique suscitent-elles du scepticisme?

Le scepticisme provient de l’écart entre les annonces spectaculaires et la réalité des applications concrètes. Les démonstrations de laboratoire exploitent souvent des problèmes artificiels sans utilité pratique. Les limitations techniques comme les taux d’erreur élevés et les conditions opératoires extrêmes restent rarement mentionnées dans les communiqués. Cette communication sélective crée des attentes irréalistes parmi le public et les investisseurs.

Quels secteurs bénéficieront en premier de l’informatique quantique?

Les secteurs pharmaceutique et chimique devraient bénéficier en premier grâce à la simulation moléculaire. La cryptographie et la cybersécurité connaîtront des bouleversements avec les nouveaux protocoles quantiques. L’optimisation logistique et financière représente également un domaine d’application précoce. Les applications militaires et de renseignement progressent rapidement mais restent largement confidentielles. L’horizon temporel varie entre 5 et 10 ans selon les domaines.

Les ordinateurs quantiques menacent-ils réellement la sécurité d’Internet?

Oui, les ordinateurs quantiques suffisamment puissants pourraient briser les systèmes de chiffrement actuels protégeant Internet. Les protocoles RSA et ECC deviendraient vulnérables face aux algorithmes quantiques comme Shor. Cette menace reste théorique à court terme car les machines actuelles manquent de puissance. La migration vers la cryptographie post-quantique est déjà en cours pour anticiper ce risque. Les standards de sécurité évoluent progressivement pour résister aux attaques quantiques futures.